Google anuncia novos recursos de pesquisa que te ajudarão a encontrar o que você não está procurando

A pesquisa do Google é, sem dúvida, a maneira mais fácil de encontrar respostas rapidamente — e também pode gerar novas perguntas.

Às vezes, essas perguntas são geradas por uma sugestão de preenchimento automático aleatório. Mas a empresa acaba de anunciar mudanças em seu mecanismo de pesquisa que o ajudarão a encontrar respostas para perguntas que você não fez.

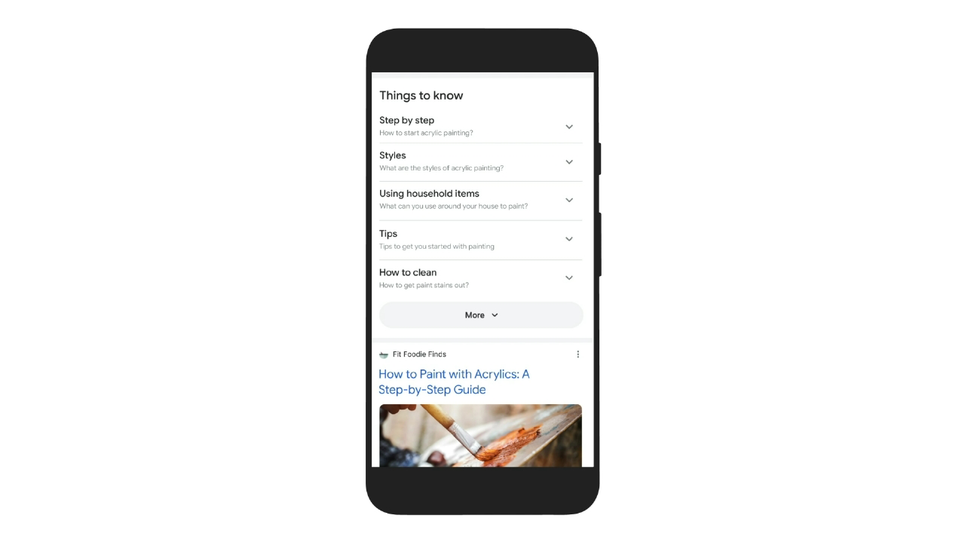

No evento Search On, desta quarta-feira (29), a Google anunciou vários novos recursos interessantes, que transformarão seu mecanismo de pesquisa em uma espécie de leitor de mentes. Isso inclui a ferramenta Google Lens (lente), que permitirá pesquisar com palavras e fotos, e um novo menu nomeado “Coisas para saber” — que fornecerá respostas a perguntas relacionadas à sua pesquisa.

Os novos recursos serão alimentados por um modelo de aprendizado de máquina chamado MUM, ou Modelo multitarefa unificado. Ele é capaz de coletar informações de formatos além do texto, incluindo imagens, áudio e vídeo. O MUM também pode transferir esse conhecimento para 75 idiomas.

Graças ao aprendizado de máquina, o Google agora pode incluir contexto fora dos termos de pesquisa baseados em texto padrão, o que pode ser útil se você não souber o que pesquisar e quais palavras ou frases usar.

Nos próximos meses, os resultados de pesquisa do Google começarão a exibir links relacionados ao que o usurário estava procurando, mas que talvez não tenha pensado.

Um dos exemplos que a empresa deu foi uma pesquisa por tinta acrílica: basta digitar o termo na barra de pesquisa e, em seguida, rolar para baixo até a seção chamada Coisas a saber.

O Google apresentará uma descrição da tinta acrílica e onde você pode comprá-la, com links sobre como usar tintas acrílicas, os estilos associados a esse tipo de pintura, dicas sobre técnica e como começar a trabalhar no ambiente desejado.

A inteligência artificial do Google tirará todas essas informações de resultados de pesquisa relevantes. É possível que o recurso Coisas a saber torne você menos propenso a clicar em links para encontrar mais informações se a pesquisa estiver teoricamente completa e organizada.

O Google Lens usará o aprendizado de máquina para permitir que você faça perguntas sobre fotos com pesquisa visual em tempo real.

Por exemplo, se você vir uma foto de um suéter, poderá usar o Lens para solicitar outros tipos de itens de roupa com o mesmo padrão.

No entanto, talvez a implementação mais prática desse recurso seja quando você procura ajuda para identificar algo específico, que não tem certeza de como colocar uma frase em uma pesquisa.

O Google demonstrou isso com a foto de uma bicicleta com um câmbio quebrado.

Basta apontar a câmera compatível com o Google Lens em direção à peça quebrada da bicicleta e, em seguida, perguntar ao Google como consertá-la — sem precisar identificar a peça pelo nome.

Esses recursos do Google Lens não estarão disponíveis até o início do próximo ano, e não está claro se eles serão incorporados ao aplicativo Google Lens ou no aplicativo câmera padrão de um telefone Android.

O Google também está usando o aprendizado de máquina para reconhecer momentos em um vídeo e identificar tópicos relacionados à cena.

Por exemplo, se você estiver assistindo a um vídeo sobre um animal específico não mencionado no título ou na descrição do vídeo, o Google poderá dizer qual é a espécie e mostrar links relacionados.

O Google diz que esse recurso específico será lançado nas próximas semanas, com mais “melhorias visuais” saindo nos próximos meses.

Encontrar imagens relacionadas logo será mais fácil com uma página de resultados de pesquisa de imagens recém-redesenhada. Isso deve tornar a busca por ideias de projetos e outras pesquisas relacionadas um pouco mais fácil

Mais duas mudanças básicas de pesquisa, não relacionadas ao aprendizado de máquina do Google, são opções para Refinar esta pesquisa e Ampliar esta pesquisa, que você pode escolher enquanto faz as buscas na Internet.

Isso o ajudará a ir além da sua pergunta original ou a reduzi-la. O Google disse que esses recursos serão lançados nos próximos meses.