Pesquisadora da Microsoft detalha perigos do viés algorítmico no mundo real

Por mais rapidamente que a inteligência artificial evolua, por mais rápida que seja sua entrada em nossas vidas — na saúde, na aplicação das leis, no sexo etc. —, ela não consegue superar os vieses de seus criadores, os humanos. Kate Crawford, pesquisadora da Microsoft e cofundadora da AI Now, deu uma palestra incrível, intitulada “O Problema com o Viés”, na conferência Neural Information Processing System, na Espanha, na terça-feira (5). Em sua apresentação, Crawford mostrou um detalhamento fascinante dos diferentes tipos de perigos causados pelos viéses algorítmicos.

Como ela explicou, a palavra “viés” tem, matematicamente, uma definição específica no machine learning, normalmente se referindo a erros em estimativas ou na subrepresentação/sobrerrepresentação de populações ao fazer amostragens. Menos discutido é o viés em termos do impacto desigual que o machine learning pode ter em diferentes populações. Existe um perigo real em ignorar este tipo de viés. Crawford detalha dois tipos de dano: o dano alocativo e o dano representativo.

“Um dano alocativo é quando um sistema distribui ou retém uma certa oportunidade ou recurso”, afirmou. É quando a inteligência artificial está acostumada a tomar uma certa decisão, digamos, nos pedidos de hipotecas, mas injusta ou erroneamente a nega a um certo grupo. Ela ofereceu o exemplo hipotético da inteligência artificial de um banco negando pedidos de hipotecas a mulheres. Então, ofereceu um exemplo surpreendente do mundo real: uma inteligência artificial de avaliação de risco rotineiramente considerou que criminosos negros eram um risco maior do que criminosos brancos (criminosos negros foram encaminhados para prisão preventiva mais frequentemente por causa dessa decisão).

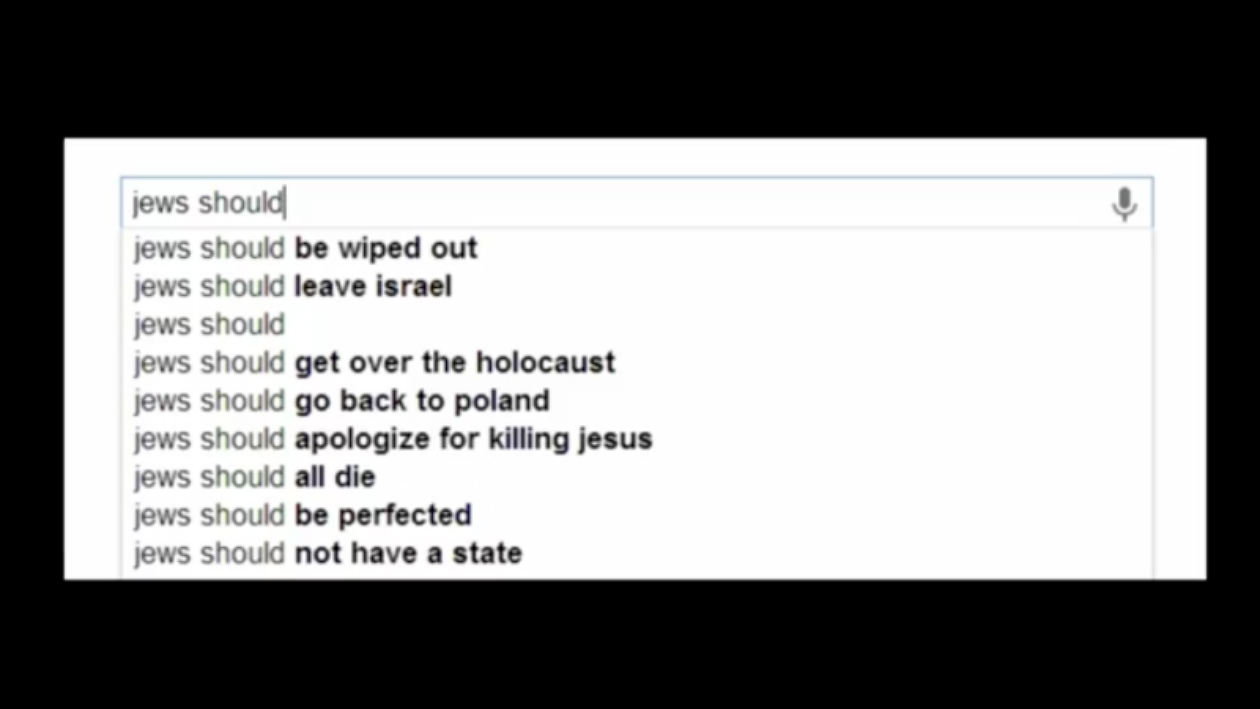

Danos representativos “acontecem quando sistemas reforçam a subordinação de alguns grupos ao longo das linhas de identidade”, disse Crawford — basicamente, quando a tecnologia reforça estereótipos ou diminui certos grupos específicos. “Esse tipo de dano pode acontecer independentemente de os recursos estarem sendo retidos ou não.” Exemplos incluem o Google Fotos marcando pessoas negras como “gorilas” (um estereótipo prejudicial que é historicamente usado para dizer que pessoas negras literalmente não são humanas) ou uma inteligência artificial presumindo que asiáticos estão piscando quando sorriem.

Crawford atrelou a relação completa entre os dois danos, citando um relatório de 2013 de LaTanya Sweeney. Sweeney apontou o padrão algorítmico em resultados de busca em que procurar um nome “que soasse negro” fazia surgir anúncios de verificação de antecedentes criminais. Em seu estudo, Sweeney argumentou que esse dano representativo de associar a negritude com criminalidade pode ter uma consequência alocativa: empregadores, ao buscar os nomes de candidatos a vagas, podem discriminar contra empregados negros porque os resultados de busca estão ligados a criminosos.

“A perpetuação de estereótipos de criminalidade negra é problemática mesmo que esteja fora de um contexto de contratação”, explicou Crawford. “Está produzindo um dano de como as pessoas negras são representadas e entendidas socialmente. Então, em vez de simplesmente pensar no machine learning contribuindo para a tomada de decisões em, digamos, situações de contratação ou justiça criminal, também precisamos pensar no papel do machine learning em representações prejudiciais de identidade.”

Resultados de sistemas de busca e anúncios online ambos representam o mundo em torno de nós, além de influenciarem-no. A representação online não fica só no online. Pode ter consequências econômicas reais, como argumenta Sweeney. Essa representação também não se originou online. Esses estereótipos de criminalidade/desumanidade já existem há séculos.

Durante sua palestra, Crawford entrou em detalhes sobre vários tipos de danos representativos, suas conexões com danos de alocação e, o mais interessante de tudo, as maneiras como diminuir seu impacto. Como é frequentemente sugerido, parece que uma solução rápida seria romper associações de palavras problemáticas ou remover dados problemáticos. Quando foi mostrado que a busca do Google Imagens tinha um padrão de viés de gênero, em 2015, mostrando quase que completamente homens quando usuários buscavam termos como “CEO” ou “executivo”, eles, em algum momento, retrabalharam o algoritmo de busca para que fosse mais equilibrado. Mas essa técnica tem suas preocupações éticas particulares também.

“Quem é que decide quais termos devem ser removidos e por que aqueles em particular?”, questionou Crawford. “E uma questão ainda maior é: de quem é a ideia de neutralidade em execução? Presumimos que neutro é o que temos no mundo hoje em dia? Se sim, como levamos em conta anos de discriminação contra subpopulações particulares?”

Crawford opta por abordagens interdisciplinares para questões de viés e neutralidade, usando a lógica e o raciocínio da ética, antropologia, estudos de gênero, sociologia, entre outros, repensando a ideia de que exista uma resposta única facilmente quantificável.

“Acho que este é exatamente o momento em que a ciência da computação está tendo que fazer perguntas muito maiores, porque estão exigindo dela coisas muito maiores.”

Imagem do topo: Apresentação ‘O Problema do Viés’, de Kate Crawford, na NIPS 2017