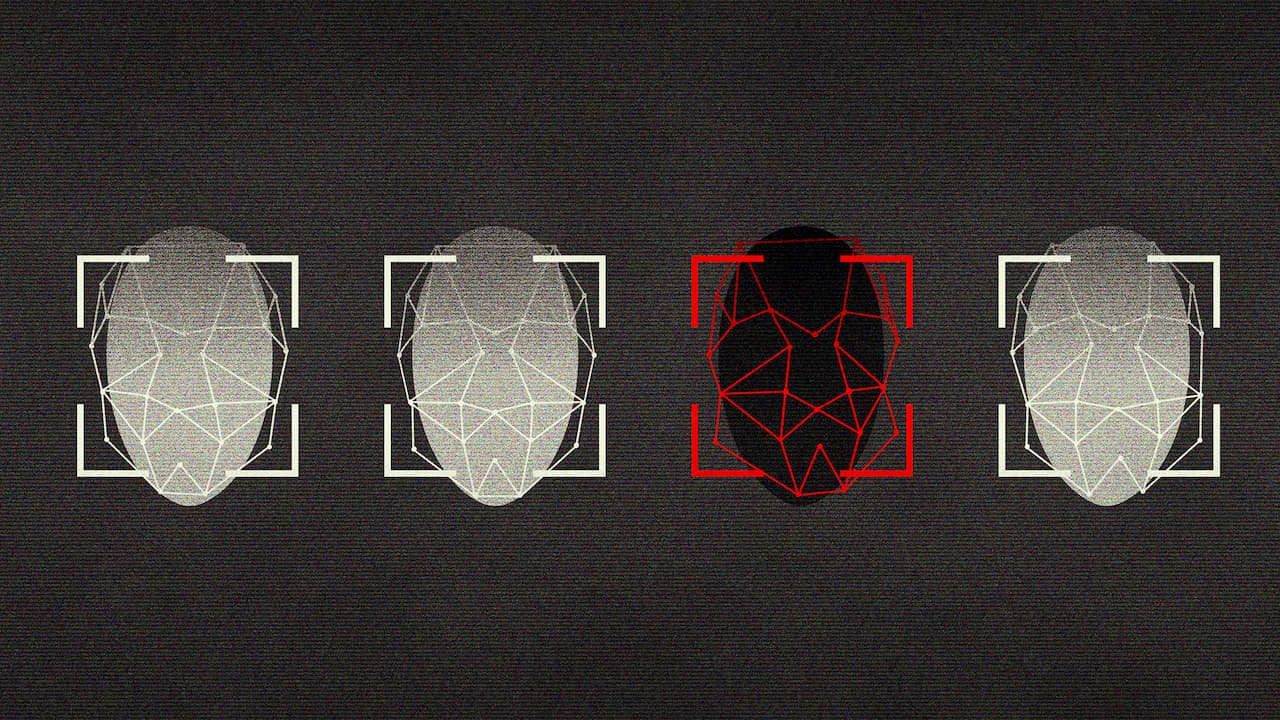

Para diversos especialistas, o reconhecimento facial não deveria ser utilizado por forças policiais e outras aplicações da lei. Esse argumento ganhou mais evidências ao seu favor, com a publicação de um estudo realizado pelo Instituto Nacional de Padrões e Tecnologias dos EUA (NIST).

O órgão avaliou centenas de algoritmos de identificação e reconhecimento facial e mostrou que existe enviesamento na maioria dos programas, e que o número de erros é maior entre negros, mulheres e indígenas. O estudo está disponível (em inglês) neste link.

“Embora geralmente seja incorreto fazer afirmações sobre os algoritmos, encontramos evidências empíricas da existência de diferenciais demográficos na maioria dos algoritmos de reconhecimento facial que estudamos”, disse Patrick Grother, cientista da computação do NIST e o principal autor do relatório, em um comunicado.

Grother disse que o relatório não explora a fundo o que pode causar o enviesamento, mas que “os dados são valiosos para legisladores, desenvolvedores e usuários finais que estão pensando sobre as limitações e o uso apropriado desses algoritmos.”

Como o estudo foi feito

O estudo foi conduzido por meio do programa de testes do NIST e avaliou algoritmos de reconhecimento facial que foram enviados pela indústria e por desenvolvedores acadêmicos. Não foram realizados testes nos produtos comerciais finalizados, mas nas soluções oferecidas pelos fornecedores. No total, foram 189 softwares de 99 desenvolvedores — que, segundo o NIST, representa a maior parte da indústria.

Foram analisados dois elementos principais dos algoritmos:

- A habilidade de confirmar se uma foto combina com uma foto diferente da mesma pessoa, uma tarefa conhecida como combinação “um para um” que geralmente é utilizada para fazer verificações, como desbloqueio de um smartphone, checagem de identidade de passaporte, entre outros;

- A habilidade de identificar de a foto de alguém tem alguma combinação possível dentro de um base de dados variada, conhecida como combinação “uma entre muitos”, geralmente utilizada para identificar uma pessoa, como em suspeitas de crimes.

Além disso, os pesquisadores fizeram duas avaliações:

- Falsos positivos, para quando o software considerava incorretamente fotos de duas pessoas diferentes como se fosse a mesma;

- Falsos negativos, quando o software falhava ao combinar duas fotos que, na verdade, eram da mesma pessoa.

Os falsos positivos são muito mais perigosos, uma vez que podem identificar incorretamente uma pessoa acusada de um crime, por exemplo. No campo dos negócios, pode facilitar as fraudes, também. Os falsos negativos também costumam ser corrigidos com uma segunda leitura.

O NIST utilizou quatro coleções de fotos que continham 18,2 milhões de imagens de 8,4 milhões de pessoas, vindas de bases de dados do Departamento de Estado dos EUA, Departamento de Segurança Nacional dos EUA e o FBI. Os pesquisadores ressaltam que não foram utilizadas imagens retiradas da internet, nem de câmeras de vigilância. Além disso, todas essas imagens incluem metadados que indicavam a idade, sexo, raça e país de nascimento — isso foi importante para que eles conseguissem avaliar como cada algoritmo se saía perante a cada grupo social.

O enviesamento

Foi justamente com esses metadados que o estudo identificou que há taxas maiores de falsos positivos em verificações “um para um” para rostos de pessoas asiáticas e afro-americanos, em comparação a pessoas caucasianas. Um dos dados mais preocupante é a taxa de erro, que variou de 10 a 100 vezes, dependendo do algoritmo.

Algoritmos desenvolvidos por empresas americanas tinham taxas similares de falsos positivos para verificações “um para um” para asiáticos, afro-americanos e grupos nativos (como indígenas e nativos da região das ilhas do pacífico). Os indígenas americanos tiveram as maiores taxas de falso positivo nesse caso.

Já algoritmos desenvolvidos por empresas asiáticas apresentaram menos falsos positivos em verificações “um para um” entre faces asiáticas e caucasianas. Isso provavelmente se deve ao fato de empresas asiáticas usarem bases de dados mais diversas para treinar seus algoritmos.

Grother disse que o estudo do NIST não explorou as relações entre causa e efeito, mas disse que “esses resultados são um sinal encorajador de que dados de treinamento mais diversificados podem produzir resultados mais equitativos, caso seja possível aos programadores utilizar tais dados.”

As verificações “uma entre muitos” mostraram taxas maiores de falsos positivos para mulher afro-americanas, o que levanta preocupações em relação ao uso dessas tecnologias para a segurança e a justiça. Uma taxa maior de falso positivos pode representar acusações injustas.

O comunicado do NIST reforça que nem todos os algoritmos apresentaram taxas altas de falso positivos entre diferentes grupos demográficos nos algoritmos que fazem leituras “uma entre muitos”. A conclusão, no entanto, é importante: algoritmos diferentes tem performances diferentes.

Foram avaliados softwares de empresas como Intel, Microsoft, Panasonic, SenseTime, entre outras. O Washington Post destacou que a Amazon não estava na lista — a companhia desenvolve o Rekognition, um algoritmo que recebeu duras críticas recentemente — e o NIST disse que a empresa não enviou o seu produto para a avaliação, mas que os testes ainda estão abertos.

Segurança pública e vigilância permanente

Diversas cidades dos Estados Unidos decidiram proibir o uso de reconhecimento facial por autoridades públicas, entre elas San Francisco, Oakland, Somerville e Brookline, além do estado da Califórnia, que baniu esse tipo de software em câmeras corporais da polícia. No Brasil, essas soluções já estão sendo utilizadas em 37 cidades, em pelo menos 13 para fins de segurança pública, incluindo Campinas, Salvador e Rio de Janeiro. As discussões sobre a validade do uso são incipientes e os projetos de lei costumam propor a ampliação da aplicação.

O reconhecimento facial é visto como uma solução mágica para a segurança pública, já que, em tese, poderia identificar rapidamente pessoas que são procuradas pela polícia. O índice de erros dos softwares, no entanto, apontam que essa não é uma solução definitiva e pode ampliar injustiças.

Além disso, a linha entre o uso dos sistemas de reconhecimento facial para segurança pública e para a vigilância permanente da população e a perseguição de determinados grupos étnicos pode ser rompida a qualquer momento. De acordo com o New York Times, o governo chinês está usando a tecnologia para rastrear os uigures, a minoria muçulmana do país. Os manifestantes pró-democracia de Hong Kong temem, por exemplo, que a China utilize o reconhecimento facial para reprimi-los e puni-los — o governo chegou a banir máscaras e pinturas faciais em mais uma tentativa de frear as manifestações. Há preocupações em outros países, como na Índia, onde os sistemas estão se ampliando rapidamente e há uma divisão forte entre religiões.