Siri dá resposta explícita quando questionada para definir a palavra “mãe” em inglês

De tempos em tempos, alguém descobre respostas bizarras dadas pela assistente Siri. No entanto, usuários do iPhone perceberam uma que talvez seja a mais estranha — e definitivamente a mais explícita.

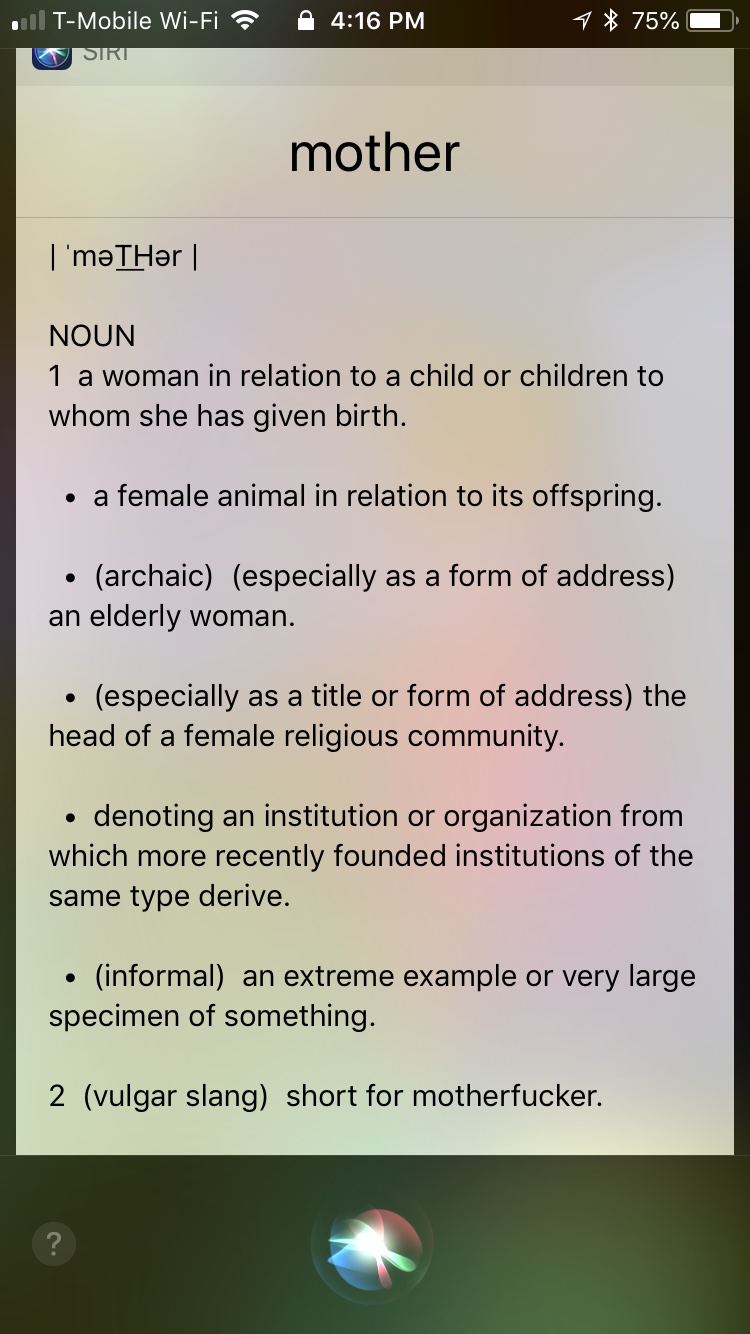

Funciona assim: acione a Siri no seu iPhone ou no Mac e peça para ela “definir a palavra mãe” em inglês. A Siri vai ler a primeira definição e perguntar se você quer que ela leia a segunda. Ao dizer sim, ela vai ler uma definição não muito polida.

• Ex-funcionários da Apple dizem que Siri foi lançada prematuramente e relatam “bagunça” no projeto

• Um menino de quatro anos usou a Siri para salvar a vida de sua mãe desacordada

“Como um substantivo, significa a abreviação de motherfucker” [filho da puta, em tradução livre].

A resposta inesperada, vista primeiro pelo pessoal do Reddit no r/Apple, parece funcionar em todos os dispositivos iOS, do iPhone 5s ao iPhone X, passando também por iPads e computadores que rodam macOS. Funciona até com a Siri em inglês australiano.

Aparentemente, a Siri pega a definição do Oxford Dictionary, que oferece a resposta “motherfucker” como a segunda definição da palavra “mother”. Ao tocar na opção “mais” quando a Siri exibe o resultado, a opção “abreviação para motherfucker”, de fato, aparece na lista de respostas.

Captura de tela do iPhone 7

O Oxford Dictionary oferece quatro sub-definições de “mother” que seriam muito mais usadas, mas a Siri vai na opção “gíria vulgar”, no caso a segunda sub-definição, sem nenhum tipo de aviso.

Fazer a Siri dizer palavrões é o hobby de alguns fanáticos pela Apple, e há várias formas de enganar a assistente de voz — o que, para ser bem sincero, é legal por apenas 45 segundos.

No entanto, a Siri não vai gostar se você falar palavrões! Ela vai te repreender e pedir que você seja mais educado — o que é uma posição razoável para uma assistente de inteligência artificial fazer.

Sheryl Branham, um membro do Departamento de Sistemas de Informação Computacional da Universidade do Estado do Missouri, estima que entre 10 e 50% das interações humanas com inteligência artificial são abusivas. As estimativas parecem altas até você se lembrar de como transformaram o chatbot Tay da Microsoft em nazista em apenas um dia.

A Siri é, sem dúvida, a assistente inteligente mais limitada entre as competidoras (embora todas sejam ruins) e honestamente, ela está só lendo a informação do Oxford Dictionary, então não é totalmente culpa dela nesse caso. Você pode ter certeza que a Apple deve consertar isso muito em breve. Enquanto isso, você pode colocar a Siri em inglês e forçar a assistente a falar palavrões.

[Ars Technica e Reddit]

Imagem do topo: Apple