Pesquisadores criaram um trato vocal virtual computadorizado capaz de criar falas inteligíveis. Ele usa como base sinais cerebrais associados com os aspectos mecânicos da fala, como movimentos da mandíbula, lábios e língua. O sistema poderia eventualmente ser usado por pessoas que perderam a capacidade de falar.

Dispositivos geradores de fala convencionais, como o usado pelo finado Stephen Hawking, costumam usar movimentos não verbais, como pequenas contrações das pálpebras ou da cabeça, para produzir palavras. Os usuários precisam soletrar cada palavra, letra por letra, o que demanda tempo e esforço.

Na melhor das hipóteses, esses dispositivos auxiliares produzem palavras a uma velocidade entre seis e dez palavras por minuto. Isso é muito longe da fala natural, que produz de 100 a 150 palavras por minuto.

Para pessoas que perderam a capacidade de falar, seja por Parkinson, ELA, acidente vascular ou outra lesão cerebral, os dispositivos geradores de fala convencionais são bons, mas não ótimos. Em um esforço para criar algo mais eficiente, uma equipe de pesquisa liderada por Gopala Anumanchipalli, da Universidade da Califórnia em San Francisco (UC San Francisco), desenvolveu um sistema que se conecta diretamente ao cérebro e simula os aspectos mecânicos da fala verbal.

O sistema coleta e mapeia os sinais cerebrais que acionam os movimentos da mandíbula, laringe, lábios e língua. Um computador decodifica esses sinais para produzir frases inteligíveis com um sintetizador de fala. Em uma coletiva de imprensa realizada ontem, os pesquisadores descreveram o novo dispositivo como um “trato vocal virtual”. Os detalhes deste trabalho foram publicados nesta quinta-feira (25) na revista Nature.

Este novo dispositivo é o segundo a aparecer este ano que usa sinais cerebrais para produzir fala. Em janeiro, uma equipe liderada pelo neurocientista Nima Mesgarani, da Universidade de Columbia, criou um sistema que captura os sinais cerebrais de uma pessoa ao ouvir palavras. Estes sinais são, então, decodificados usando aprendizagem de máquina para produzir a fala sintetizada.

A abordagem adotada pelos pesquisadores da Universidade da Califórnia em San Francisco é um pouco diferente. Também envolve sinais cerebrais, mas, em vez de decodificar os sons ouvidos, decodifica os sinais cerebrais responsáveis pela fala verbal.

É importante ressaltar que nenhum sistema coleta a fala secreta ou imaginária de uma pessoa — as palavras que dizemos a nós mesmos dentro de nossas cabeças. A ciência e a tecnologia atuais não estão nem perto desse nível de sofisticação. Essas novas abordagens ainda utilizam sinais cerebrais, mas aqueles que têm a ver com atividade neural no córtex sensorial (percepção de fala, como no sistema Mesgarani) ou atividade neural no córtex motor (produção da fala, como no novo dispositivo).

Para criar o trato vocal virtual, Anumanchipalli e seus colegas recrutaram cinco pacientes que deveriam passar por uma cirurgia no cérebro para tratar a epilepsia. Nenhum dos participantes tinha problemas com a produção de fala verbal, e todos eram falantes nativos de inglês.

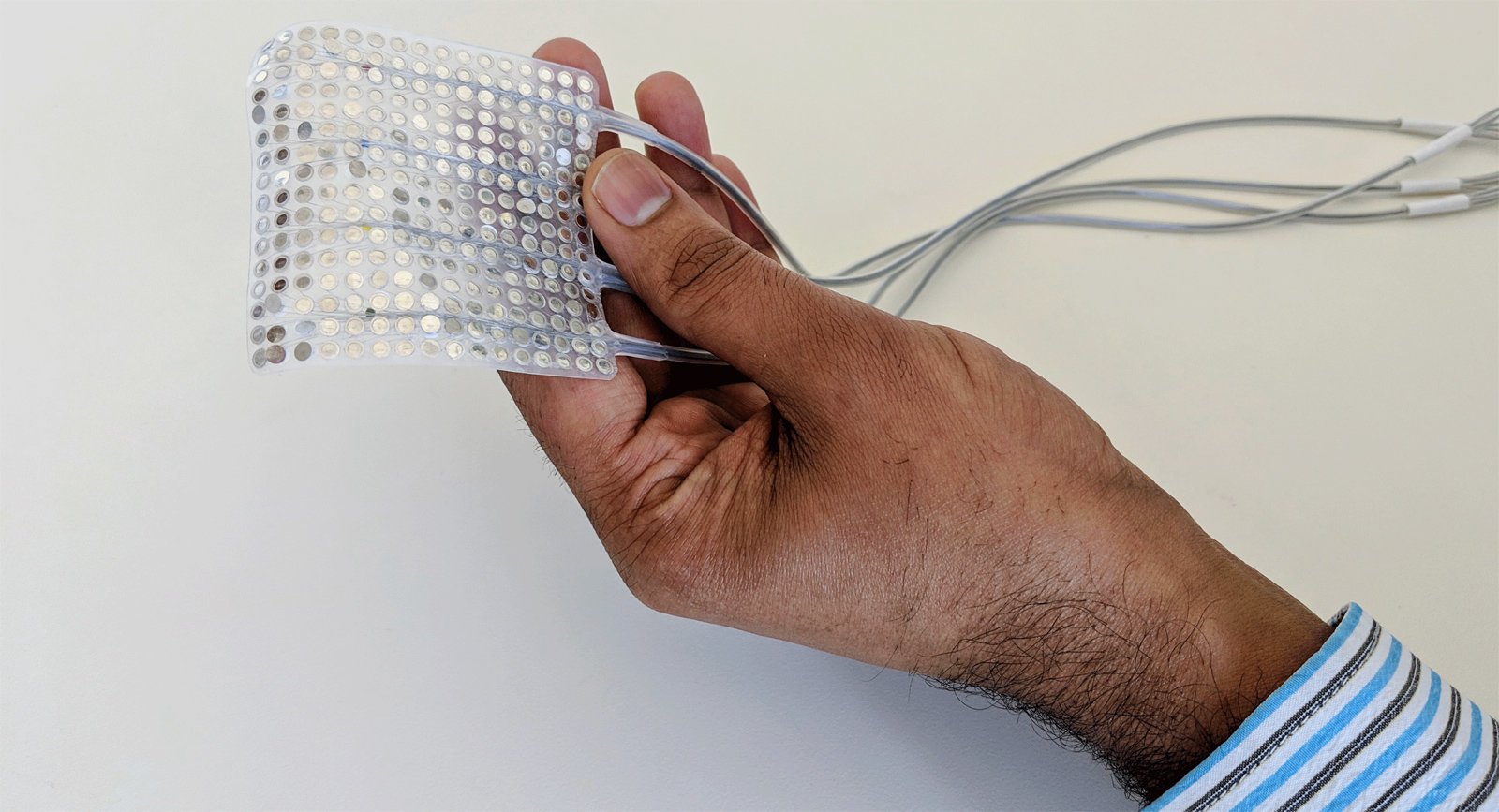

Cirurgiões implantaram matrizes de eletrodos diretamente nos cérebros desses pacientes, especificamente as áreas associadas à produção da linguagem. Os pacientes, então, falavam centenas de frases em voz alta, enquanto os pesquisadores registravam a atividade cortical associada.

Ao longo dos meses que se seguiram, esses dados foram decodificados e ligados a movimentos específicos do trato vocal. De certa forma, os pesquisadores fizeram uma engenharia reversa da mecânica da fala verbal, mapeando as várias maneiras pelas quais os sons são produzidos — por exemplo, pela língua no céu da boca ou pelo aperto das cordas vocais.

Um algoritmo de aprendizagem de máquina decodificou esses sinais, permitindo que um sintetizador de fala inteligente convertesse e expressasse os sinais como fala audível. O resultado foi um trato vocal virtual baseado em computador que, em teoria, poderia ser controlado pela atividade cerebral.

Para transformar a teoria em ação, os pesquisadores, então, testaram o sistema em um voluntário que estava conectado ao sistema, com eletrodos intracranianos e tudo mais. A pessoa foi instruída a falar em voz alta e a fazer os movimentos da fala ou apenas imaginá-los, sem emitir sons. O último método, conhecido como fala subvocal, foi feito para simular uma pessoa que perdeu a capacidade de falar, mas ainda está familiarizada com os aspectos mecânicos da fala.

Alimentado com esses dados, o trato vocal virtual foi capaz de produzir fala verbal com uma clareza surpreendente. Ambos os métodos resultaram em fala inteligível, embora a fala verbal fosse um pouco melhor que a fala subvocal.

Nos testes de acompanhamento, um painel de várias centenas de falantes nativos de inglês foi recrutado para decifrar a fala sintetizada. Os participantes do painel receberam um conjunto de palavras para escolher e disseram para selecionar a melhor combinação. Nos testes, cerca de 70% das palavras foram transcritas corretamente. Muitas das palavras que os participantes erravam eram termos próximos, como, por exemplo, “rodent” (roedor) com “rabbit” (coelho).

“Ainda há muito caminho a percorrer até chegar a uma imitação perfeita da linguagem falada”, disse Josh Chartier, coautor do novo estudo, em um comunicado. “Somos muito bons em sintetizar sons de fala mais lentos como ‘sh’ e ‘z’, bem como manter os ritmos e entonações da fala, o gênero e a identidade do locutor, mas alguns dos sons mais abruptos como ‘b’ e’ p’ ainda ficam um pouco confusos. Ainda assim, os níveis de precisão que produzimos aqui seriam uma melhoria incrível na comunicação em tempo real em relação ao que está atualmente disponível.”

Como observado, o sistema é projetado para pacientes que perderam a capacidade de falar. Na conferência de imprensa realizada nesta quarta-feira (24), Edward Chang, coautor do estudo, disse que ainda é “uma questão em aberto” se o sistema pode ser usado por pessoas que nunca foram capazes de falar, como pacientes com paralisia cerebral. É “algo que terá que ser estudado no futuro”, disse ele, “mas estamos esperançosos”, acrescentando que “a fala teria que ser aprendida de baixo para cima”.

Uma limitação importante deste trato vocal virtual é a necessidade de cirurgia cerebral e implantes cranianos para personalizar o sistema para cada pessoa. Até onde os cientistas conseguem prever, isso continuará sendo invasivo, já que não existem atualmente dispositivos tecnológicos capazes de coletar a resolução necessária fora do cérebro.

“Este estudo representa um passo importante para a atualização das tecnologias de neuroprótese de fala”, disse Mesgarani ao Gizmodo por e-mail. Ele é o autor do estudo que noticiamos em janeiro e não esteve envolvido na nova pesquisa.

“Uma das principais barreiras para esses dispositivos tem sido a baixa inteligibilidade do som sintetizado. Usando os avanços mais recentes em métodos de aprendizado de máquina e tecnologias de síntese de fala, este estudo e o nosso mostram uma melhora significativa na inteligibilidade da fala decodificada. Ainda não sabemos qual abordagem será melhor para decodificar a fala imaginada, mas é provável que um híbrido dos dois seja o melhor.”

De fato, um aspecto interessante deste campo é a grande velocidade de desenvolvimento e a aplicação de diferentes técnicas. Como Mesgarani apontou, é possível que várias abordagens sejam combinadas em um único sistema, levando potencialmente a resultados de fala mais precisos.

Como um comentário especulativo final, essas interfaces cérebro–computador poderiam ser usadas, algum dia, para produzir uma forma de telepatia tecnológica, ou comunicação mente a mente.

Imagine, por exemplo, um dispositivo como o desenvolvido pelos pesquisadores da UC San Francisco, mas com o sintetizador de fala conectado diretamente ao córtex auditivo de uma pessoa receptora, semelhante a um implante coclear (o córtex auditivo está associado à audição).

Com os dois elementos interligados através da rede sem fio, duas pessoas interconectadas poderiam teoricamente se comunicar apenas fazendo a mímica silenciosa dos movimentos de fala ou até mesmo só imaginando esses movimentos. Somente elas seriam capazes de ouvir as palavras uma da outra.

Mas estou indo muito adiante em relação a essa pesquisa mais recente. O mais importante é que o novo sistema poderia eventualmente ser usado para ajudar pacientes com esclerose lateral amiotrófica, esclerose múltipla, acidente vascular cerebral e traumatismo cranioencefálico a recuperar a capacidade de falar. E, como os pesquisadores sugeriram, poderia até mesmo dar voz a indivíduos que nunca tiveram essa possibilidade.