Universitários adaptam chip do Google para dar ao seu computador o sentido de tato

O Project Soli, anunciado na conferência Google I/O de 2015, é um pequeno chip que utiliza um radar para detectar movimentos discretos da mão e dos dedos. Ele foi projetado como uma forma diferente de se interagir com dispositivos móveis, mas estudantes da Universidade de St. Andrews (Reino Unido) encontraram uma maneira de usá-lo para dar tato a dispositivos eletrônicos.

• Tecnologia da Microsoft permite interagir com a tela do smartphone sem tocar nela

• Engenheiro quer melhorar tecnologias touch para acabar com toques não desejados

O chip, desenvolvido pelo ATAP – Grupo de Projetos e Tecnologias Avançadas do Google – usa o mesmo tipo de radar empregado por aeroportos para acompanhar aviões que chegam e partem.

À medida que ondas de rádio saltam da sua mão de volta para o chip do Project Soli, ele detecta sinais únicos que podem ser usados para decifrar até mesmo o mais ínfimo dos movimentos.

Mas estudantes de ciência da computação em St. Andrews – incluindo Hui-Shyong Yeo, Gergely Flamich, Patrick Schrempf, David Harris-Birtill e Aaron Quigley – descobriram que diferentes materiais também produzem sinais únicos, e através do aprendizado de máquina, um computador pode determinar o que o chip do Project Soli está tocando.

Cobre, madeira, bandeja de plástico, copo vazio, e copo com água

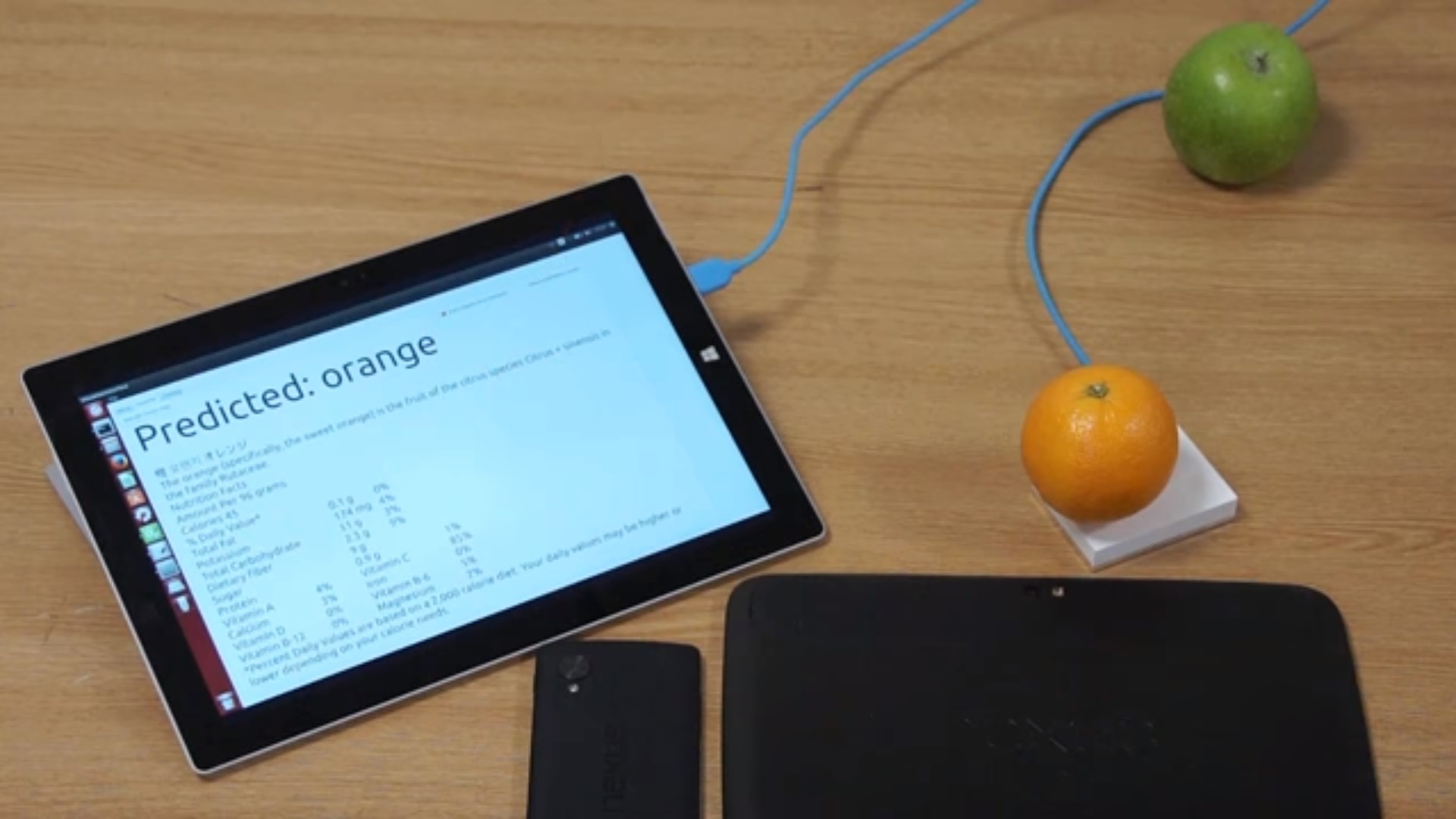

O projeto, chamado RadarCat, vai além de descobrir o material do qual um objeto é feito – metal, plástico ou madeira, por exemplo. Na demonstração em vídeo, vemos o software identificar corretamente um copo vazio, e também reconhecer quando esse mesmo copo está sendo preenchido com água.

Ele nem sempre consegue fazer uma previsão precisa quando confrontado com um novo material, mas o uso do aprendizado de máquina significa que ele pode melhorar ao longo do tempo por meio de interações futuras.

O hardware do Project Soli não é pequeno o suficiente para caber dentro de um smartphone por enquanto, mas existem aplicações úteis para o RadarCat em sua forma atual.

Por exemplo, em vez de depender apenas de câmeras de alta velocidade para classificar resíduos em um local de reciclagem, as máquinas poderiam sentir o objeto para determinar do que ele é feito, e como ele deve ser encaminhado.

O potencial desta tecnologia para melhorar a forma como os robôs interagem com o mundo também é muito empolgante. Eles poderiam saber imediatamente quando estão tocando pele humana, e assim precisam ser mais suaves para evitar lesões. Ou, se eles pegarem um objeto de metal que é provavelmente pesado, eles já se preparariam ao tentar levantá-lo.

A tecnologia RadarCat será demonstrada este mês na conferência 2016 ACM Symposium on User Interface Software and Technology, em Tóquio.