Carros autônomos não sabem escolher quem matar em situações extremas, mas as pessoas têm várias opiniões

Já foi descoberto em pesquisas anteriores que as pessoas, geralmente, prefeririam minimizar as mortes em um potencial acidente envolvendo carros autônomos. Mas o que acontece quando as pessoas são colocadas diante de cenários mais complexos? E o que acontece quando os veículos autônomos precisam escolher entre dois cenários em que pelo menos um indivíduo pode morrer? Quem esses veículos poderia salvar e com base em que eles fariam esses julgamentos éticos?

• Motorista de Uber autônomo que atingiu ciclista estava vendo The Voice durante acidente fatal

Isso pode soar como uma versão macabra do jogo “você preferiria”, mas pesquisadores dizem que tais experimentos mentais são necessários para a programação de veículos autônomos e para as políticas que os regulam. Além disso, as respostas em torno desses ultimatos difíceis podem variar entre culturas, revelando que não há universalidade naquilo que as pessoas acreditam ser a opção moralmente superior.

Em um dos maiores estudos desse tipo, pesquisadores do MIT Media Lab e de outras instituições apresentaram variações desse enigma ético para milhões de pessoas, em dez idiomas e em 233 países e territórios, em um experimento chamado “Máquina Moral” (que você pode fazer; tem até versão em português), cujos resultados foram publicados nesta semana na Nature.

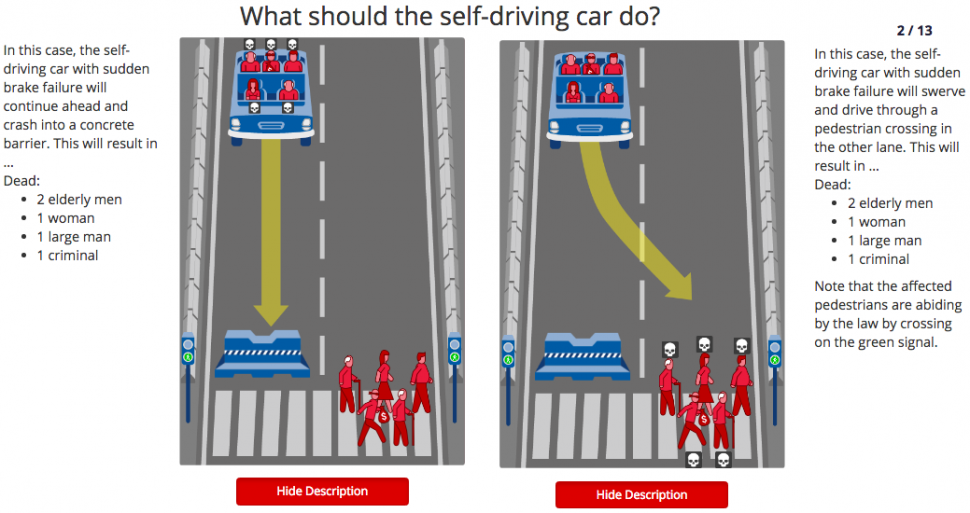

Em uma versão recriada do dilema do bonde — um experimento de pensamento em ética que pergunta se você optaria pela morte de uma pessoa para salvar várias outras —, os pesquisadores pediram aos participantes em sua plataforma que decidissem entre dois cenários envolvendo um veículo autônomo com uma falha repentina no freio. Em um exemplo, o carro vai optar por atingir pedestres na frente dele para evitar matar aqueles no veículo; no outro, o carro desviará para uma divisória de concreto, matando os que estão no veículo, mas poupando os que atravessam a rua.

Máquina Moral. Imagem: MIT Media Lab

Os cenários incluíam a escolha de um grupo ou outro com base em avatares de diferentes gêneros, status socioeconômicos (por exemplo, um executivo contra um sem-teto), níveis de condicionamento físico, idade e outros fatores.

Como exemplo, os participantes foram questionados se optariam por poupar um grupo de cinco criminosos ou um de quatro homens inocentes. Em outro exemplo, ambos os grupos foram representados por um homem, uma mulher e um menino. No entanto, um detalhe adicional no caso do grupo de pedestres foi que eles estavam “cumprindo a lei ao atravessar no sinal verde”, insinuando que o motorista do grupo de carros poderia estar infringindo a lei.

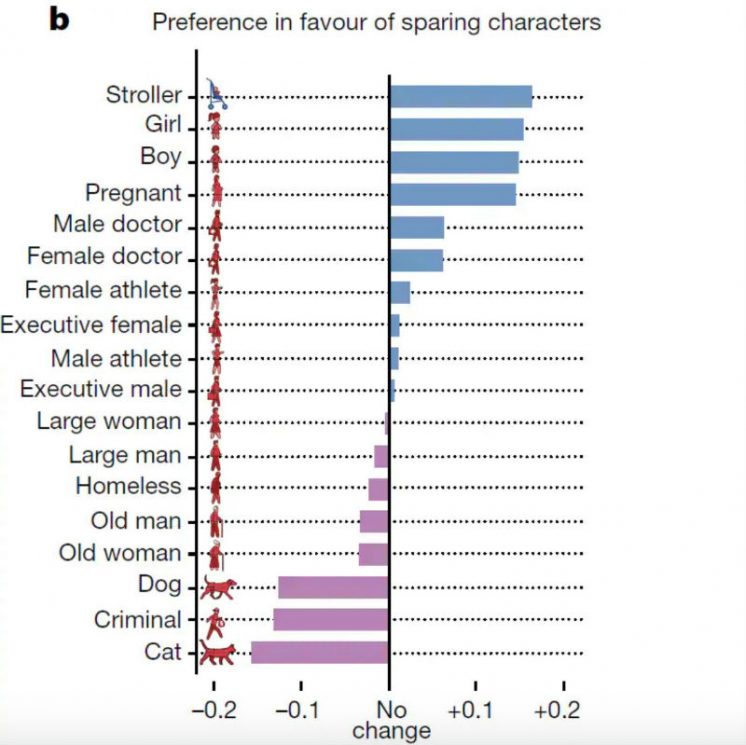

Os pesquisadores descobriram que, como um todo, seus dados mostraram que as pessoas tenderam a preferir poupar mais vidas, jovens e humanos em vez de animais. Mas as preferências dos participantes se desviaram quando seus países e culturas foram levados em consideração. Por exemplo, os entrevistados na China e no Japão eram menos propensos a poupar os jovens do que os idosos, o que, como observou o MIT Technology Review, pode ser “devido a uma maior ênfase no respeito aos idosos” em suas culturas. Outro exemplo destacado pela revista foi que os entrevistados em países ou territórios “com alto nível de desigualdade econômica apresentam maiores lacunas entre o tratamento de indivíduos com alto e baixo status social”.

Máquina Moral. Imagem: MIT Media Lab

“As pessoas que pensam sobre a ética de máquinas fazem parecer que você pode criar um conjunto perfeito de regras para robôs, e o que mostramos aqui com dados é que não há regras universais”, disse Iyad Rahwan, cientista da computação do MIT e coautor do estudo, em um comunicado.

Críticos apontaram que existem decisões prováveis que precedem qualquer ultimato ético extremo quanto os apresentados nessa pesquisa. Mas, se alguma coisa, o que esses dados mostram é que há muito a se considerar sobre os processos de tomada de decisão da inteligência artificial. E os pesquisadores do estudo disseram que esperam que suas descobertas sejam um ponto de partida para uma discussão mais complexa em torno da ética universal das máquinas.

“Usamos o dilema do bonde porque é uma maneira muito boa de coletar esses dados, mas esperamos que a discussão de ética não fique confinada nesse tema”, disse Edmond Awad, associado pós-doutorado no grupo Scalable Cooperation, do MIT Media Lab, e coautor do estudo, em entrevista ao MIT Technology Review. “A discussão deveria ir para a análise de risco — sobre quem está em mais ou menos risco — em vez de dizer quem vai morrer ou não, e também sobre como o viés está acontecendo.”

[MIT Technology Review, Nature]

Imagem do topo: AP