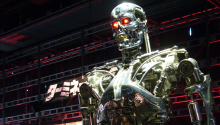

Não restam dúvidas que a era de máquinas assassinas autônomas está chegando. Mas algumas pessoas muito espertas e influentes querem fazer disso uma impossibilidade.

>>> Como a inteligência artificial poderia acabar com a humanidade

Mais de mil pessoas do mundo da tecnologia, viagem espacial, computação e matemática assinaram uma carta aberta pedindo pelo fim da corrida de armas autônomas. A carta foi apresentada nesta terça-feira (28) em Buenos Aires, na Argentina, na Conferência Internacional de Inteligência Artificial.

A lista de signatários inclui um pouco de tudo, desde estudantes de matemática ao linguista Noam Chomsky e Steve Wozniak, cofundador da Apple. Stephen Hawking e Elon Musk, que já nos avisaram sobre os potenciais perigosos de máquinas autônomas assassinas, também estão entre os que assinaram a carta.

A preocupação deles se centra na ideia de que humanos serão deixados de fora dos campos de batalha do futuro. Mísseis de cruzeiro e drones operados por humanos? Estes são ok, de acordo com a carta. Mas além disso, não.

Veja abaixo a carta na íntegra:

Armas autônomas selecionam e atacam alvos sem a intervenção humana. Eles podem incluir, por exemplo, quadcópteros armados que procuram e eliminam pessoas que se adequam a certos critérios, mas não incluem mísseis de cruzeiro ou drones pilotados remotamente, nos quais humanos fazem todas as decisões de alvo.

A Inteligência Artificial (IA) chegou a um ponto em que a aplicação de tais sistemas é — se não for ilegal — realizável dentro de anos, não décadas, e os riscos são altos: máquinas autônomas são descritas como a terceira revolução da guerra, depois da pólvora e de armamentos nucleares.

Muitos argumentos foram feitos contra e a favor de armamento autônomo, por exemplo, substituir soldados humanos por máquinas é bom por reduzir mortes e ferimentos, mas é ruim por diminuir o limite para entrar na batalha. A questão chave para a humanidade hoje é se devemos começar uma corrida de armas com AI ou se devemos preveni-la de começar. Se um poder militar decide seguir com o desenvolvimento de armas com AI, uma corrida global de armamento inteligente será inevitável, e o final da trajetória dessa tecnologia é óbvio: as armas autônomas serão a AK-47 de amanhã.

Diferente de armas nucleares, as armas inteligentes não requerem materiais caros ou difíceis de se obter, então elas se tornariam baratas para todos os poderes militares importantes a produzirem em massa. É apenas uma questão de tempo até elas aparecerem no mercado negro e nas mãos de terroristas, ditadores querendo formas melhores de controlar a população, chefes militares querendo efetuar limpezas étnicas etc.

Armas autônomas são ideais para assassinatos, desestabilizações, diminuir populações e seletamente matar um grupo étnico em particular. Desta forma, nós acreditamos que uma corrida para o armamento IA não seria benéfico para a humanidade. Existem diversas maneiras em que a IA pode fazer campos de batalha mais seguros para humanos, especialmente civis, sem a necessidade de criar novas armas para matar pessoas.

Assim como químicos e biólogos não têm interesse em construir armas químicas e biológicas, a maioria dos pesquisadores de IA não têm interesse em construir armas IA — e não quer que outros manchem este campo ao fazê-las, potencialmente criando uma repercussão negativa para a IA que pode diminuir futuros benefícios para a sociedade. Inclusive, químicos e biólogos amplamente apoiaram acordos internacionais que proibiram com sucesso armas químicas e biológicas, assim como físicos apoiaram tratados banindo armas nucleares espaciais e armas lasers que cegam.

Em resumo, acreditamos que a IA tem grande potencial para beneficiar a humanidade em diversas formas, e o objetivo deste campo de pesquisa deveria ser exatamente esse. Iniciar uma corrida para o armamento inteligente é uma má ideia, e deve ser prevenida por um banimento de armas autônomas que estejam além do controle humano.

A carta foi coordenada pelo Instituto Future of Life, cuja missão é explicitamente descrita como o “desenvolvimento otimista de visões do futuro”.

A parte que pode ser confusa depois de ler a carta? Nós já temos armamento militar autônomo, dependendo da sua definição de “ficar de fora”. E com certeza existem tecnologias autônomas atualmente sendo usadas pelo exército americano, das quais o público em geral nem tem ideia.

Os signatários claramente gostariam de estipular um limite. Mas a questão é: esse limite já não foi cruzado? Pessoas como Musk e Wozniak talvez precisem inventar uma máquina do tempo se eles quiserem limitar alguma coisa. [The Guardian]

Foto de capa: Dick Thomas Johnson/Flickr