Novo estudo do Facebook revela quanto a rede social filtra o que você vê

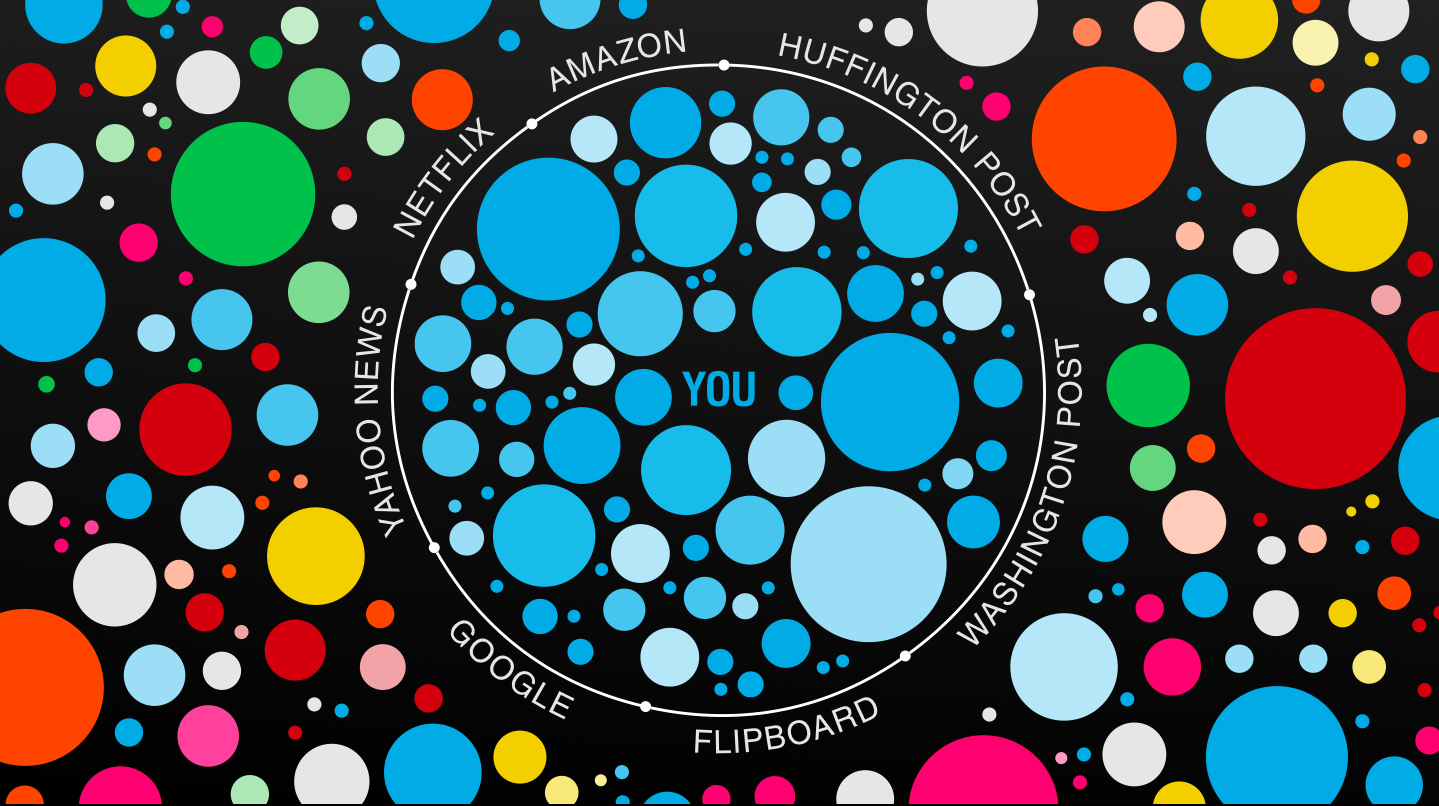

Há alguns anos, eu dei uma palestra sobre como algoritmos e mídias sociais moldam o que sabemos. Concentrei-me sobre os perigos do “filtro-bolha” – o universo personalizado de informação que chega ao nosso feed – e argumentei que os algoritmos de filtragem de notícias limitam o que sabemos, cercando-nos de informações que tendem a apoiar o que já acreditamos. A imagem na parte superior é o principal slide.

Na palestra, eu pedi a Mark Zuckerberg, Bill Gates, e Larry e Sergey do Google (alguns dos quais supostamente estavam na plateia) para garantirem que seus algoritmos priorizassem pontos de vista e notícias contrárias que fossem importantes, não apenas o material mais popular ou que reforçasse nossas crenças. (Eu também escrevi um livro sobre o assunto, caso você se interesse.)

Agora, a equipe de ciência de dados no Facebook testou parte da teoria do “filtro-bolha”, e publicou os resultados na famosa revista científica Science. Eytan Bakshy e Solomon Messing, dois dos coautores, foram prestativos e me deram mais informações sobre o estudo.

>>> Curtir tudo o que aparece no seu Facebook não é uma ideia muito boa

>>> Como domar o Feed de notícias do Facebook

Como se saiu a teoria do “filtro-bolha”?

Eis o resultado: sim, usar o Facebook significa que você tende a ver muito mais notícias que sejam populares entre pessoas que compartilham suas crenças políticas. E há um “efeito filtro-bolha” real e cientificamente significativo: o algoritmo do feed de notícias no Facebook, em particular, tende a amplificar as notícias que seus afetos políticos favorecem.

Este efeito é menor do que você imagina (e menor do que eu teria imaginado). Em média, você é cerca de 6% menos propenso a ver conteúdo que o outro lado político favoreça. Na verdade, as suas amizades pesam muito mais do que o algoritmo em si.

Mas o efeito não é insignificante. Para quem se descreve como liberal no Facebook, por exemplo, o algoritmo desempenha um papel um pouco maior no que eles veem, em relação às escolhas próprias sobre o que clicar. O algoritmo reduz o conteúdo discordante em 8%, contra uma queda de 6% causada pelas próprias escolhas dos liberais sobre o que clicar.

Para os conservadores, o efeito do filtro-bolha é de cerca de 5%, e o efeito clique é cerca de 17% – uma situação bem diferente. (Eu selecionei alguns outros resultados interessantes do estudo aqui.)

No estudo, Bakshy, Messing e o cientista de dados Lada Adamic se concentraram nos 10 milhões de usuários que se definiram politicamente na rede social. Eles usaram palavras-chave para distinguir conteúdo “hard news” – sobre política ou economia, por exemplo – das “soft news” sobre a família Kardashian.

E eles atribuíram a cada artigo uma pontuação baseada em crenças políticas das pessoas que o compartilharam. Se apenas os liberais compartilhassem um artigo, ele era considerado altamente liberal. (Existem algumas ressalvas que vale a pena atentar nesta metodologia, que eu destaco a seguir.)

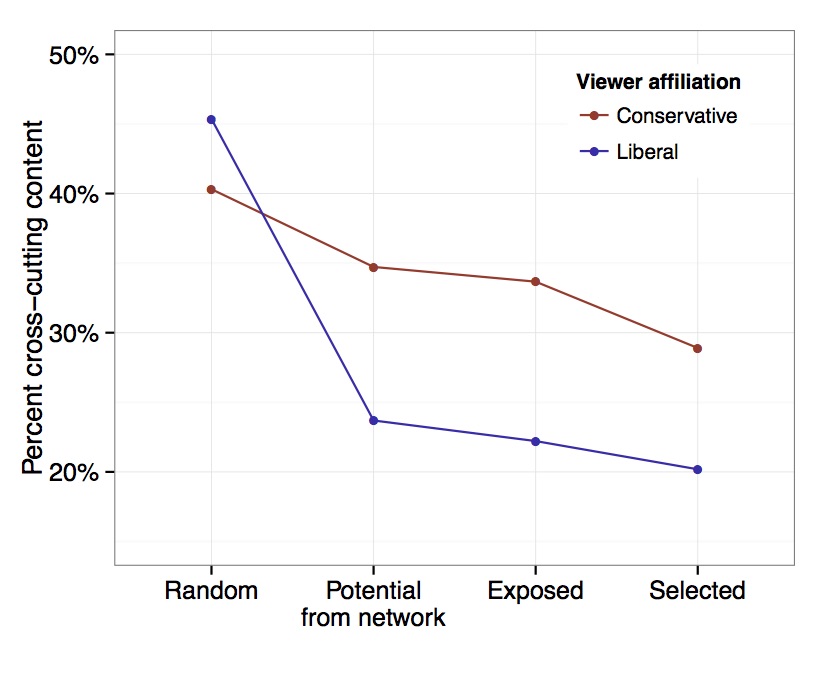

Em seguida, eles analisaram a forma como os liberais viam conteúdo alinhado a conservadores, e vice-versa. Aqui está o principal gráfico:

Primeiro (“Random”), ele mostra a proporção total de links para notícias sérias no Facebook, se todo mundo visse uma amostra aleatória de todas elas. Os liberais viam 45% de conteúdo conservador, enquanto conservadores viam cerca de 40% de teor liberal.

Em segundo lugar (“Potential from network”), você vê o percentual médio de artigos discordantes postados por amigos de uma pessoa.

Em terceiro lugar (“Exposed”) está a percentagem que essas pessoas realmente viram – é onde entra o algoritmo do Facebook.

Por fim (“Selected”), está a percentagem em que eles realmente clicaram para ler.

Uma coisa importante a ter em mente: a inclinação desta linha vai para baixo. Em cada fase, a quantidade de conteúdo discordante visto no feed diminui. A redução mais acentuada vem do que seus amigos compartilham, o que faz sentido: se você tiver apenas amigos liberais, você verá uma redução dramática em notícias conservadoras. Mas o algoritmo e as escolhas das pessoas envolvendo o que clicar importam bastante, também.

Em seu comunicado à imprensa, o Facebook enfatiza que a “escolha individual” importa mais do que algoritmos: ou seja, os seus amigos e suas ações para evitar conteúdo com o qual você não concorda são os principais culpados em criar uma bolha. Eu acho que isso é um exagero.

Certamente, seus amigos têm peso sobre o que você vê nas mídias sociais. Mas o efeito do algoritmo em estreitar sua visão de mundo é quase tão forte quanto a nossa própria tendência a evitar conteúdo com o qual discordamos – e isso é muito importante.

Há outra peça-chave aqui. Meu livro O Filtro Invisível trata de duas preocupações: os algoritmos iriam nos cercar de notícias compatíveis com o que já acreditamos; e os algoritmos tenderiam a diminuir a prioridade das notícias mais necessárias em uma democracia – aquelas que tratam de temas sociais importantes.

Este estudo se concentrou no primeiro problema, mas também oferece alguns insights sobre o segundo, e os dados são preocupantes. Apenas 7% das pessoas clicam em “hard news”, em notícias sérias. Essa é uma peça terrivelmente pequena do quebra-cabeça. E isso sugere que “soft news”, ou notícias irrelevantes, podem estar ganhando a guerra de atenção nas mídias sociais – pelo menos por enquanto.

A discussão sobre os efeitos e a ética de algoritmos é incrivelmente importante. Afinal, eles interferem cada vez mais no que fazemos. Eles orientam uma proporção crescente das nossas escolhas: onde comer, com quem transar, e o que ler. No Google, Yelp e Facebook, eles ajudam a moldar o que sabemos.

Cada algoritmo contém um ponto de vista sobre o mundo. Talvez isso até defina um algoritmo: uma teoria de como parte do mundo deveria funcionar, expressa em equações ou código. Seria ótimo poder compreendê-los melhor, então é importante que o Facebook entre nessa discussão. Quanto mais pudermos questionar como esses algoritmos funcionam e seus efeitos, seremos mais capazes de moldar nosso próprio destino em receber informação.

Algumas ressalvas importantes sobre o estudo

O mecanismo para identificar ideologias não funciona da forma que você imagina. Como notam os autores, o estudo não mede se uma notícia ou fonte de informação é polarizada. Isso talvez passe despercebido para muitas pessoas!

Pelo contrário, o estudo mede quais artigos tendem a ser compartilhados a mais por um grupo ideológico. Se os conservadores gostam de unicórnios e há conteúdo que seja “hard news” sobre unicórnios, ele vai aparecer como alinhado a conservadores – mesmo que a questão dos unicórnios não seja partidária.

É difícil calcular a média de algo que está em constante mudança e é diferente para todos. Este resultado é verdadeiro, em média, durante um período de tempo (7 de julho de 2014 a 7 de janeiro de 2015). Esse é um período em que os vídeos no Facebook e a área Tendências se tornaram muito mais proeminentes – e não podemos ver o efeito que isso teve.

(Eu acho que os autores diriam que suas descobertas são duráveis, mas dadas as constantes reinvenções do Facebook, eu sou um pouco mais cético.)

Isso só mede os 9% dos usuários do Facebook que relatam sua filiação política. É razoável supor que eles sejam um pouco diferentes – talvez mais partidários ou mais ativistas – do que o usuário médio do Facebook.

É realmente difícil separar “escolhas individuais” do funcionamento do algoritmo. Todo o efeito de filtragem aqui talvez decorra de uma escolha individual: a escolha de usar o Facebook. Por outro lado, o algoritmo responde ao comportamento do usuário em muitas maneiras diferentes. Há um ciclo aqui que pode diferir astante para diferentes tipos de pessoas.

Na minha humilde opinião, este é um bom estudo científico, mas por ser feito internamente no Facebook, ele não é reprodutível. Os pesquisadores deste estudo são pessoas inteligentes, e com as ressalvas acima, a metodologia é adequada. Eles também vão liberar boa parte do conjunto de dados e algoritmos disponíveis para que outros possam analisá-los.

Mas é o Facebook quem decide quais estudos são liberados, e não é possível que um pesquisador independente reproduza esses resultados sem a permissão do Facebook.

Eli Pariser é o autor do best-seller O Filtro Invisível – O Que a Internet Está Escondendo de Você e cofundador do Upworthy, um site dedicado a chamar a atenção para temas sociais importantes. Ele está no Twitter como @Elipariser.

Este post foi publicado originalmente no Medium e é republicado aqui com permissão.