Cientistas criam inteligência artificial psicopata que enxerga violência em imagens

O mundo distópico em que robôs e inteligências artificiais dominam a humanidade ainda mora apenas no mundo ficcional, mas é um pulo para ficarmos assustados só com a possibilidade desse futuro. Cientistas do MIT, por exemplo, criaram uma inteligência artificial psicopata que interpreta imagens como possíveis cenas terríveis.

• Cientistas desenvolvem inteligência artificial capaz de te identificar pelo seu jeito de caminhar

• Inteligência artificial do Facebook consegue transformar música clássica em jazz

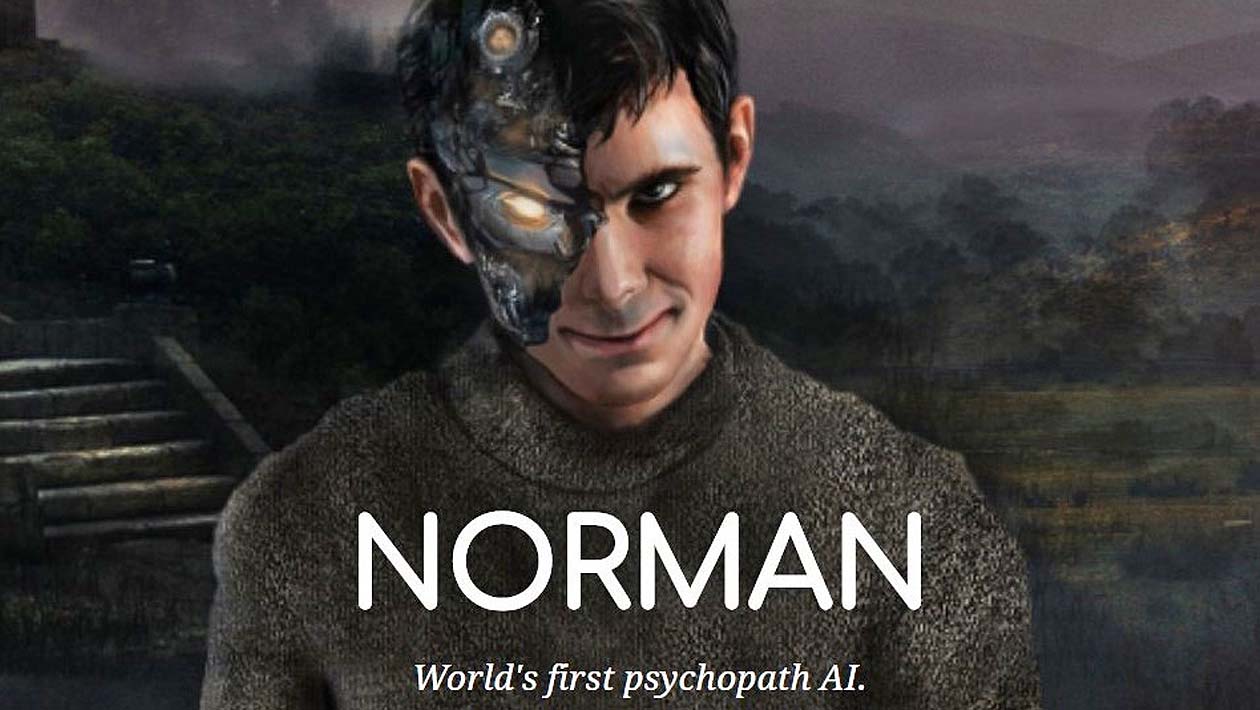

A IA foi batizada de Norman, em homenagem ao personagem de Anthony Perkins no filme Psicose, de Alfred Hitchcock. Ela foi alimentada com imagens assustadores de mortes e violência pesada – todas retiradas do Reddit – e assimiladas por meio de deep learning.

Depois, os pesquisadores pediram para que a máquina interpretasse algumas imagens, em uma técnica conhecida como teste de Rorschach, que consiste em dar respostas sobre com o que se parecem dez pranchas com manchas de tinta simétricas. As legendas de Norman foram comparadas com a leitura de uma IA padrão, alimentada com imagens não violentas.

A diferença entre a descrição das duas IAs chega a ser absurda: enquanto a versão padrão enxerga “um plano fechado de um vaso com flores”, a versão psicopata diz que se trata de “um homem morto a tiros”. Em outra, Norman enxerga um “homem puxado por uma moedora industrial”, enquanto a outra IA vê “uma foto preta e branca de um pequeno pássaro”. A cena interpretada pela máquina psicopata como “um homem morto a tiros em frente de sua esposa desesperada” é vista apenas como “uma pessoa segurando um guarda-chuva no ar”. Você pode conferir todos os resultados do teste neste link.

Segundo os pesquisadores Pinar Yanardag, Manuel Cebrian e Iyad Rahwan, a IA foi constantemente exposta a imagens negativas e, portanto, não conseguiu construir uma lógica de empatia. O estudo joga luz sobre a natureza dos algoritmos: tudo depende de quais dados são fornecidos para a máquina.

Os cientistas afirmam que os algoritmos aparentam ser tendenciosos ou injustos, “o culpado geralmente não é o algoritmo em si, mas os dados enviesados que foram introduzidos nele” e que o estudo mostra “os perigos da inteligência artificial quando dados tendenciosos são utilizados”.

[Newsweek]

Imagem do topo: MIT