Lançamento do Bard, o ChatGPT do Google, é marcado por gafe com James Webb

Nem tudo são flores: o Google cometeu uma gafe daquelas sobre o telescópio espacial James Webb ao anunciar o Bard, seu bot nos moldes do ChatGPT. A companhia divulgou informações falsas sobre o equipamento da NASA em anúncio sobre a IA (inteligência artificial) no Twitter.

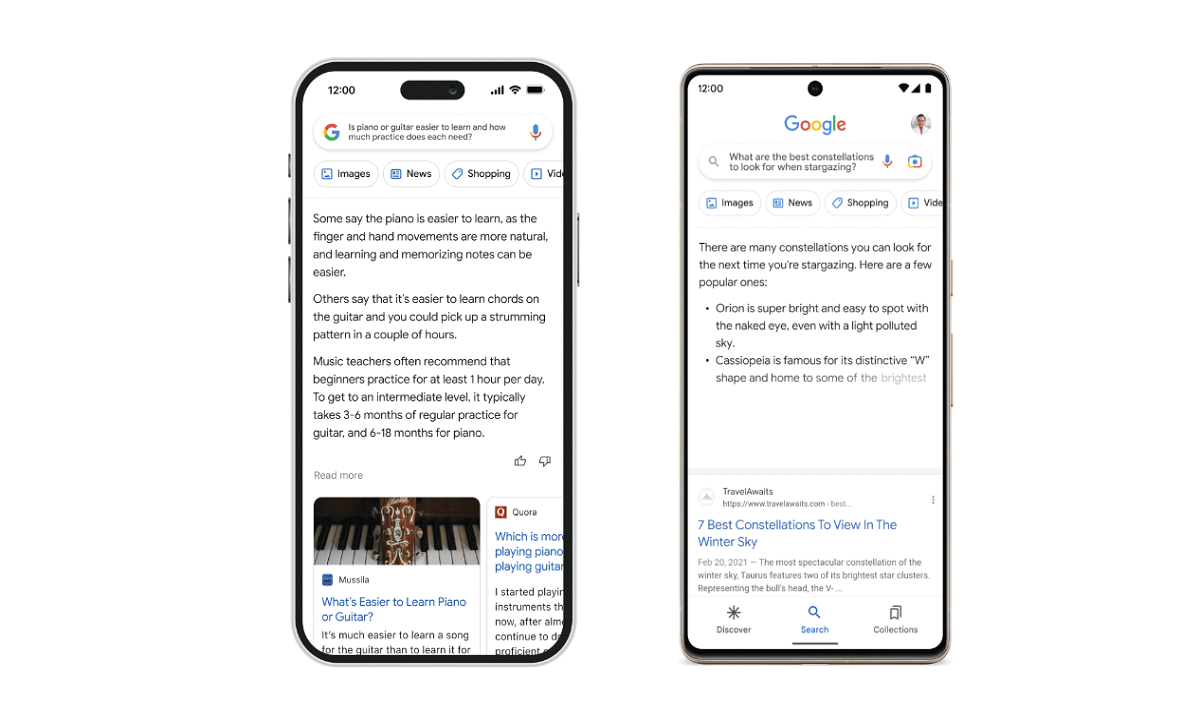

Em um GIF, o Google mostra um exemplo de pergunta para o Bard. “Que novas descobertas do telescópio Espacial James Webb posso contar ao meu filho de 9 anos?”, mostra a imagem. O sistema apresenta três ideias rapidamente – incluindo uma fake news.

Bard is an experimental conversational AI service, powered by LaMDA. Built using our large language models and drawing on information from the web, it’s a launchpad for curiosity and can help simplify complex topics → https://t.co/fSp531xKy3 pic.twitter.com/JecHXVmt8l

— Google (@Google) February 6, 2023

“O JWST tirou as primeiras fotos de um planeta fora do nosso próprio sistema solar. Esses mundos distantes se chamam ‘exoplanetas’. Exo significa ‘de fora’”, disse Bard.

O erro está na informação de que o James Webb tirou as primeiras fotos de um astro externo à Via Láctea. Na verdade, quem tirou a primeira foto de um exoplaneta foi o VLT (Very Large Telescope), do Observatório Europeu do Sul, ainda em 2004.

É possível que o Bard tenha se “confundido” com notícias recentes que divulgaram a primeira foto de um exoplaneta do James Webb – o que é diferente de um registro inédito em toda a história.

Sinal dos tempos

A primeira gafe do Bard é um detalhe que pode ter passado despercebido no Twitter, mas se transformou em alerta sobre a proeminente onda de desinformação propagada por bots automatizados.

Além do Bard do Google, o mecanismo de busca Bing já incluiu o ChatGPT no navegador a fim de tornar suas “pesquisas mais humanizadas”. Além disso, sites começaram a usar a IA generativa para escrever textos – muitos deles cheios de erros.

Mas é fácil confiar neles. Na verdade, IAs generativas como o ChatGPT e Bard foram criados para soar 100% confiáveis. Eles se baseiam em um algoritmo de previsão de textos – ou seja, escolhem palavras que transmitam maior credibilidade ao texto.

Respostas cheias de confiança poderão fazer com que milhares não verifiquem os fatos e confiem em informações falsas. A diferença é que a desinformação poderá ganhar ainda mais força ao ser alimentada por IA.