Estranho este título, né? Para quem está envolvido diretamente no debate de segurança e dados no Brasil nos últimos cinco anos, parece piada. Mas é real: o debate hoje furou a nossa bolha de cientistas, desenvolvedores, advogados, ativistas dos direitos digitais e tudo mais. Ele escalou. E agora, o que fazer?

Nos últimos anos, o Brasil tem tentado se posicionar no debate acerca da inserção de tecnologias digitais no nosso dia a dia, ainda que de uma maneira ainda superficial, por ignorar outros contextos para além de universidades e organizações que já trazem este foco, e sobretudo ignorar outras realidades em um país em que mais de 30% da população ainda está sem acesso a dispositivos ou internet. Não podemos olhar para o debate de uma única perspectiva.

No fim do mês de abril, o presidente da ONG Cufa, Celso Athayde, divulgou que a organização usaria reconhecimento facial para transparência e segurança das doações. Fui uma das primeiras a questionar para entender o motivo de usar uma tecnologia como esta. Com o engajamento de pesquisadores e ativistas na própria rede social, a CUFA cancelou o uso e também abriu oportunidade de diálogo. As conversas foram muito bem recebidas pela CUFA e também pelo IDTECH.

Até então, estávamos debatendo transparência e ética dos dados apenas entre quem trabalha com isso. Mas e os outros contextos, como o da CUFA? Outra situação é o debate e posicionamento sobre reconhecimento facial.

Por isso, quero aproveitar a oportunidade que tenho de ser colunista para aprofundar o debate.

Ética nos dados não é só uma discussão tecnológica

A ética de dados cobre uma gama incrivelmente ampla de áreas, muitas dos quais são urgentes, mas não fechadas em uma só área. Por exemplo: uma meta-análise de mais de 100 programas sobre ética da tecnologia, intitulada “O que ensinamos quando ensinamos ética da tecnologia?”, descobriu que havia uma grande variação nos tópicos que são abordados nos cursos de ética tecnológica (lei e política, privacidade e vigilância, filosofia, justiça e direitos humanos, impacto ambiental, responsabilidade cívica, robôs, desinformação, trabalho, design, segurança cibernética, pesquisa ética e muito mais do que qualquer curso poderia cobrir). Ou seja, cabem muitas ciências e diversas áreas nesta discussão. Por isso, o debate se tornar público para envolver a sociedade civil é essencial. Mas para isso temos um caminho na construção e na continuação da educação digital e midiática da população brasileira.

Pensamento crítico na era digital

É interessante observar nesses debates como as pessoas partem do pressuposto que todos já entendem do tema. Pelo meu trabalho na educação e divulgação científica dentro da computação, percebo o como não é nada redundante repetir temas, aulas e sobretudo debates de determinados temas dentro da área de segurança ou inteligência artificial.

Considero parte do processo de abertura e transparência dos dados o desenvolvimento educacional. Não faz sentido cobrar da sociedade civil brasileira posicionamentos sobre reconhecimento facial se não chegaram até as pessoas a contextualização de quais são os perigos. Hoje, no momento difícil e delicado em que nos encontramos, se tornou quase que parte do nosso noticiário ouvir situações que envolvem desinformação, vieses de algoritmos, vigilância e privacidade, reconhecimento facial e por aí vai.

Eu gosto de saber quem realmente entende tudo isso que está acontecendo e também de quem não está entendendo. Isso abre oportunidade para compartilhar o conhecimento que absorvi até aqui sobre estes assuntos.

Tecnologia não é neutra

Nos últimos anos, a inteligência artificial tem ocupado um lugar importante na sociedade. Um lugar de destaque, como se fosse a “salvação” de tudo que nós seres humanos não conseguimos cumprir ou realizar. Naturalizou-se falar que tecnologias são neutras e imparciais e que, por isso, elas começariam a ser usadas em tomadas de decisões.

Não me entenda mal, eu sou da área da ciência da computação, mas “tecnologia imparcial”? Até que ponto conseguimos separar a criação do criador (ou criadores)? E quem são estes criadores? Pois bem sabemos que nas áreas de ciências exatas há uma grande discussão sobre inclusão e diversidade, que não deveria ser só fechada em gênero. Nós temos contexto racial, PCDs, classe social e muitos outros aspectos a serem contemplados na área, pensando até nas soluções que são postas na sociedade com um determinado viés. Existem muito mais reflexões que respostas, mas, como disse a cientista ganesa Joy Buolawmni, “às vezes, respeitar as pessoas significa certificar-se de que seus sistemas são inclusivos”.

Vigilância e Reconhecimento Facial

Buolawmni é criadora do projeto “Gender Shapes”, que em 2018 compartilhou com o mundo a reprodução do racismo estrutural nos algoritmos de visão computacional, mais precisamente em sistemas de reconhecimento facial que utilizavam modelos e algoritmos criados por empresas como Amazon, Google e Microsoft. Recentemente, ela expandiu a discussão em seu documentário “Coded Bias”, que acabou de ser lançado pela Netflix. A partir do trabalho dela, questiono se é possível visualizar o processo e sua posição contra o reconhecimento facial. E como isso se encaixa no Brasil?

Enormes quantidades de dados estão sendo coletados sobre nós: aplicativos em nossos telefones rastreiam nossa localização, sites de namoro vendem detalhes íntimos, reconhecimento facial em registros escolares de alunos. A polícia usa bancos de dados grandes e não regulamentados de rostos. Exemplos do mundo real de como nossos dados são coletados, vendidos e usados. O reconhecimento facial é um dado biométrico, mas ainda assim é um dado sensível — é o rosto de uma pessoa. Existem também padrões preocupantes relacionados a esta tecnologia de como a vigilância é usada para suprimir a dissidência e prejudicar ainda mais aqueles que já são marginalizados. De modo geral, os princípios da lei de proteção de dados dizem que a finalidade da coleta da imagem facial precisa ser clara e o processo deve ser transparente, seguro e não-discriminatório. Mas, ainda assim, não visualizamos esta prática no uso destas tecnologias.

Um estudo da Rede de Observatórios de Segurança mostrou que 90% das pessoas presas por reconhecimento facial, no Brasil, são negras. O perfil segue a tendência da população carcerária do país, na qual dos 90%, 88% são homens negros com idade média de 35 anos, abordados principalmente por tráfico de drogas (24%) e roubo (24%). Os dados dizem respeito aos casos com informações que estavam disponíveis. Não quero transformar isso em um texto técnico, mas hoje não se sabe, tecnicamente falando, em que momento da construção deste tipo de sistema o viés acontece. Não é possível afirmar que é só uma questão de base de dados não diversa. Mas podemos afirmar que as tecnologias não são neutras, assim como nós humanos que interferimos e participamos dos processos da construção destes sistemas inteligentes.

Concluindo o texto mas não o debate

A ideia do texto não era resumir o problema ao uso na CUFA mas, sim, abrir o debate e tornar mais amplo o problema da urgência de a sociedade civil participar do debate. Os algoritmos estão cada vez mais acessíveis e fazendo parte do nosso dia a dia, seja em formato de soluções tecnológicas físicas, seja nas plataformas digitais que utilizamos para nos comunicar ou nos dispositivos que utilizamos para facilitar nossa vida. Nestes e em outros exemplos, dados e informações são gerados, armazenados e compartilhados.

O fato é que será difícil visualizar um futuro sem essa interferência. Então como lidar com uma dinâmica de socialização que é reproduzida ou simulada a partir de sistemas criados por determinados grupos, com determinadas crenças, valores e vieses? A proposta da reflexão não é chegar a um debate sociológico e filosófico do ser humano na sociedade, até porque esta discussão está acontecendo em tempo real. Precisamos nos atentar a como a reprodução de vieses tem impactado a sociedade nos últimos anos.

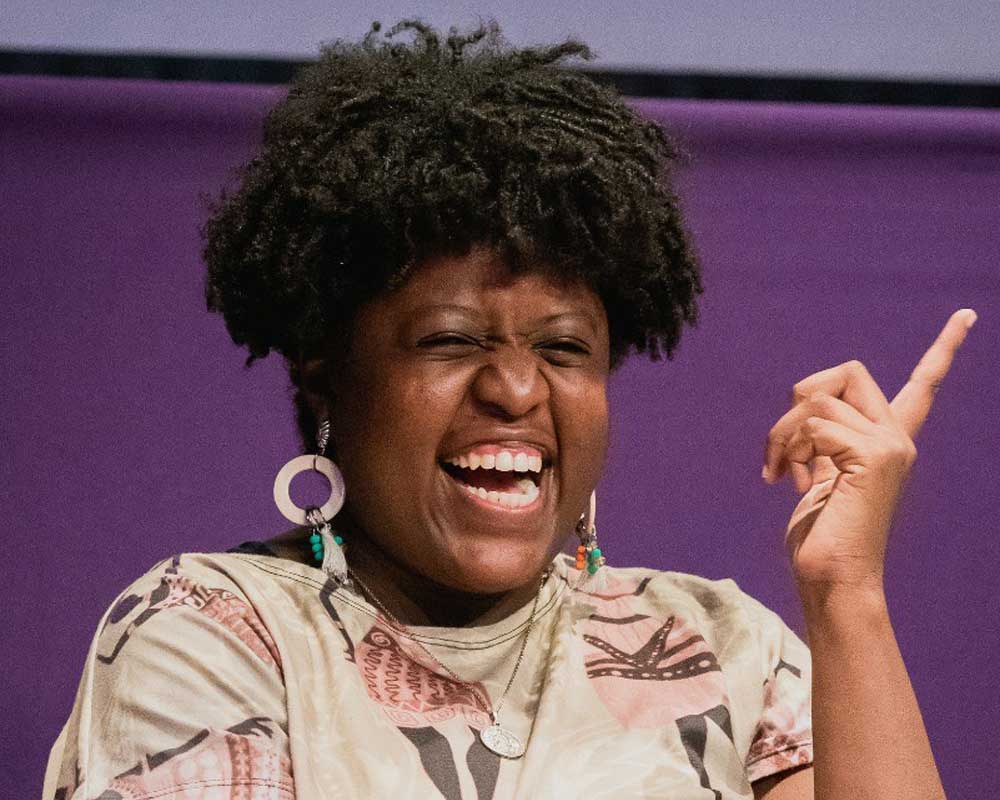

Nina da Hora é Cientista da Computação pela PUCRio e pesquisadora em Algoritmos e IA Tiktok Safety Council Member