O playground da NASA que leva a realidade virtual a um novo patamar

A NASA consegue recriar o vácuo do espaço bem aqui na Terra, mas e quanto à gravidade do espaço? E as forças da inércia? Quando grandes objetos se movem e se comportam de forma tão diferente, como treinar para uma missão, se preparando para o que pode acontecer lá no espaço?

Visitamos o laboratório onde a NASA cria incríveis mundos virtuais conectados a robôs e à vida real, criando a mais avançada realidade virtual que já vimos na vida — uma realidade virtual que deixa o Oculus Rift comendo poeira, um robô que simula a física do espaço, e sim, até mesmo um jetpack.

O Centro Espacial Johnson da NASA (JSC) em Houston, Texas, é lar para o Laboratório de Realidade Virtual da agência, o qual é indiscutivelmente o treinamento mais avançado que astronautas recebem na Terra. Nele, encontramos DOUG. DOUG não é uma pessoa, é um acrônimo para o programa Dynamic Onboard Ubiquitous Graphics. É um programa de renderização impecavelmente detalhado que modela tudo na estação espacial, dos decalques ao fluido das linhas e a fiação elétrica.

De acordo com James Tinch, gerente do laboratório VR da NASA, “tudo que a tripulação pode ver fora da Estação Espacial, nós modelamos aqui; assim, quando eles estiverem no espaço, terão a sensação de já terem passado por lá, porque já vivenciaram o mesmo ambiente no mundo virtual”.

Dentro dos headsets VR, a tripulação vê uma representação virtual em 3D da Estação Espacial Internacional (ISS). A equipe do Laboratório VR pode colocá-los em qualquer lugar da estação, independente de a área ser de domínio dos EUA, Rússia, Japão ou da Europa. Isso significa que, caso os membros da tripulação estejam trabalhando em uma unidade de bombeamento, eles terão uma perspectiva real de como será o ambiente de trabalho espacial. Eles também podem experimentar (virtualmente) o que será trabalhar na ponta do braço robótico da estação.

Isso dá aos astronautas uma chance de avaliar se o ambiente de trabalho se acomoda às necessidades deles, experimentando o local de diversos ângulos de dentro do traje espacial. Desta forma, é possível avaliar se eles estão no local ideal da ISS para reparar partes que precisam de conserto, ou para ver se a ferramenta que eles irão usar funcionará da forma como eles esperam, por exemplo. A missão pode ser ajustada e reprojetada, e as ferramentas e os componentes são reconstruídos constantemente, baseados com o que é aprendido no ambiente virtual.

Criando o espaço na Terra

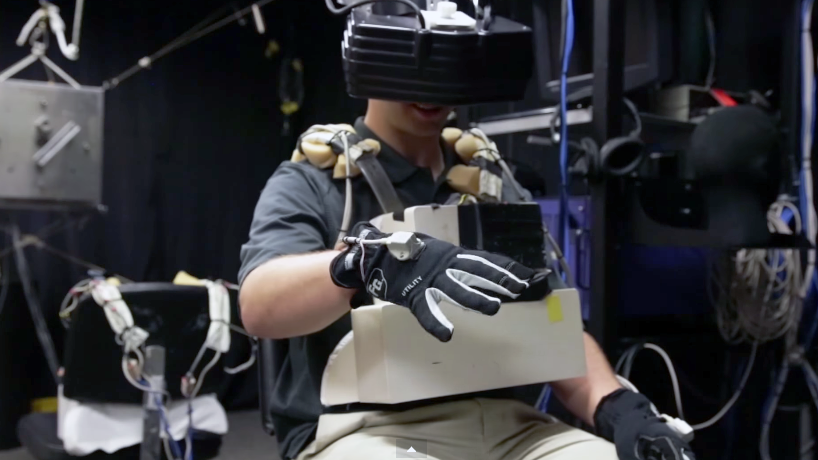

O traje necessário para usar o VR da NASA é composto por, entre outros, um par de luvas cheias de sensores. Essa configuração permite a você acompanhar o movimento das próprias mãos, identificando-as no mundo virtual. As luvas também possuem sensores de força nas palmas, desta maneira, você pode apertar um objeto (uma ferramenta, por exemplo, ou um corrimão), e as suas mãos virtuais se fecharão em volta dele. Não é articulado a ponto de controlar cada dedo individualmente, mas o movimento de abrir/fechar parece ser detalhado o suficiente para estas simulações.

Existe também uma caixa que fica na altura do seu peito. Ela mapeia seus movimentos de rotação, assim, quando você gira, ele gira o seu corpo no mundo virtual.

E por que ter o trabalho de criar todos estes mundos virtuais? Porque a gravidade da Terra torna impossível simular com exatidão algumas tarefas espaciais que fazem usa de hardware físico.

A melhor opção depois do VR para simular as condições espaciais dos astronautas é o Laboratório de Flutuação Neutra da NASA — ele fica embaixo d’água, em uma piscina gigante no JSC. Lá eles têm algumas versões físicas de alguns componentes específicos, mas não é um ambiente igual à estação espacial — a ISS é grande demais.

Eles têm um pequeno pedaço da estação em um dos lados dentro da piscina, e outros pedaços em demais lugares da piscina. Não é uma simulação contínua, porque não se trata de uma estação completa, então o astronauta precisa se mover de uma parte para a outra dentro da piscina para dar continuidade à simulação. É melhor que nada, mas não reflete o verdadeiro layout da ISS.

A realidade virtual, em contraste, dá a você uma visão completa do que esperar no ambiente real, com todas as peças e pedaços virtuais da estação nos mesmos lugares que você as encontraria na estação real que está lá no espaço.

O capacete: ele não é muito bonito, mas é definitivamente potente. Ele proporciona aos usuários imagens expostas um visor com 720p de resolução, além do já esperado mapeamento completo dos movimentos da cabeça. Durante o período que usei o capacete, não notei nenhum tipo de lag, que é a primeira coisa a estragar uma experiência em realidade virtual.

Perguntei ao Dr. Tinch se o sistema era baseado no Oculus Rift. Ele disse que durante o período de desenvolvimento, o Rift não possuía a resolução que a NASA queria, então um dos engenheiros do Laboratório VR construiu o capacete que a agência usa atualmente na garagem da própria casa. Ele disse, entretanto, que a agência acompanha a evolução dos headsets VR comerciais, e pode trocar o modelo que usa atualmente por um vendido comercialmente no futuro.

Um sistema magnético cuida do mapeamento dos movimentos da cabeça, peito e mãos. Os sensores instalados no teto sobre o usuário podem detectar a qualquer momento quando pontos diferentes e específicos são relativos a um ponto central especificado. Foi uma experiência fluida nos primeiros minutos em que usei a tecnologia. Ela não sofreu com problemas em que as mãos desaparecem de repente da tela, algo que já vi acontecer em sistema de mapeamento que fazem uso de luzez LED, como o Blue Shark do exército americano.

Perguntei se a NASA já tentou combinar os treinamentos em VR com o treinamento de flutuação neutra. Dr. Tinch disse que isso seria algo muito difícil de se fazer, por isso nem chegaram a tentar — mas ele explica que os dois laboratórios trabalham em conjunto, fazendo experimentos com hardware físico que astronautas eventualmente usarão na ISS no ambiente de flutuação neutra, para então observar como ele funcionaria dentro da estação espacial virtual. Em alguns casos, é necessário ir e voltar de uma simulação para a outra diversas vezes até que a técnica ou a ferramenta em uso seja aperfeiçoada.

A NASA também possui uma simulação da ISS que não faz uso de capacetes VR na estação robótica da cúpula. Ela é composta por três monitores, cada um simulando uma das três janelas da estação. Não é uma experiência completamente imersiva, mas é boa o suficiente para o trabalho. Usuários podem rolar a tela para obter uma visão em 360 do lado de fora da janela, eles apenas não têm acesso aos 360 graus de uma só vez. É uma configuração muito mais simples do que o equivalente espacial. Ela também conta com três monitores menores que mostram o lado de fora da ISS.

A combinação da perspectiva das janelas com as câmeras externas permite à tripulação monitorar o movimento do braço, assegurando que ele não se chocará com nenhuma outra estrutura. Obviamente, isso é ainda mais importante se um membro da tribulação estiver trabalhando no fim do braço. Essa simulação também conta com os mesmos painéis físicos presentes na ISS. São sistemas engenhosos que trabalham em conjunto: enquanto essa simulação mais simples treina astronautas a bordo da ISS, astronautas em VR treinam do lado de fora da estação e ambos são simulados simultaneamente.

O robô Charlotte

Poder ver como as coisas se relacionam do lado de fora da ISS é extremamente importante para um astronauta se orientar, mas existem algumas coisas que a realidade virtual não consegue simular, a sensação de um objeto, por exemplo, como seu peso e forma. Isso é especialmente importante na estação, porque objetos se comportam de maneira muito diferente da Terra quando estão em microgravidade. Quando você está do lado de fora da estação, uma das suas tarefas talvez seja puxar um painel de duas toneladas e trabalhar com alguns componentes dele de dentro da estação.

Em microgravidade, o painel — mesmo um de duas toneladas — não teria nenhum peso, mas ele ainda tem o mesmo tamanho, se move com a inércia e possui um centro de massa. Astronautas precisam aprender como objetos grandes como este se comportam no espaço, para evitar que eles acidentalmente direcionem algo para longe da estação ou o quebrem.

E então entra o robô Charlotte. Um dispositivo composto de oito motores distintos, cada um responsável pelo controle de um cabo. Estes cabos são todos conectados a um objeto removível no centro, o que cria um visual parecido com uma teia, que, inclusive, é o que dá nome ao robô (é uma homenagem ao livro Charlotte’s Web, conhecido como A Menina e o Porquinho no Brasil). Os motores são todos controlados por um computador central, que usa avançados modelos físicos para determinar como o objeto posicionado no centro deve se mover dependendo do tamanho e massa que ele representa. Ele pode mover o objeto por diversos metros em todos os seis eixos e girar de forma realista.

Digamos, por exemplo, que um astronauta precise remover um cubo largo, de 1,2 m, da estação. O objeto no centro do Charlotte pode ter cerca de 300 m2 e apenas uma peça de corrimão nele — na realidade virtual, ele apareceria para o astronauta em tamanho real, e teria relação física real a tudo encontrado na estação. Quando o astronauta empurra a caixa, ele precisa interromper a inércia. Talvez o centro de gravidade do cubo esteja todo acumulado em um lado; o astronauta vai descobrir que o cubo quer girar de uma forma estranha, assim como ele giraria na realidade, e ele precisa se ajustar a isso. Aprender a lidar com essa tendência de rotação em um ambiente virtual — antes de lidar com equipamentos reais e caros — é crítico para o sucesso de uma missão.

Na hora de colocar o objeto de volta em seu local de origem, o Charlotte pode implementar modelos de contato que simulam as batidas e paradas do objeto retornando ao local, mesmo que na vida real você possa ver que o robô não possui nenhum tipo de impedimento. O Charlotte pode até mesmo simular um barulho sonoro, um clique, para avisar que o objeto está preso corretamente no lugar.

Os laboratórios VR da NASA possuem dois robôs Charlotte separados que podem trabalhar em conjunto. Entoa, digamos que eles precisem simular a remoção e a recolocação de um objeto bem largo que necessitaria da manipulação de dois astronautas. Cada astronauta usa o próprio headset VR e trabalha separadamente com um robô Charlotte que se comporta como se fizesse parte da mesma estrutura que o outro robô. Desta forma, se um astronauta o empurra, o outro sentirá essa força. Se um astronauta gira o objeto, ele gira na mão do outro também. É incrível a quantidade de processamento dessa simulação.

Os corrimões podem ser trocados para fazê-los parecer e sentir como qualquer unidade de substituição orbital que um membro da tripulação pode precisar remover ou instalar na plataforma, o que faz dessa uma incrível realidade virtual que não apenas lida com o senso de visão de uma pessoa, mas também com o tato. Astronautas que voltaram do espaço afirmam que o Charlotte faz um trabalho incrível de aproximação de qual é a real sensação das coisas em microgravidade.

E então entram os jetpacks

Um dos treinamentos dos Laboratórios VR é o assustador cenário de um astronauta se desprender da estação e ser arremessado no espaço. O treinamento inclui o uso da unidade SAFER (Simplified Aid For EVA Rescue, ou unidade extraveicular para auxílio simples). Ela fica na parte de traz do PLiSS (Portable Life Support System), que é, essencialmente, o jetpack que o George Clooney testa no início do filme Gravidade.

No caso de um astronauta se desconectar da ISS durante uma caminhada espacial, ele pode usar a unidade SAFER para interromper a rotação, se posicionar na direção correta e se propulsionar de volta a estação. A unidade usa nitrogênio pressurizado, com bocais na parte de cima, baixo, trás e dos lados, que permitem ao astronauta controlar rotação e giro. Tudo isso é controlado por um joystick do lado direito do traje espacial. Ele lembra um controle do Atari e possui diversas configurações que são usadas para alternar entre os modos (rotação e giro, por exemplo).

O capacete de realidade virtual da NASA permite que astronautas pratiquem situações de emergência do mundo real em que a unidade SAFER seria usada. O astronauta é amarrado a unidade, e o headset dá a ele a visão de como seria uma missão no lado externo da estação espacial. Os engenheiros do Laboratório VR então jogam o astronauta para longe da estação, na vastidão do espaço virtual. Eles então simulam uma taxa de rotação que distancia o astronauta cada vez mais da estação, o que deve ser uma experiência bastante enjoativa.

Leva cerca de 30 segundos até o astronauta tirar o controle da unidade SAFER e usá-lo. Depois disso, ele precisa parar a rotação e localizar a ISS a distância, o que não é tão simples quanto parece, já que os capacetes fechados e rígidos não giram com o movimento da cabeça do tripulante — caso o astronauta tente virar a cabeça, ele verá a parte interna do capacete. Para virar o corpo, é preciso usam o controle para girar o traje até avistar a ISS, e então navegar de volta até ela. A atividade geralmente acaba assim que o astronauta se segura em um corrimão da estação, ou quando ele volta para dentro dela.

Todos estes fatores juntos — o nível de detalhe dos simuladores de computador, e o incrível motor físico que faz o Charlotte funcionar de forma realista — criam o mais avançado sistema de realidade virtual que já vimos. Permite que a NASA no leve ao próximo nível de realidade virtual.

Video: Brent Rose; Edição: Nick Strango