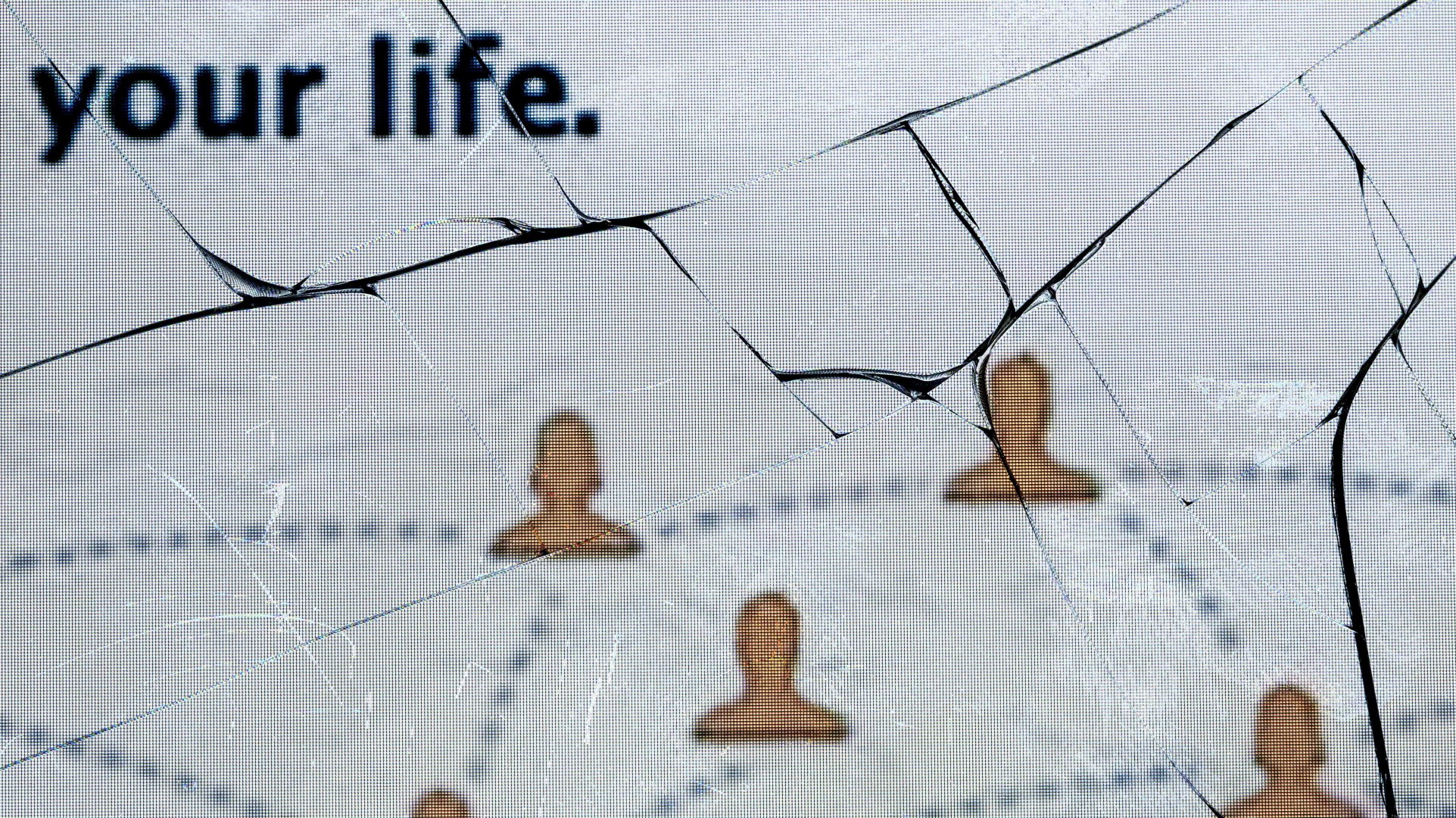

Todo momento horripilante amplificado pelas redes sociais segue o mesmo roteiro básico, e o ataque terrorista mortal transmitido ao vivo no Facebook ocorrido na Nova Zelândia, que deixou pelo menos 50 mortos e dezenas de pessoas machucadas, tem todos os pontos de enredo habituais de ódio viralizando online.

O atirador publicou um streaming ao vivo de seu massacre no Facebook, transmitindo por 17 minutos. O Facebook, no fim das contas, removeu a transmissão depois de a polícia sinalizá-la, mas o vídeo se espalhou além de sua audiência inicial, em redes como YouTube, Reddit, Twitter e outras plataformas. Ele foi publicado novamente inúmeras vezes, disseminando violência e a ideologia de ódio do atirador a milhões de pessoas. As empresas, é claro, dizem que estão trabalhando fervorosamente para derrubar os vídeos repostados.

Já vimos isso diversas vezes, então a pergunta é obrigatória: por que essas grandes empresas de tecnologia são tão ruins em bloquear os vídeos do atirador da mesquita de suas plataformas? Por que elas falham em impedir que conteúdo radicalizante, racista e de ódio sature seus sites? Por que o Vale do Silício efetivamente falha em policiar suas plataformas? O problema vai muito além de um vídeo de assassinato em massa — e vai direto ao coração da riqueza e do poder do Vale do Silício.

“A escala é o problema”, disse o escritor Antonio Garcia Martinez, ex-gerente de publicidade do Facebook, no Twitter na sexta-feira (15), quando perguntado sobre o que está por trás dessa dificuldade.

Para o Vale do Silício, a escala de suas plataformas é o que as torna multibilionárias. A escala sem precedentes é uma criação intencional projetada para um lucro sem precedentes. Para executivos, acionistas e engenheiros que buscam um bônus e aumento, escala é tudo.

Escala também é sempre sua desculpa.

Como elas mesmas admitem, essas empresas são grandes demais para conseguir moderar efetivamente suas plataformas, particularmente em um caso como o vídeo explosivo de violência em massa de sexta-feira. Então, se elas são grandes demais para resolver esse problema, talvez seja hora de reduzir sua escala.

“A rápida e ampla disseminação desse conteúdo de ódio — ao vivo no Facebook, publicado no YouTube e amplificado no Reddit — mostra o quão facilmente as maiores plataformas ainda podem ser mal utilizadas”, disse o senador democrata Mark Warner em um e-mail para o Gizmodo. “Está cada vez mais claro que o YouTube, em particular, ainda tem que lutar contra o papel que tem desempenhado na facilitação da radicalização e do recrutamento.”

Se os próprios executivos de tecnologia estão, em sua própria maneira velada, reconhecendo que suas empresas são grandes demais, talvez devêssemos ouvi-los.

É difícil conhecer completamente a dimensão exata dessas empresas, devido à sua falta de transparência. O Facebook não respondeu a um pedido de comentários sobre o assunto, mas a empresa diz que tem 30 mil funcionários e inteligência artificial encarregados de remover conteúdo de ódio. O YouTube, que aparentemente vê 500 minutos de vídeos publicados a cada segundo, disse em seu último relatório trimestral que, no quarto trimestre de 2018, o site removeu 49.618 vídeos e 16.596 contas por violar políticas de promoção da violência ou de extremismo violento. Eles também removeram 253.683 vídeos violando políticas de violência explícita.

Na semana passada mesmo, a CEO do YouTube, Susan Wojcicki, disse a mesma coisa quando a jornalista Kara Swisher perguntou à executiva por que os neonazistas continuam prosperando e crescendo no YouTube e por que os comentários do site são um lugar notoriamente vil — recentemente, por exemplo, surgiram denúncias de que ele vem sendo usado por pedófilos para se conectarem. Sua resposta: a escala é o problema.

Defendendo sua empresa, Wojcicki disse que mais de 500 horas de vídeo são publicadas no YouTube a cada minuto e que milhões de comentários ruins são removidos a cada trimestre. “Mas você tem que perceber que o volume que temos é muito substancial, e estamos trabalhando para dar aos criadores mais ferramentas para que eles também sejam capazes de gerenciar isso”, disse a CEO.

Espera aí, exatamente de quem é a responsabilidade de gerenciar a proliferação de grupos nazistas e pedófilos em sites como o YouTube? Dos usuários? No YouTube, pelo menos, a resposta é, aparentemente, sim.

Quando a conta do YouTube no Twitter postou no início da sexta-feira que a empresa estava “de coração partido” com as mortes na Nova Zelândia, ela provocou uma reação.

“Desculpe, mas ninguém quer saber se o YouTube está de coração partido”, disse Jackie Luo, engenheira da indústria de tecnologia do Vale do Silício. “Vidas foram perdidas, mais vidas serão. O YouTube é cúmplice — não tanto por causa das filmagens de ontem, mas por causa do enorme papel que ele tem desempenhado e continua a desempenhar na normalização e disseminação desse tipo de retórica violenta. É enfurecedor ver uma empresa que lucra enormemente enviando pessoas comuns em um poço sem fundo de vídeos que as radicalizam a ponto de ter esse tipo de crença e, então, faz uma notinha de pesar nas redes sociais, sendo que esse modelo produz consequências reais e terríveis.”

O notório problema de radicalização do YouTube é o combustível para o fogo que é a escala. O objetivo é fazer com que mais pessoas assistam, publiquem, assistam, publiquem e consumam propagandas o tempo todo. Esse é o negócio todo. A radicalização é uma forma especialmente eficaz e lucrativa de atingir a meta de crescimento.

“Isso não acontece porque uma seita de engenheiros do YouTube está tramando para derrubar o mundo de um penhasco”, escreveu o acadêmico Zeynep Tufekci no ano passado. “Uma explicação mais provável tem a ver com o nexo entre a inteligência artificial e o modelo de negócios do Google (o YouTube é propriedade do Google). Apesar de toda sua retórica sublime, o Google é um negociante de publicidade, vendendo a nossa atenção para as empresas que vão pagar por isso. Quanto mais tempo as pessoas ficarem no YouTube, mais dinheiro o Google ganha.”

Levar os usuários à próxima voz radical faz parte do negócio fundamental dessas empresas — a equação é essa: número de olhos vendo [mais] horas de visualização [é igual a] dólares de anúncios.

Em uma época em que os legisladores de Washington estão falando sobre desmantelar as grandes empresas de tecnologia, é muito interessante ver um executivo de tecnologia reconhecer que sua plataforma é grande demais para lidar com a responsabilidade que ela mesma trouxe.

“Desculpe, mas ninguém quer saber se o YouTube está de coração partido.”

Eu tenho minha própria pequena experiência com o modelo de negócios de radicalização do YouTube, embora de uma forma muito mais inofensiva. Sou um corredor que, até há poucos anos, adorava corridas rápidas de 5 km. Quando comecei a usar mais o YouTube para assistir a vídeos de corrida, os vídeos recomendados e de reprodução automática continuavam me empurrando cada vez mais adiante. Estranhamente, ele presumiu que um corredor de 5 km iria querer correr maratonas e depois ultramaratonas. Eu fiquei obedientemente assistindo aos conteúdos antes de correr uma meia maratona no mês passado.

Se isso significa assistir a mais vídeos, o YouTube busca fazer de todos nós radicais corredores de ultramaratonas, porque, supostamente, a radicalização cria consumidores de conteúdo confiáveis e lucrativos.

Na sexta-feira, mais de 12 horas depois do evento em si, vídeos do atirador em Christchurch, na Nova Zelândia, matando muçulmanos que oravam em uma mesquita continuaram a se espalhar pela internet, em sites como Facebook, YouTube e Twitter, redes usadas como ferramentas de propaganda para nacionalistas brancos de extrema-direita.

“A escala é o principal problema tanto para o Facebook quanto para o YouTube”, tuitou Siva Vaidhyanathan. “Eles seriam inofensivos com menos de 50 milhões de usuários.”

A reação da Nova Zelândia, onde ocorreu o ataque, é menos tolerante.

“O fracasso em lidar com isso de forma rápida e decisiva representa uma total abdicação de responsabilidade por parte das empresas de rede social”, disse Tom Watson, vice-líder do Partido Trabalhista do Reino Unido. “Isso já aconteceu vezes demais. Não retirar esses vídeos imediatamente e impedir que outros fossem carregados é uma falha de decência.”

O argumento de que a escala é o problema e nunca pode ser completamente resolvido vem implicitamente embalado com a ideia de que a forma como as coisas são é a forma como as coisas têm de ser. A desculpa se alinha bem com o fato de que a velocidade rápida, o crescimento e a escala acontecem para dar a essas empresas já muito rentáveis ainda mais dinheiro.

“Lamento que o status quo, que nos torna extremamente ricos, possa ser tão terrível”, dizem eles. “Mas o que é que podemos fazer?”

Extremism researchers and journalists (including me) warned the company in emails, on the phone, and to employees’ faces after the last terror attack that the next one would show signs of YouTube radicalization again, but the outcome would be worse. I was literally scoffed at. https://t.co/z0OPqfJJw6

— Ben Collins (@oneunderscore__) 15 de março de 2019

(“Pesquisadores sobre extremismo e jornalistas (incluindo eu) avisaram à empresa por e-mails, telefone e cara a cara com os funcionários após o último ataque terrorista que o próximo mostraria sinais de radicalização do YouTube novamente, mas o resultado seria pior. Literalmente zombaram de mim.”)

A escala é um teste de Rorschach no Vale do Silício. Por um lado, é um objetivo quando um executivo de tecnologia está em uma reunião de lucros. Por outro lado, é uma desculpa se for um porta-voz da indústria de tecnologia pedindo desculpas à imprensa sobre as falhas da companhia.

Se os próprios executivos de tecnologia estão, em sua própria maneira velada, reconhecendo que suas empresas são grandes demais, talvez devêssemos ouvi-los.

Na Europa, os reguladores estão analisando de perto a possibilidade de multar as plataformas de redes sociais que não conseguem remover conteúdo extremista dentro de uma hora. “Uma hora é a janela de tempo decisiva em que ocorrem os maiores danos”, afirmou Jean-Claude Juncker no Discurso sobre o Estado da União do ano passado no Parlamento Europeu.

“Precisamos de ferramentas fortes e direcionadas para vencer essa batalha online”, declarou Vera Jourova, comissária europeia da Justiça.

O problema está também atraindo a atenção nos Estados Unidos.

“Precisamos de ferramentas fortes e direcionadas para vencer essa batalha online.”

Cada vez mais, os políticos americanos querem fazer algo sobre a escala e o poder das empresas de tecnologia. Recentemente, a candidata presidencial democrata e senadora Elizabeth Warren propôs dividir as grandes empresas de tecnologia. Separar as grandes empresas americanas de tecnologia pressionaria “todos no mercado a oferecer produtos e serviços melhores”.

As empresas do Vale do Silício “têm um problema de moderação de conteúdo que está fundamentalmente além da escala com que sabem lidar”, disse Becca Lewis, pesquisadora da Universidade de Stanford e do think tank Data & Society, ao Washington Post. “Os incentivos financeiros estão em jogo para manter o conteúdo em primeiro lugar e a monetização em primeiro lugar. Qualquer tratamento das consequências negativas que daí possam advir é reativo.”

No momento, os incentivos se alinham de forma que o Vale do Silício continuará a ser ruim no policiamento das plataformas que criou. Os incentivos podem ser mudados. Na linguagem que o Vale do Silício consegue entender, há maneiras inovadoras de interromper a espiral descendente da indústria de rede social. Uma delas se chama regulamentação.