Facebook vai acrescentar três mil pessoas para vigiar conteúdos de assassinato e suicídio

O Facebook tem um problema. Não aquele em que eles admitiram ser um megafone para propaganda e operações psicológicas federais. Ou aquele em que passaram informações psicológicas de adolescentes em risco para anunciantes. Não, a notícia desta quarta-feira diz respeito a como esse enorme coletor de dados sociais tem se tornado (cada vez mais) uma indesejada plataforma para que usuários façam transmissões ao vivo de crimes violentos, atos sexuais, exploração infantil e suicídio.

• Facebook admite em relatório que pode ser utilizado para influenciar decisões políticas

• Pesquisadores propõem novos direitos humanos para proteger nossas mentes do Facebook

Em uma publicação nesta quarta-feira, Mark Zuckerberg prometeu que, no próximo ano, o Facebook vai “acrescentar três mil pessoas à nossa comunidade de equipe de operações em todo o mundo — além das 4.500 que temos hoje — para revisar os milhões de relatórios que recebemos todas as semanas, melhorando o processo para fazê-lo rapidamente”. O CEO também prometeu construir ferramentas de denúncia adicionais para que os usuários do Facebook possam oferecer melhor assistência à empresa na derrubada de vídeos ofensivos.

É louvável que o Facebook enfrente esse problema aumentando efetivamente sua equipe de operações, especialmente considerando que evidências sugerem que os suicídios possam levar a uma “contaminação” de casos subsequentes. No entanto, o que está notavelmente faltando na publicação de Zuckerberg são os detalhes concretos em relação ao status de contratação, treinamento e suporte a esses três mil novos membros da equipe.

Reportagens ao longo dos últimos anos revelaram que muitas das maiores empresas do mundo terceirizam suas equipes de moderação, deixando para trabalhadores estrangeiros mal remunerados — que podem não ter conhecimento profundo dos costumes sociais americanos — a tarefa de supervisionar publicações no dia a dia. Assistir a assassinatos ou suicídios por meses ou anos a fio pode causar o desenvolvimento de problemas psicológicos muito reais nos moderadores, e vários ex-moderadores com quem conversei afirmaram ter sofrido de estresse pós-traumático após vasculharem vários conteúdos violentos, discursos de ódio ou até mesmo após terem sido, eles próprios, vítimas de abuso por parte de usuários.

Se os funcionários que o Facebook pretende contratar para o único propósito de remover seus vídeos mais perturbadores forem prestadores de serviço e não membros da equipe, como pode ser o caso, a empresa pode não ser obrigada a oferecer plano de saúde, muito menos aconselhamento.

O Facebook, como muitas redes sociais, tem dois conjuntos de regras: as mais amplas com as quais os usuários concordam e as granulares que os moderadores são instruídos a impor. A lentidão tanto nas políticas quanto no treinamento levaram a incidentes como a gafe memorável do site de derrubar uma foto da guerra do Vietnã, vencedora do Pulitzer, e apenas restaurá-la após o clamor público alcançar um ápice. Cenas fortes de assassinato e suicídio são intuitivamente perturbadoras em qualquer cultura, mas, além desses exemplos mais extremos, treinar moderadores para serem eficazes consome tempo e recursos em que maioria das empresas não está interessada em investir.

Um porta-voz do Facebook disse ao Gizmodo que eles “não têm mais detalhes a compartilhar no momento além da publicação do Mark”, mas que a empresa oferece apoio àqueles revisando o conteúdo da plataforma. Colocando na balança, menos espaço para a transmissão desses tipos de vídeos é algo positivo, mas lembre-se que provavelmente isso virá ao custo da saúde mental de outras 7.500 pessoas em algum lugar do mundo.

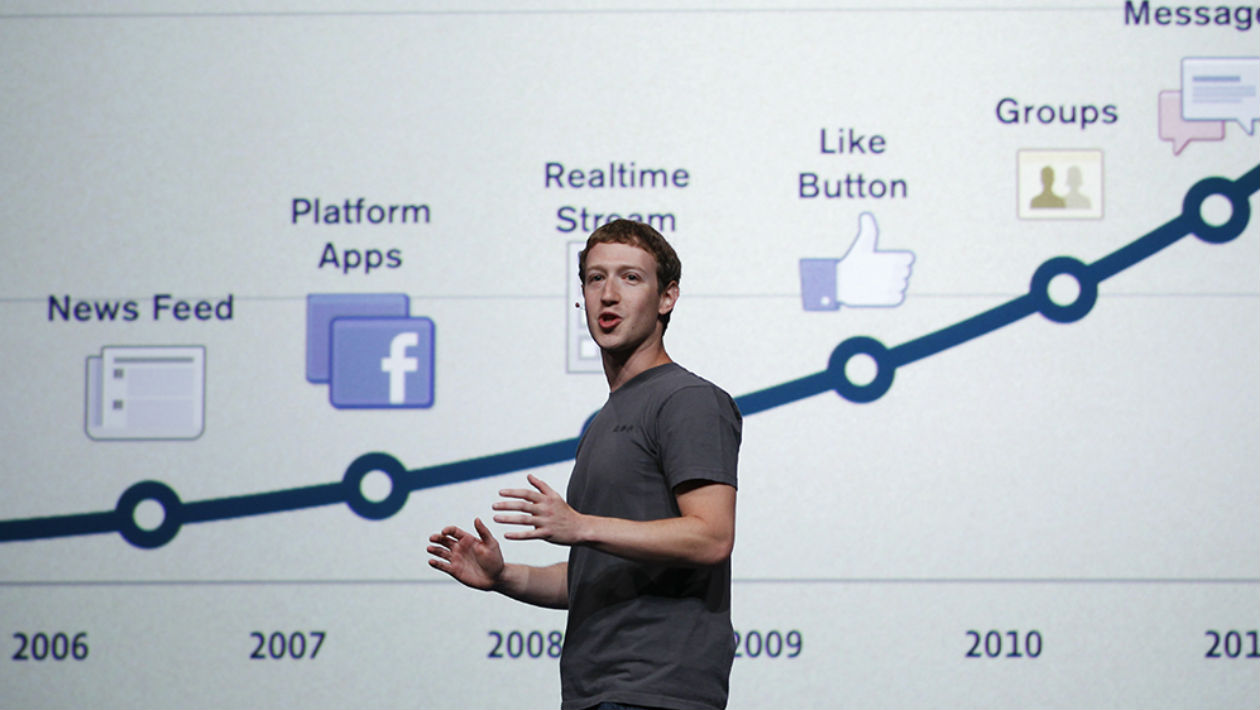

Imagem do topo: AP