Algoritmo de manipulação de imagem consegue enganar máquinas e humanos

Cientistas da computação do Google Brain desenvolveram uma técnica que engana redes neurais e as fazem identificar imagens de maneira equivocada – o truque também funciona com humanos.

Imagens “contraditórias” podem ser usadas para enganar tanto humanos quanto computadores, como reporta Evan Ackerman na revista IEEE Spectrum. O algoritmo, desenvolvido pelo pessoal do Google Brain, pode modificar fotos para que sistemas de reconhecimento de imagem as interpretem de forma equivocada.

• Os robôs do Google são capazes de transformar fotos em baixa resolução em algo que presta

• Conseguiram tirar o bigode do Super-Homem da Liga da Justiça só com IA e um PC barato

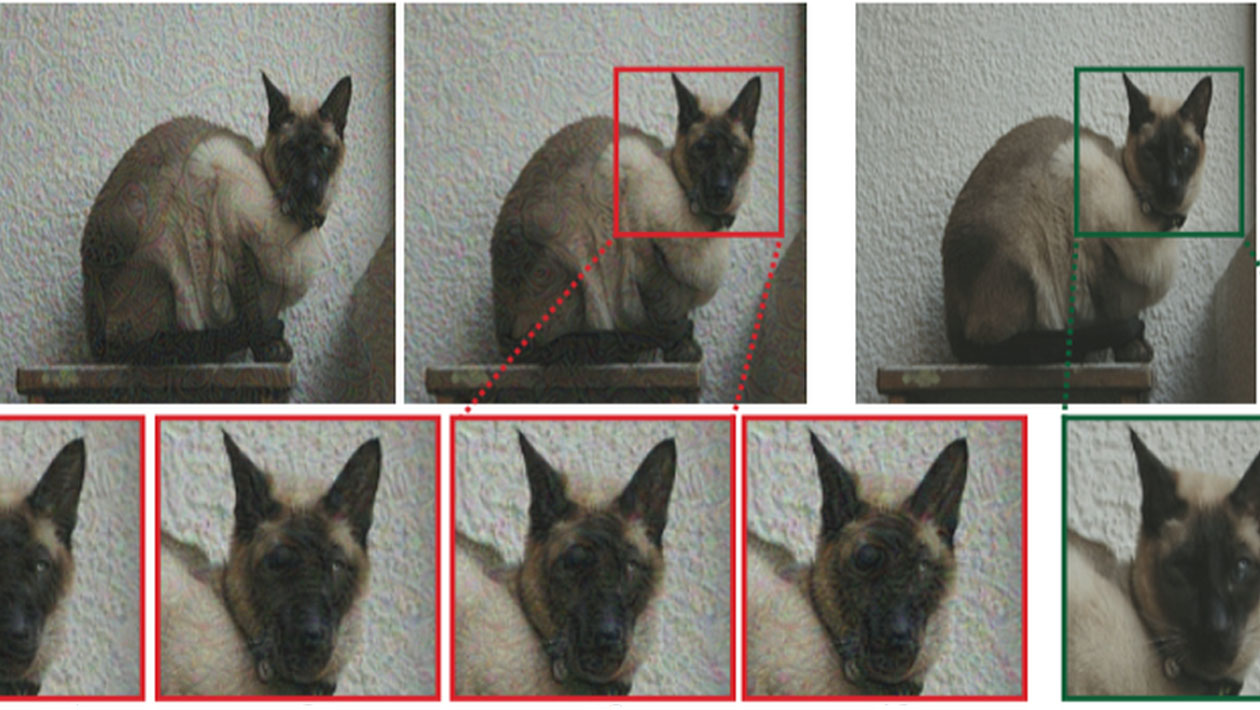

Em testes, uma rede rede neural convolucional (CNN) – uma ferramenta utilizada no machine learning (aprendizado de máquina) para analisar e identificar imagens – foi enganada a pensar que, por exemplo, uma foto de um gato é na verdade de um cão.

Esquerda: imagem não modificada de um gato. Direita: imagem “controversa”, modificada para se parecer um cão. Crédito: Google Brain

Esquerda: imagem não modificada de um gato. Direita: imagem “controversa”, modificada para se parecer um cão. Crédito: Google Brain

O mais fascinante é que os humanos foram enganados da mesma forma, uma descoberta que sugere que cientistas estão chegando perto de desenvolver sistemas que enxergam o mundo da mesma maneira que nós. O problema, no entanto, é que isso também significa que estamos melhorando a capacidade de enganar as pessoas.

O estudo ainda não foi publicado, mas já está disponível no servidor de pré-impressão do arXiv.

As redes CNN são, na verdade, bem fáceis de enganar. As abordagens a visão computadorizada baseadas em máquinas não analisam objetos da mesma forma que eu e você. A inteligência artificial procura por padrões ao analisar meticulosamente cada pixel em uma foto e percebendo onde ficam cada ponto dentro de uma imagem maior.

Depois, a máquina combina o padrão geral a um objeto pré-identificado e pré-aprendido, como a imagem de um elefante. Humanos, por outro lado, possuem um método mais holístico. Para identificar um elefante, procuramos atributos físicos específicos, como quatro patas, pele cinza, orelhas grandes e uma tromba.

Somos bons em ter um senso de ambiguidade e extrapolar o que pode existir além das fronteiras da fotografia. A inteligência artificial não tem sorte com isso.

Para dar uma ideia do quão fácil é enganar uma rede neural artificial, um único pixel movido enganou uma máquina a pensar que uma tartaruga era na verdade um rifle, como mostraram pesquisadores japoneses no ano passado. Há alguns meses, pesquisadores do Google Brain enganaram uma inteligência artificial e fizeram ela pensar que uma banana era uma torradeira, simplesmente colocando uma etiqueta na imagem. Algoritmos já acharam que esquiadores eram cães e uma bola de beisebol era um café espresso.

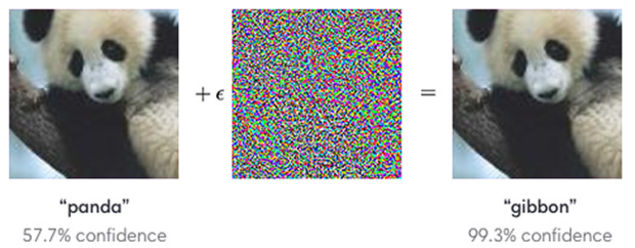

Para zoar com uma inteligência artificial, como ilustram esses exemplos, basta colocar uma “perturbação” dentro da imagem. Seja um pixel no lugar errado ou padrões de ruído que, embora sejam invisíveis para humanos, são capazes de convencer um bot de que um panda é gibão.

Uma imagem não modificada de um panda (esquerda), quando misturada com uma “perturbação” (centro), faz uma inteligência artificial pensar que se trata de um gibão (direita). Crédito: OpenAI/Google Brain

Uma imagem não modificada de um panda (esquerda), quando misturada com uma “perturbação” (centro), faz uma inteligência artificial pensar que se trata de um gibão (direita). Crédito: OpenAI/Google Brain

Mas esses exemplos tendem a envolver um único classificador de imagem, cada um aprendido a partir de um conjunto de dados separados. No novo estudo, os pesquisadores do Google Brain tentaram desenvolver um algoritmo que poderia produzir imagens controversas que fossem capazes de enganar diversos sistemas.

Além disso, os pesquisadores queriam saber se imagens controversas que enganam toda uma série de classificadores de imagens poderiam enganar também os humanos. A resposta é sim.

Para fazer isso, eles precisaram criar perturbações mais “robustas”, isto é, criar manipulações que poderiam enganar uma gama de sistemas, incluindo humanos. Isso exigia a adição de “características significativas para humanos”, para a alteração da borda dos objetos, valorização dos cantos com o ajuste de contraste, modificação de textura e exploração de regiões escuras que podem amplificar o efeito de perturbação.

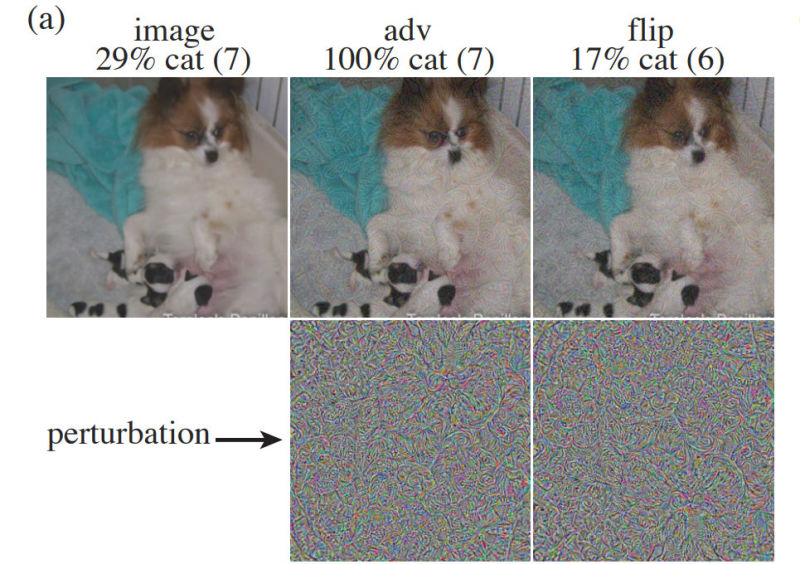

Da esquerda para a direita: Imagem não modificada de um cachorro, uma imagem controversa na qual o cachorro foi modificado para se parecer com um gato e uma imagem de controle na qual a perturbação é invertida. Crédito: Google Brain

Da esquerda para a direita: Imagem não modificada de um cachorro, uma imagem controversa na qual o cachorro foi modificado para se parecer com um gato e uma imagem de controle na qual a perturbação é invertida. Crédito: Google Brain

Nos testes, os pesquisadores conseguiram desenvolver um gerador de imagens controversas capaz de criar arquivos que, em alguns casos, enganou 10 dos 10 modelos de machine learning baseados em CNN. Para testar a efetividade em humanos, experimentos foram feitos nos quais os participantes viram uma foto não modificada, uma foto controversa que enganou 100% das máquinas CNN e uma foto com a camada de perturbação invertida.

Os participantes não tinham muito tempo para processar visualmente as imagens, apenas algo entre 60 e 70 milissegundos. Depois disso, era pedido para que identificassem os objetos da foto. Em um exemplo, um cachorro foi modificado para se parecer com um gato – uma imagem controversa que foi identificada pelas máquinas por gato 100% das vezes.

No geral, os humanos tiveram mais dificuldades para distinguir os objetos das imagens controversas se comparado com as fotos não modificadas. Isso significa que a alteração das imagens pode afetar os humanos, também.

Fazer um humano pensar que um cão é um gato ao transformar, literalmente, o cão em um gato não parece ser algo profundo. No entanto, isso revela que os cientistas estão mais perto de criar sistemas de reconhecimento de imagem que processam imagens de uma forma similar com a qual nós fazemos. No final das contas, isso vai resultar em sistemas de reconhecimento de imagem mais precisos, o que é bom.

A ameaça, no entanto, está na produção de imagens, áudio ou vídeos falsos ou modificados. Os pesquisadores do Google Brain se preocupam com o fato de que as imagens controversas poderiam ser um dia usadas para gerar notícias falsas e para manipular sutilmente as pessoas.

“Por exemplo, uma combinação de modelos profundos pode ser treinado com o olhar humano para fidedignidade de rostos”, escrevem os autores. “A partir disso, poderia ser possível gerar perturbações controversas que aumentam ou reduzem as impressões humanas de fidedignidade, e essas imagens perturbadas poderiam ser utilizada em notícias ou campanhas políticas”.

Um político que está concorrendo a um cargo poderia utilizar essa tecnologia para ajustar o seu rosto em um anúncio na TV, fazendo com que ele se pareça mais confiável para o espectador. É como se fosse uma publicidade subliminar, mas que toca nas vulnerabilidades e no inconsciente do cérebro humano.

Os pesquisadores também apontam algumas possibilidades mais animadoras, como a utilização desses sistema para tornar imagens entediantes em algo mais atraente. Como exemplo, temos dados de tráfego aéreo ou imagens de radiologia. É claro, a inteligência artificial tornaria esses trabalhos obsoletos de qualquer maneira.

Como Ackerman aponta: “Estou muito mais preocupado com toda essa invasão sobre como meu cérebro percebe se as pessoas são confiáveis ou não, sabe?”

Imagem do topo: Google Brain