A Intel está criando uma mochila para ajudar cegos se locomoverem pela cidade

A Intel apresentou nesta semana uma mochila equipada com inteligência artificial ativada por voz, capaz de ajudar deficientes visuais a identificar alguns desafios cotidianos para mobilidade como sinais de trânsito, obstáculos suspensos, faixas de pedestres e objetos em movimento com precisão e segurança.

“Ano passado encontrei um amigo que é deficiente visual e me dei conta de que já ensinei robôs a ler, mas que ainda existem muitas pessoas que não enxergam e precisam de ajuda. Foi o que me levou a criar o sistema de assistência visual usando o Kit de Inteligência Artificial com Profundidade da OpenCV (OAK-D), desenvolvido pela Intel”, explica Jagadish K. Mahendran, responsável principal pelo projeto e desenvolvedor de IA do Instituto de Inteligência Artificial na Universidade da Geórgia, nos EUA, no comunicado.

O objetivo de Mahendran e sua equipe era produzir um sistema que pudesse ter uma maior percepção de profundidade e da distância dos objetos para um deslocamento mais seguro, diferente das aplicações que já existem no mercado como smartphones assistidos por voz com uso de GPS e bengalas inteligentes habilitadas por câmera. Para isto, eles entrevistaram várias pessoas, que apresentaram suas principais queixas e as melhorias que esperavam para futuras tecnologias.

Como funciona a mochila da Intel

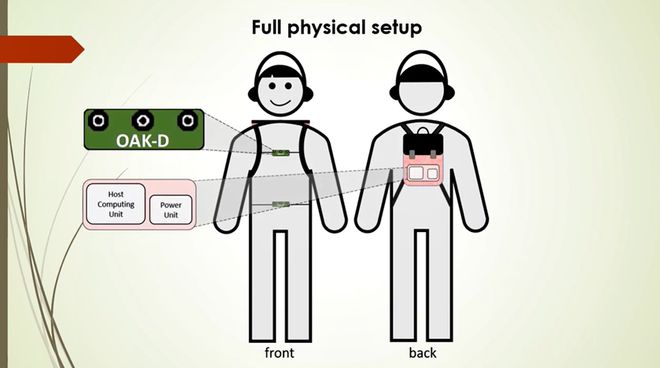

Junto com a mochila é preciso usar uma pochete, que guarda a bateria com duração aproximada de oito horas, assim como uma espécie de colete, com acoplamento de uma câmera tripla IA espacial OAK-D da Luxonis, que executa o Movidius VPU da Intel e é programada usando o kit de ferramentas OpenVINO.

Localização cada parte do sistema criado na aparelhagem. Imagem: Reprodução/Intel.

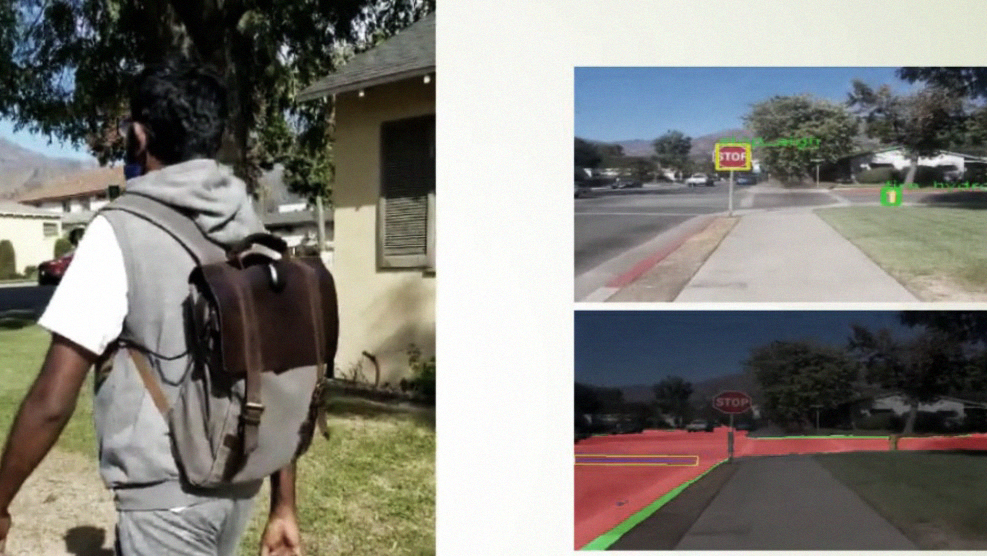

As câmeras vão fornecer, a partir do processamento de redes neurais avançadas, vários dados referentes a funções de visão computacional acelerada, como um mapa de profundidade de visão estéreo em tempo real, bem como informações em cores RGB a partir de uma única câmera 4K, que traçam os caminhos e obstáculos pelo caminho. “

O comando de voz fica por meio de um fone de ouvido habilitado para Bluetooth, que permite ao usuário interagir com o sistema, que responde com informações verbais, como a Alexa da Amazon.

Conforme o usuário se move pelo ambiente, a mochila compartilha de forma audível informações sobre obstáculos comuns, incluindo placas, galhos de árvores e até outros pedestres. Ele também alerta quando faixas de pedestres, guias, escadas e entradas de edifícios são detectados.

De acordo com a empresa, por enquanto, este projeto é apenas de cunho cientifico, e “será aberto para contribuintes que desejam somar ao projeto, seja com códigos, modelos e conjuntos de dados”. Além disso, o projeto completo será publicado como um artigo de pesquisa em um futuro próximo.