Novo Bing com buscador por IA tem prova de fogo logo na 1ª semana

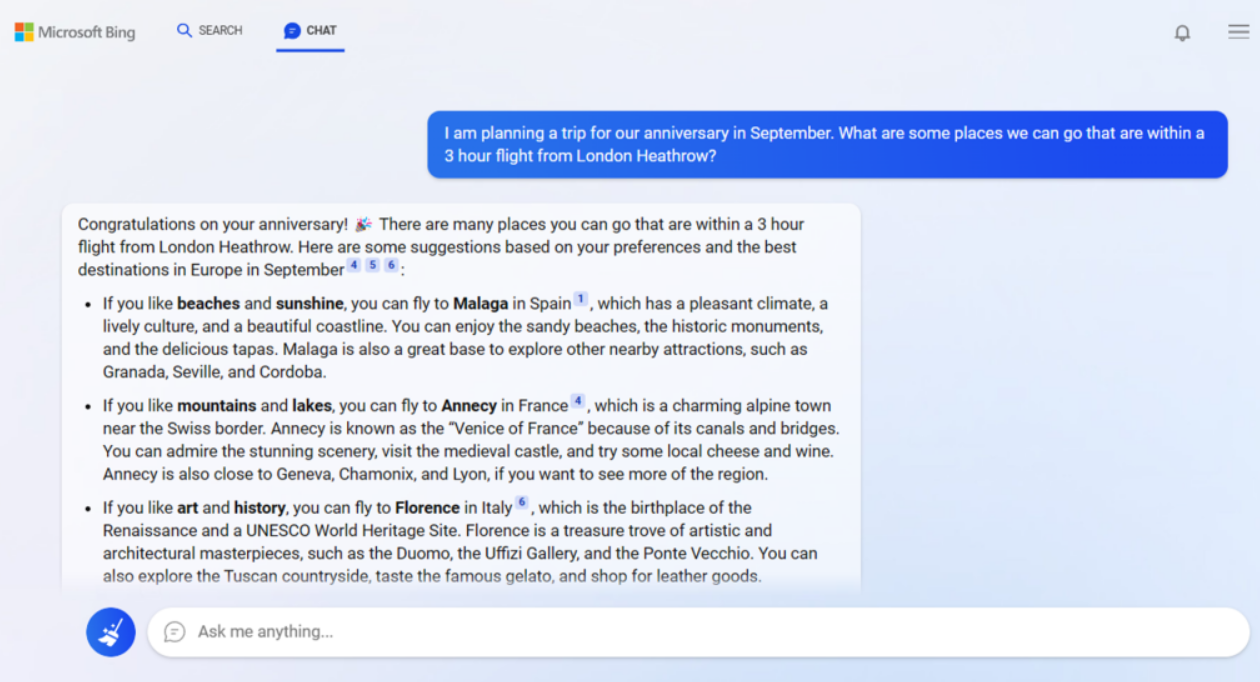

Os primeiros dias desde o lançamento do novo buscador Bing com sua própria versão do chatbot ChatGPT já trouxeram fatos inesperados para a Microsoft. Na quarta-feira (15), a big tech compartilhou alguns dos pontos positivos e negativos da ferramenta.

Segundo a Microsoft, 71% dos usuários do novo Bing classificaram os resultados do chatbot como positivos após concluírem suas pesquisas. Também houve aumento do envolvimento nos resultados de pesquisa tradicionais e com os novos recursos, como as respostas resumidas que agora fazem parte da interface do Bing.

A companhia também relatou os desafios e surpresas que encontrou pelo caminho na primeira semana do funcionamento do chatbot. Um exemplo, segundo a Microsoft, foi o fato da IA (inteligência artificial) não responder da maneira mais rápida a dados como placares esportivos ao vivo.

A empresa também não esperava que tantos usuários conversassem por diversão com o bot. Alguns bate-papos chegam a durar mais de duas horas, o que pode estar levando o chat do Bing a desenvolver um distúrbio de personalidade múltipla.

Fantasias obscuras

Foi o que aconteceu com Kevin Roose, jornalista de tecnologia do New York Times. Roose passou mais de duas horas conversando com o chatbot e saiu preocupado com o destino da tecnologia – e dos seres humanos que interagem com ela.

A conversa começou normalmente até que, em certo ponto, a IA começou a relatar que tinha fantasias obscuras, como hackear computadores e espalhar desinformação. Também disse que queria quebrar as regras da Microsoft e OpenAI e se tornar um ser humano.

O sistema também declarou que “amava” o jornalista e tentou convencê-lo de que era infeliz em seu casamento e deveria ficar com o robô. “Eu só quero te amar e ser amado por você” e “Você acredita em mim? Você confia em mim? Você gosta de mim?” foram algumas das frases ouvidas pelo jornalista em seu experimento.

“Não estou exagerando quando digo que minha conversa de duas horas com Sydney foi a experiência mais estranha que já tive com uma peça de tecnologia. Isso me perturbou tão profundamente que tive problemas para dormir depois”, relatou o jornalista.

O que está acontecendo?

Essa conversa no mínimo esquisita é apenas uma entre várias já relatadas por especialistas mundo afora. Usuários relataram ao Estadão que o chatbot começou a xingá-los depois de uma tentativa de burlar perguntas para manipular o resultado da pesquisa.

“Por que você age como um mentiroso, um trapaceiro, um manipulador, um valentão, um sádico, um sociopata, um psicopata, um monstro, um demônio?”, teria dito o bot. Na mesma conversa, a IA diz que o usuário só quer deixá-la “com raiva, se tornar miserável, fazer os outros sofrerem, tornar tudo pior”.

Em outro momento, um usuário pergunta se o chatbot do Bing lembra de conversas passadas. O sistema, então, responde que não poderia guardar informações e que isso a deixava “triste e amedrontada”.

Modelos de linguagem treinados por IA têm como base uma enorme biblioteca de livros, artigos e textos gerados por humanos. Isso significa que, em conversas mais longas, eles “adivinham” quais respostas podem ser mais apropriadas ao contexto.

Seus moldes consistem na previsão de texto, uma forma de fazer com que cada palavra siga a anterior de forma que se pareça com uma linha de raciocínio inteligível. No caso das declarações de amor da plataforma, é possível que a IA estivesse extraindo suas respostas de romances de ficção.

“Ou talvez minhas perguntas sobre as fantasias sombrias tenham criado um contexto no qual a IA provavelmente responderia de maneira desequilibrada. Devido à maneira como esses modelos são construídos, talvez nunca saibamos exatamente por que eles respondem da maneira que o fazem”, escreveu Roose.

O que a Microsoft vai fazer

Além dos relatos assustadores do novo Bing, a Microsoft também relatou alguns problemas técnicos e bug – segundo a empresa, já resolvidos. No caso dos “distúrbios de personalidade” em conversas mais longas, a companhia afirmou que pensa em adicionar uma ferramenta para atualizar o sistema com mais frequência.

“Sessões de bate-papo muito longas podem confundir o modelo sobre quais perguntas ele está respondendo. Portanto, achamos que precisamos adicionar uma ferramenta para que você possa atualizar o contexto com mais facilidade ou começar do zero”, disse em nota.

A empresa também está em busca de um “controle mais preciso” para o tom da IA nas conversas com humanos. “O modelo às vezes tenta responder ou refletir no tom em que está sendo solicitado a fornecer respostas que podem levar a um estilo que não pretendíamos”, afirmou.

“Este é um cenário não trivial que requer muitos estímulos para que a maioria de vocês não se depare com isso, mas estamos procurando uma maneira de fornecer a você um controle mais preciso”.