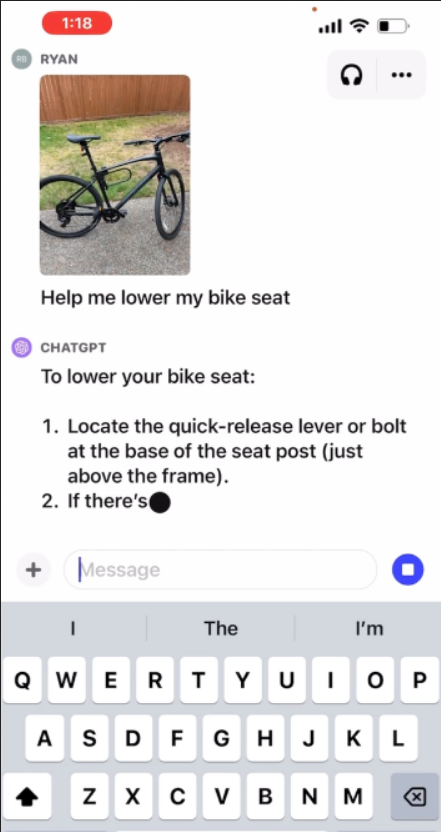

OpenAI anuncia que ChatGPT agora pode falar, ouvir e até ver

A OpenAI anunciou ontem (25) novos recursos para o ChatGPT que podem revolucionar ainda mais o mundo digital: falar, ouvir e até ler.

Agora, além do simples diálogo por texto, o ChatGPT permite que os usuários usem imagens em seus prompts e forneçam instruções ao falar com chatbot, que, por sua vez, também pode responder verbalmente.

Um avançado modelo de textos para voz IA possibilita que o ChatGPT pode agora imite vozes humanas com precisão surpreendente. Além disso, a nova habilidade de reconhecimento de imagem dá ao chatbot uma compreensão mais abrangente das consultas, transformando a interação com a IA.

Para fazer o ChatGPT falar, a OpenAI se juntou a dubladores famosos para criar cinco tons de voz diferentes, criando cinco distintas tonalidades.

A empresa também revelou uma parceria com o Spotify para que os podcasters da plataforma possam “traduzir seus programas do inglês para o espanhol, francês ou alemão”, mas mantendo sua voz original.

Entre os podcasters que vão participar dessa inovação estão Dax Shepard, Monica Padman, Lex Fridman, Bill Simmons e Steven Bartlett.

Imagem: OpenAI/Divulgação

Já a atualização de prompts que usam imagens foi possível graças à integração do ChatGPT ao DALL-E 3, também da OpenAI. Assim, ao falar, ouvir, ver, compreender vozes e identificar imagens, a OpenAI transforma o ChatGPT em uma IA com modelo multimodal.

Além disso, essas funcionalidades não apenas ampliam a grande utilidade do ChatGPT, mas sinalizam um futuro em que as plataformas de IA possam compreender o mundo ao seu redor.

No entanto, embora reconheça o potencial dessa nova tecnologia, A OpenAI está ciente dos riscos de tornar o ChatGPT multimodal.

Por isso, o lançamento será gradual e cauteloso. A atualização do ChatGPT chegará para os assinantes Plus e Enterprise nas próximas semanas, disponíveis nos aplicativos para Android e iOS.