Uma olhada de perto no Deep Fusion, o novo recurso de câmera do iPhone 11

Nesta semana, donos de iPhone 11 vão receber uma atualização grátis em suas câmeras graças a um motor neural e “ciência maluca”. Na verdade, o nome do recurso é Deep Fusion, e foi feito para entregar fotos incrivelmente detalhadas, especialmente em ambientes desafiadores. Passei as últimas semanas testando uma versão beta do software de fotografia computacional da Apple em um iPhone 11 Pro e fiquei comparando com a de um iPhone 11 Pro convencional. A verdade é que ele funciona, mas só nos cenários mais estranhos.

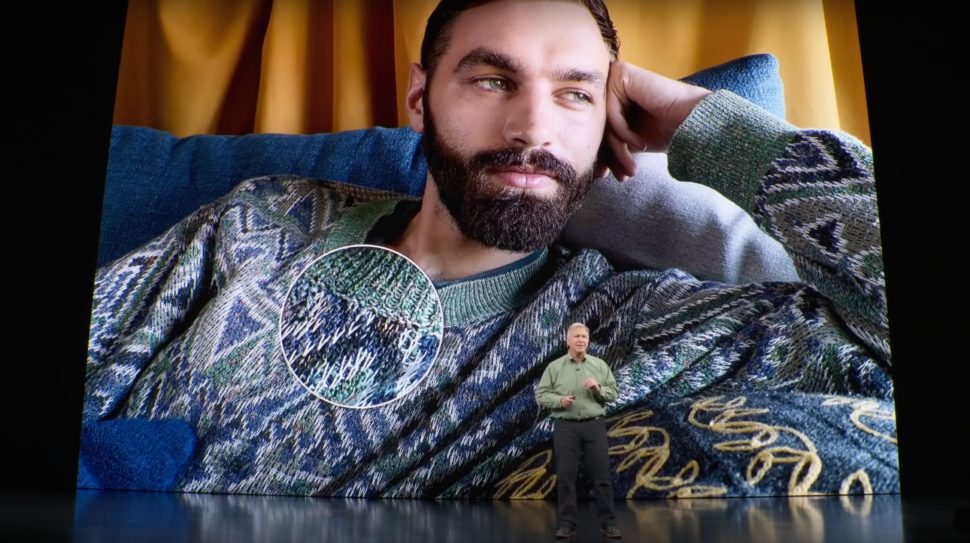

A primeira coisa que você precisa saber sobre o Deep Fusion é que a Apple tem muito orgulho do recurso. A empresa gastou vários minutos mostrando os recursos dele em seu evento de setembro, em que definiu o Deep Fusion como “a primeira vez que um mecanismo neural é responsável por gerar a imagem final de um app de câmera”.

Na prática, o processo consiste em fazer o iPhone tirar nove fotografias, e então o mecanismo neural do novo chip A13 Bionic essencialmente destaca os melhores pixels de cada imagem e “rearranja” a foto com mais detalhes e menos ruído comparado com um iPhone sem o recurso.

Entendendo o Deep Fusion

Permita-me falar um pouco mais sobre o processo, pois não é tão confuso quanto parece. O que a câmera do iPhone faz com oito dessas nove exposições é parecido com bracketing, uma técnica antiga de fotografia onde você tira a mesma foto com diferentes configurações.

Neste caso, a câmera do iPhone captura quatro quadros em exposição curta e quatro quadros de exposição padrão antes de você pressionar o botão do obturador. (A câmera do iPhone começa a capturar quadros de buffer assim que o app da câmera é aberto, caso precise deles para uma captura Deep Fusion ou Smart HDR.) Quando você pressiona o obturador, a câmera captura uma longa exposição que pega mais detalhes.

Captura de tela

Captura de tela

Todas essas exposições se tornam duas entradas para a ferramenta. A primeira entrada é o quadro de exposição curta com mais detalhes. A segunda é o que a Apple chama de “synthetic long” (longa sintética), resultando da fusão das fotos de exposição padrão com a longa exposição.

Tanto o disparo de curta exposição quanto o longo sintético são alimentados na rede neural que os analisa em quatro bandas de frequência diferentes, cada uma mais detalhada que a anterior. A redução de ruído é adicionada a cada imagem e, finalmente, os dois são fundidos em uma base pixel por pixel.

Todo esse processo leva cerca de um segundo, mas o aplicativo Câmera enfileira imagens proxy para que você possa continuar fotografando enquanto o mecanismo neural está funcionando, ou “deep fusioning” (fundindo de forma profunda, em tradução livre) todas as suas fotos.

Qual a diferença entre Deep Fusion e HDR?

Se você prestou muita atenção aos recursos de fotografia computacional da Apple, essa situação do Deep Fusion pode parecer muito com o recurso smart HDR lançado no ano passado com o iPhone XS.

Em teoria é semelhante, já que o iPhone captura constantemente essas imagens de buffer antes que a foto seja tirada evitar o atraso de obturador. Na prática, no entanto, o Deep Fusion não está apenas destacando os realces e as sombras de diferentes exposições para capturar mais detalhes. Ele está trabalhando em um nível hípergranular para preservar os detalhes que os quadros individuais podem ter perdido.

Ok, então talvez tudo isso seja meio complicado. Quando se trata de usar o novo iPhone com o Deep Fusion, você realmente não precisa pensar em como a mágica acontece, porque o dispositivo o ativa automaticamente.

Há algumas coisas importantes a saber quando o recurso funciona e não funciona.

- O Deep Fusion não funciona na câmera Ultra Wide.

- O Deep Fusion funciona apenas na câmera grande angular em cenários de baixa a média luz.

- O Deep Fusion funciona na maioria das vezes na lente telefoto, exceto em situações com muita iluminação, e aí ele não tem muito o que fazer nessas cenas.

Foto: Adam Clark Estes/Gizmodo

Foto: Adam Clark Estes/Gizmodo

Há ainda mais um cenário em que é garantido que ele nunca funcione. Se você ativou a nova opção Composição nas configurações do aplicativo Câmera, que diz “Capturar fotos fora do quadro”, o Deep Fusion nunca funcionará. Portanto, mantenha essa opção desativada se você quiser experimentar o Deep Fusion.

Deep Fusion na prática

Agora que todos os detalhes técnicos estão fora do caminho, vamos descobrir como é realmente a “ciência louca” da fotografia computacional do Deep Fusion.

Logo após o recurso Deep Fusion aparecer na versão beta pública do iOS 13.2, instalei o software no iPhone 11 Pro do Gizmodo, enquanto mantive a versão anterior do iOS sem Deep Fusion no meu iPhone 11 Pro. Depois, tirei um monte de fotos dos mais diversos ambientes. Francamente, muitas vezes não conseguia diferenciar entre a foto composta via Deep Fusion e a foto que não usa a ferramenta.

Dê uma olhada nessas duas fotos do relógio (abaixo) no meio do Grand Central Terminal, cada uma tirada com a câmera telefoto de um iPhone 11 Pro.

Você conseguiria dizer qual foi tirada com Deep Fusion e qual não foi? Se você quiser entender os símbolos básicos que inclui no canto de cada foto, você provavelmente conseguirá decifrar. Caso contrário, dará muito trabalho para discutir.

O fato é que tem uma diferença. Dê uma olhada nos números do relógio. Eles têm definição melhor na foto Deep Fusion. O mesmo acontece com as ondulações na bandeira americana e as texturas dos pilares de pedra ao redor dela. Você pode não notar que a foto sem o recurso está um pouco confusa nessas áreas, mas quando você vê a foto com Deep Fusion é possível ver que os detalhes são um pouco melhores.

Sutil, não? Mas neste caso, mesmo sem dar zoom, alguém pode claramente ver como as fotos com Deep Fusion têm menos ruído. As duas fotos mostram a impressionante performance do iPhone 11 Pro em cenários com pouca luz. O saguão principal do Grand Central Terminal é um local surpreendentemente escuro, especialmente ao entardecer, quando essas fotos foram tiradas. Ambas são bonitas, mas as com a novidade são um pouco melhores.

Agora, vamos olhar um exemplo diferente. Aqui (abaixo) uma foto tediosa e cheia de detalhes de um arranha-céu de Manhattan em um dia escuro e chuvoso. Neste caso, você precisa dar um zoom para ver algumas das diferenças sutis entra a foto do iPhone 11 Pro e a do aparelho com Deep Fusion. Elas são muito parecidas.

Você notará um pouco menos de ruído, e os reflexos na janela são mais claros na imagem da direita. A maior diferença que eu consigo ver está no parapeito branco no lado direito na parte de baixo do quadro. Parece quase borrado na foto que não é Deep Fusion. E, assim como os números do relógio da foto do Grand Central, a grade branca aparece na foto com Deep Fusion.

Este exercício de olhar para diferenças foi o que mais fiz nesse tempo testando a câmera com Deep Fusion contra a que não tinha. Ambas tiram fotos impressionantes, e o aparelho com Deep Fusion ocasionalmente tirava fotos melhores em determinados ambientes. Mais uma vez, o recurso funciona apenas em ambientes com pouca luz com a câmera grande angular e geralmente funciona em fotos tiradas com a lente telefoto, a menos que a cena esteja muito clara.

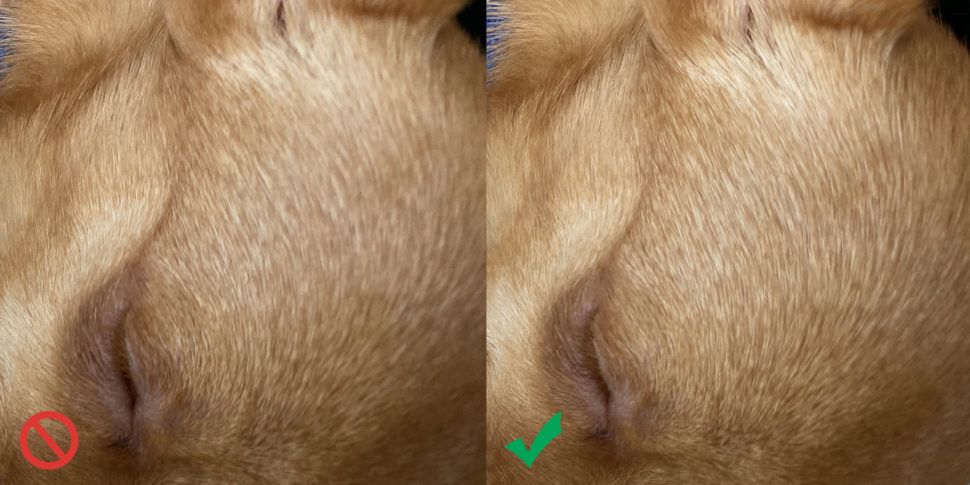

As coisas mudaram para mim quando comecei a tirar fotos de peles. Em teoria, esse é o tipo exato de cenário em que o Deep Fusion deve brilhar, já que pequenos fios de cabelo tendem a ficar embaçados, mas um mecanismo neural pode identificar esses detalhes e fundi-los em uma foto do Deep Fusion. Talvez por isso, a Apple tenha escolhido usar um homem barbudo em um suéter de textura fina para exibir o Deep Fusion durante sua apresentação em setembro. Minha versão de um homem barbudo com suéter de textura final é uma cachorrinha chamada Peanut.

Foto: Adam Clark Estes/Gizmodo

Foto: Adam Clark Estes/Gizmodo

Fofa, né? A Peanut pesa pouco mais de 1 kg e é coberta pela mais macia e fina pelagem castanha. Cada pelo tem uma cor ligeiramente diferente, o que quase faz parecer que ela fazer luzes em um salão de beleza para cachorros. Embora ela pareça angelical nessas duas fotos, é bastante fácil ver que, na foto à esquerda, seus pequenos destaques suaves ficam embaçados no alto da cabeça e na orelha. Na foto com Deep Fusion à direita, elas são muito nítidas. Dê uma olhada de perto:

Foto: Adam Clark Estes/Gizmodo

Foto: Adam Clark Estes/Gizmodo

Neste caso, a foto que não possui os poderes do Deep Fusion parece meio desfocada em determinados lugares. E quanto mais você aumenta o zoom, mais fica claro o poder do Deep Fusion. Dito de outra forma, nunca mais quero tirar outra foto da Peanut sem essa ferramenta.

Isso me leva a uma peça curiosa do quebra-cabeça do Deep Fusion. Ele é um quebra-cabeças, pois o fluxo de trabalho dele é confuso e, nos meus testes, às vezes era confuso dizer quando a tecnologia estava funcionando.

Também é um enigma, porque essas sutilezas parecem irrelevantes nesta primeira iteração do recurso. Por exemplo, se o Deep Fusion funcionava apenas ocasionalmente e apenas de maneiras muito específicas, por que a Apple fez tanto barulho sobre ele no evento e por que demorou mais de dois meses para que fosse disponibilizado ao público?

Na verdade, não sei as respostas destas perguntas, embora eu tenha uma teoria. Minha tese é que o Deep Fusion é um uma das tecnologias mais sofisticadas de fotografia computacional que a Apple já desenvolveu, e no momento, estamos vendo os primeiros frutos de suas capacidades. Posso ver um futuro no qual a Apple se baseia no Deep Fusion e cria recursos muito mais impressionantes.

Os recursos de fotografia no Google Pixel 4 — ou seja, Super Res Zoom — podem até oferecer um vislumbre desse futuro. O zoom Super Res do Google combina o zoom óptico e digital no Pixel 4 para oferecer fotos com zoom super nítido.

Se a Apple já está explorando maneiras de fundir imagens para obter mais detalhes, eu poderia imaginar que a empresa poderia procurar maneiras de melhorar ainda mais seus recursos de zoom, especialmente agora que há um iPhone com três câmeras na parte traseira.

Mas isso tudo é conjectura. Por enquanto, não importa se o Deep Fusion te impressiona ou não. Se você tem um iPhone 11 ou um iPhone 11 Pro, você recebe o recurso gratuitamente ao atualizar para o iOS 13.2. Se você tiver um telefone mais antigo, você não deve receber o Deep Fusion.

O recurso certamente evoluirá, e o que veremos no próximo ano provavelmente será mais impressionante do que o que está disponível agora. Dito isto, as câmeras presentes no iPhone 11 e no iPhone 11 Pro são bem impressionantes. Você pode trocar de telefone apenas para ter o sensor ultra-grande angular, que vem nos modelos lançados neste ano. Só posso dizer que estou me divertindo muito com este sensor. Vide esta foto abaixo:

Foto: Adam Clark Estes/Gizmodo

Foto: Adam Clark Estes/Gizmodo