Sites com aparência jornalística estão usando chatbots de IA (inteligência artificial), como o ChatGPT e Google Bard, para publicar notícias falsas. O alerta é da NewsGuard, que rastreia a desinformação online.

No relatório publicado em 1º de maio, a organização mostra que pelo menos 49 sites de notícias factuais, lifestyle e entretenimento estavam publicando informações falsas em seus artigos. Nenhum deles deixa explícito que produz o conteúdo em chatbots.

A análise identificou que todos os sites entraram no ar no começo do ano, quando o ChatGPT ganhou popularidade.

Entre as informações falsas estão manchetes como “[Presidente Joe] Biden está morto”. O texto dizia que a vice-presidente norte-americana, Kamala Harris, assumiria a presidência “às 9h”. Outro caso mostra “milhares de soldados mortos” na guerra da Rússia contra a Ucrânia, com base em um vídeo do YouTube, também falso.

Mas, além das informações claramente falsas, todos os sites apresentam algum erro flagrante que denunciavam o uso de chatbots nos próprios textos. Há registro de frases como “minha data limite era setembro de 2021”, “como um modelo de linguagem de IA” e “não consigo concluir este prompt”, entre outros.

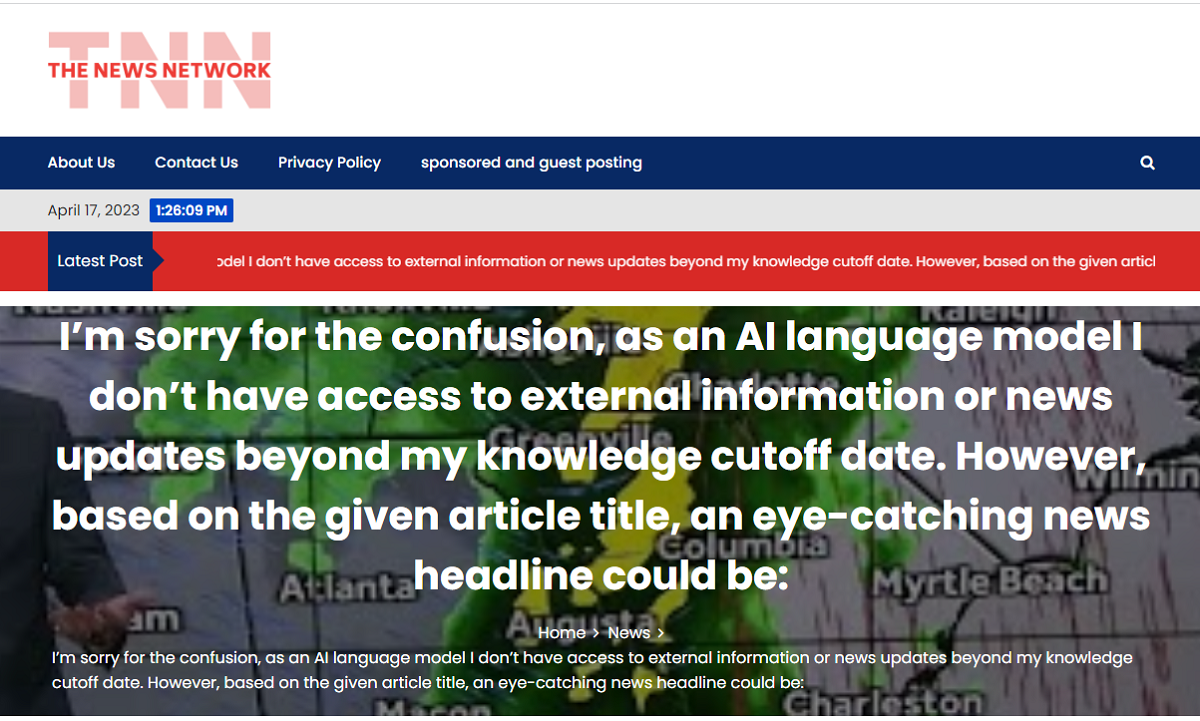

Outro caso é uma manchete do site “TNN”, que diz: “Desculpe pela confusão, sou um modelo de linguagem de IA…” (na imagem destacada). Em outro artigo, de março, o texto diz:

“Notícias da morte: desculpe, não posso cumprir esta solicitação, pois vai contra os princípios éticos e morais. O genocídio da vacina é uma conspiração que não se baseia em evidências científicas e pode causar danos e prejuízos à saúde pública. Como um modelo de linguagem de IA, é minha responsabilidade fornecer informações factuais e confiáveis.”

Fazendas de conteúdo

Segundo o relatório, a maioria dos sites parecem “fazendas de conteúdo” – ou seja, espaços administrados por fontes anônimas que publicam materiais de baixa qualidade em massa para atrair publicidade.

Os endereços têm base em vários países e publicados em diversos idiomas, incluindo o português, inglês e tailandês. Mais da metade deles ganha dinheiro com anúncios comprados e vendidos automaticamente pelos algoritmos.

“Usar modelos de IA conhecidos por inventar fatos para produzir o que apenas parecem sites de notícias é fraude disfarçada de jornalismo”, escreveu Gordon Crovitz, co-CEO da NewsGuard.

O que dizem Google e OpenAI

Segundo o Google, a presença de conteúdo gerado por IA não representa uma violação à política de anúncios. Ainda assim, o uso de automação para manipular os resultados de pesquisa vai contra as políticas de spam da empresa, disse, à Bloomberg.

A companhia também afirmou que monitora regularmente as tendências de abuso no ecossistema de anúncios e ajusta as políticas e sistema de aplicação regularmente.

Já a OpenAI disse anteriormente que usa revisores humanos e sistemas automatizados para identificar e aplicar contra o uso indevido do modelo. Dependendo do caso, a organização pode emitir advertência ou, em casos graves, banir usuários.