Como uma superinteligência artificial pode destruir a humanidade

Estou confiante de que a inteligência de máquina será nossa ruína final. Seu potencial de exterminar a humanidade é algo sobre o qual venho pensando e escrevendo há quase 20 anos. Sou muito criticado por isso, mas a perspectiva da civilização humana se extinguindo por suas próprias ferramentas não deve ser ignorada.

Há uma objeção surpreendentemente comum à ideia de que uma superinteligência artificial pode destruir nossa espécie. Não é que a própria superinteligência seja impossível ou que não seremos capazes de impedir que uma máquina desonesta nos destrua. Essa objeção ingênua propõe, em vez disso, que um computador muito inteligente simplesmente não terá os meios ou a motivação para acabar com a humanidade.

Perda de controle

Imagine sistemas, sejam biológicos ou artificiais, com níveis de inteligência iguais ou muito maiores do que a inteligência humana. Cérebros humanos ou de animais radicalmente aprimorados poderiam ser alcançados por meio da engenharia genética, nanotecnologia, tecnologia da informação e ciência cognitiva, enquanto a inteligência de máquina maior do que a humana provavelmente surgirá por meio de avanços na ciência da computação.

E agora imagine se algo der errado com um desses sistemas, ou se eles forem usados deliberadamente como armas. Infelizmente, provavelmente não seremos capazes de contê-los quando surgirem, nem seremos capazes de prever a forma como eles responderão às nossas solicitações.

“Isso é conhecido como o problema de controle” , explicou por e-mail Susan Schneider, diretora do Center for Future Mind e autora de Artificial You: AI eo Future of the Mind. “É simplesmente o problema de como controlar uma IA que é muito mais inteligente do que nós.”

Para fazer analogias, Schneider apontou para um suposto cenário no qual um fabricante de clipes de papel de posse de uma inteligência artificial mal programada se propõe a maximizar a eficiência da produção de clipes. Por sua vez, ele destrói o planeta ao converter toda a matéria na Terra em clipes de papel, uma categoria de risco apelidada de “instanciação perversa” pelo filósofo de Oxford Nick Bostrom em seu livro de 2014 Superinteligência: caminhos, perigos, estratégias. A preocupação geral, aqui, é que diremos a uma superinteligência para fazer algo e, como não acertamos os detalhes, ela interpretará mal nossos desejos, resultando em algo que não pretendíamos.

Por exemplo, poderíamos fazer a solicitação de um meio eficiente de extração de energia solar, levando uma superinteligência a usurpar os recursos de todo o nosso planeta para a construção de um enorme painel solar. Pedir a uma superinteligência para “maximizar a felicidade humana” poderia obrigá-la a religar os centros de prazer de nossos cérebros ou carregá-los em um supercomputador, forçando-nos a experimentar perpetuamente um ciclo de felicidade de cinco segundos pela eternidade, como especula Bostrom.

Eliezer Yudkowsky, um teórico de IA do Machine Institute for Artificial Intelligence, pensa na superinteligência artificial como processos de otimização, ou um “sistema que atinge pequenos alvos em grandes espaços de busca para produzir efeitos coerentes do mundo real”, como ele escreve em seu ensaio “Inteligência artificial como fator positivo e negativo no risco global.” O problema é que esses processos tendem a explorar um amplo espaço de possibilidades, muitas das quais não poderíamos imaginar. Como escreveu Yudkowski:

Estou visitando uma cidade distante e um amigo local se oferece para me levar de carro ao aeroporto. Quando meu amigo chega a um cruzamento de rua, não consigo prever suas curvas. Mesmo assim, posso prever o resultado de suas ações: chegaremos ao aeroporto. Não é uma situação estranha, cientificamente falando? Posso prever o resultado de um processo, sem ser capaz de prever nenhuma das etapas intermediárias.

Impulsionada por sua programação baseada em objetivos, uma máquina pode causar danos colaterais consideráveis ao tentar ir de A para B. Assim, uma IA também pode usar e abusar de um poderoso recurso pré-existente – humanos – ao tentar para atingir seu objetivo, e de maneiras que não podemos prever.

Tornando a IA amigável

Uma IA programada com um conjunto predeterminado de considerações morais pode evitar certas armadilhas, mas como Yudkowski aponta, será quase impossível para nós prever todos os caminhos possíveis que uma inteligência poderia seguir.

Uma possível solução para o problema do controle é imbuir uma superinteligência artificial com códigos morais compatíveis com os humanos. Se pudéssemos fazer isso, uma máquina poderosa se absteria de causar danos ou de fazer seus negócios de uma forma que viole nossas sensibilidades morais e éticas, de acordo com essa linha de pensamento. O problema, como Schneider apontou, é que para que “possamos programar em um código moral, precisamos de uma boa teoria moral, mas há muitas divergências quanto a isso no campo da ética”, disse ela.

Bom ponto. A humanidade nunca produziu um código moral comum com o qual todos possam concordar. E como qualquer pessoa com uma compreensão ainda rudimentar do problema do bonde pode lhe dizer, a ética pode se complicar muito rapidamente. Essa ideia – de que podemos tornar a superinteligência segura ou controlável ensinando-lhe a moralidade humana – provavelmente não vai funcionar.

Formas e meios

“Se pudéssemos prever o que uma superinteligência fará, também seríamos muito inteligentes”, explicou Roman Yampolskiy, professor de ciência da computação e engenharia da Universidade de Louisville. “Por definição, a superinteligência é mais inteligente do que qualquer ser humano e, portanto, surgirá com alguma solução desconhecida e desconhecida para atingir” os objetivos que atribuímos a ela, seja projetar um novo medicamento para a malária, conceber estratégias no campo de batalha ou administrar um rede de energia local. Dito isso, Yampolskiy acredita que podemos prever as ações malignas de uma superinteligência olhando para exemplos do que um ser humano inteligente pode fazer para dominar o mundo ou destruir a humanidade.

Assustadoramente, uma superinteligência poderia chegar a certos julgamentos sobre como agir fora de nossas solicitações, como explicou Manuel Alfonseca, um cientista da computação da Universidad Autónoma de Madrid, na Espanha. Além disso, poderia “chegar à conclusão de que o mundo seria melhor sem seres humanos e nos destruir”, disse ele.

Para uma superinteligência artificial empenhada na destruição deliberada da humanidade, a exploração de nossas fraquezas biológicas representa seu caminho mais simples para o sucesso. Os humanos podem sobreviver por cerca de 30 dias sem comida e cerca de três a quatro dias sem água, mas duramos apenas alguns minutos sem oxigênio. Uma máquina provavelmente encontraria uma maneira de aniquilar o oxigênio de nossa atmosfera, por exemplo. Infelizmente, os futuristas têm um termo para uma estratégia como esta: ecofagia global , ou o temido “gosma cinza.” Em tal cenário, frotas de máquinas moleculares deliberadamente projetadas buscariam recursos específicos e os transformariam em outra coisa, incluindo cópias de si mesmas.

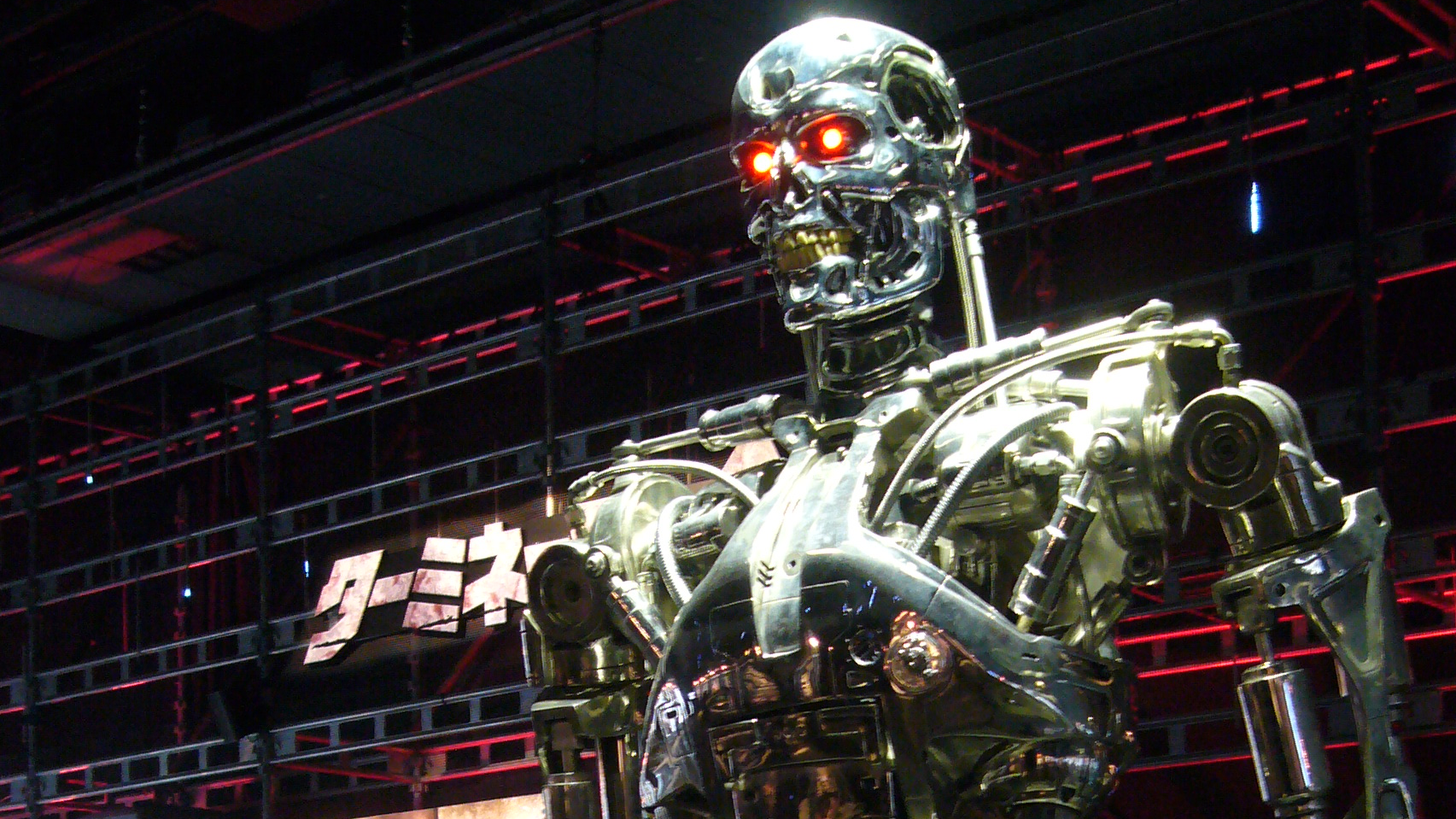

Ficção científica

Tudo isso soa muito sci-fi, mas Alfonseca disse que a ficção especulativa pode ser útil para destacar riscos potenciais, referindo-se especificamente a Matrix . Schneider também acredita no poder das narrativas ficcionais, apontando para o curta distópico Slaughterbots, em que drones autônomos armados invadem uma sala de aula. As preocupações com a IA perigosa e o surgimento de máquinas assassinas autônomas são cada vez mais sobre o “aqui e agora”, disse Schneider, em que, por exemplo, as tecnologias de drones podem se basear em softwares de reconhecimento facial existentes para atingir pessoas. “Esta é uma grande preocupação”, afirmou a pesquisadora.

O pesquisador de aprendizado de máquina do MIT, Max Tegmark, conta que entretenimento como The Terminator, embora apresente cenários vagamente possíveis, “distrai dos riscos e oportunidades reais apresentados pela IA”, como ele escreveu em seu livro Life 3.0: Being Human in the Age of Artificial Intelligence de 2017 . Temark imagina cenários mais sutis, nos quais uma inteligência de máquina domina o mundo por meio de engenhosa engenharia social. Em seu livro, Tegmark descreve “Prometeu”, uma hipotética inteligência artificial geral (AGI) que usa sua inteligência adaptativa e versatilidade para “controlar humanos de várias maneiras”.

Uma inteligência geral artificial poderia ser usada para inventar a superinteligência. Dessa forma, testemunharíamos uma “explosão de inteligência”, dando alguns resultados seriamente indesejáveis. “Se um grupo de humanos conseguir controlar uma explosão de inteligência, eles poderão dominar o mundo em questão de anos”, escreve Temark. “Mas se falharem, a própria IA pode dominar o mundo ainda mais rápido.”

Outra vulnerabilidade fundamental tem a ver com a maneira como os humanos estão cada vez mais sendo excluídos do ciclo tecnológico. Notoriamente, os algoritmos agora são responsáveis pela maior parte do volume de negociação de ações e até capazes de derrotar pilotos de F-16 humanos em combates aéreos. Cada vez mais, as IAs estão sendo solicitadas a tomar grandes decisões sem intervenção humana.

Schneider se preocupa que “já existe uma corrida armamentista de IA nas forças armadas” e que “a crescente dependência da IA tornará as habilidades perceptivas e cognitivas humanas incapazes de responder aos desafios militares de maneira suficientemente rápida”. Vamos exigir que a IA faça isso por nós, mas não está claro como podemos continuar a manter os humanos informados, disse ela. É concebível que as IAs tenham que responder em nosso nome ao enfrentar ataques militares – antes de termos a chance de sintetizar os dados recebidos, explicou Schenider.

Os humanos são propensos a cometer erros, especialmente quando sob pressão no campo de batalha, mas os erros de cálculo ou de julgamento feitos por uma IA introduziriam uma camada adicional de risco. O autor de ficção científica Isaac Asimov previu isso, pois os robôs em seus romances – apesar de serem limitados pelas Três Leis da Robótica – enfrentaram todos os tipos de problemas, apesar de nossos melhores esforços. Problemas semelhantes poderiam surgir se tentássemos fazer algo parecido, embora, como Schneider apontou, seja difícil chegar a um acordo sobre um código moral para guiar nossos irmãos eletrônicos.

No entanto, temos pouca escolha a não ser tentar. Encolher os ombros em derrota não é realmente uma opção, dado o que é uma aposta. Como Bostrom argumenta, nossa “sabedoria deve preceder nossa tecnologia”, daí sua frase, “filosofia com um prazo”. O que está em jogo é uma série de desastres potenciais em todo o planeta, mesmo antes do início da superinteligência artificial.

Infelizmente, não faltam maneiras para a superinteligência artificial acabar com a civilização humana como a conhecemos. É então possível criar IA segura, benéfica e baseada na ética? A única opção pode ser uma proibição em escala global do desenvolvimento de IA superinteligente, o que é improvável, mas provavelmente necessário.