O Facebook acredita que vamos viver um futuro rodeado por realidade aumentada

Embora grande parte do evento Connect do Facebook, na última quarta-feira (16), tenha se concentrado em tecnologias que você pode usar agora mesmo, como é o caso do Oculus Quest 2, o cientista-chefe da Oculus, Michael Abrash, também deu uma prévia poderosa do que a companhia de Mark Zuckerberg está fazendo para criar nosso futuro. E, aparentemente, estaremos cercados por realidade aumentada (RA).

A tecnologia oferece uma grande variedade de recursos e ferramentas que ainda não são suportadas nos smartphones ou computadores tradicionais. Por conta disso, um dos maiores obstáculos é criar uma estrutura que possa incorporar várias camadas de informações e traduzi-las em uma interface que seja compreensível e funcione sem gargalos.

Para explicar como o Facebook está tentando superar esses problemas, Abrash dividiu a pesquisa sobre interfaces de RA de próxima geração em três categorias principais: entrada e saída, percepção da máquina e interação.

Quando se trata de entrada e saída, Abrash referiu a necessidade da tecnologia ter um “momento Engelbart”, que é uma referência à lendária apresentação de 1968 na qual Douglas Engelbart demonstrou uma série de tecnologias fundamentais, incluindo um protótipo de mouse de computador. O uso de um mouse e ponteiro para manipular uma interface gráfica de usuário se tornou um princípio orientador para computadores modernos, e que mais tarde foi expandido na entrada baseada em toque usada nas telas touchscreen que hoje estão em milhões de dispositivos.

https://www.youtube.com/watch?v=aqripcSmv_I&feature=emb_title

Como não é possível usar um mouse ou teclado tradicional em conteúdos de realidade aumentada (bom, você até pode, mas não deve ser uma experiência confortável), o Facebook está tentando criar métodos de entrada totalmente novos. E a empresa tem duas soluções potenciais em andamento: eletromiografia (ou EMG) e áudio direcionado (beamforming).

Usando um pequeno dispositivo EMG para capturar sinais enviados do cérebro, o Facebook espera criar métodos de entrada aprimorados para funcionar em RA e RV. Captura de tela: Facebook

A EMG é uma técnica que funciona da seguinte maneira: ao colocar sensores no pulso, um pequeno dispositivo pode interceptar sinais elétricos que seu cérebro envia para suas mãos, criando efetivamente um novo tipo de entrada neural direta, mas não invasiva. Como os sinais captados por EMG são relativamente fortes e direcionados, os sensores EMG podem detectar movimentos de apenas um milímetro ou, em alguns casos, entradas que derivam apenas do pensamento.

Isso soa como uma interface de cérebro de computador que a gente vê apenas em filmes de ficção científica. Mas o resultado final é que, usando EMG, as pessoas seriam capazes de manipular objetos de RA no espaço 3D ou escrever texto de uma maneira que não seria possível replicar usando um teclado e mouse.

Abrash diz que o uso de EMG pode ser capaz de dar às pessoas recursos que não têm na vida real, como um sexto dedo ou controle sobre cinco dedos por uma pessoa que nasceu com a função de mão limitada. Isso foi demonstrado durante o evento transmitido pelo Facebook na última quarta-feira (16).

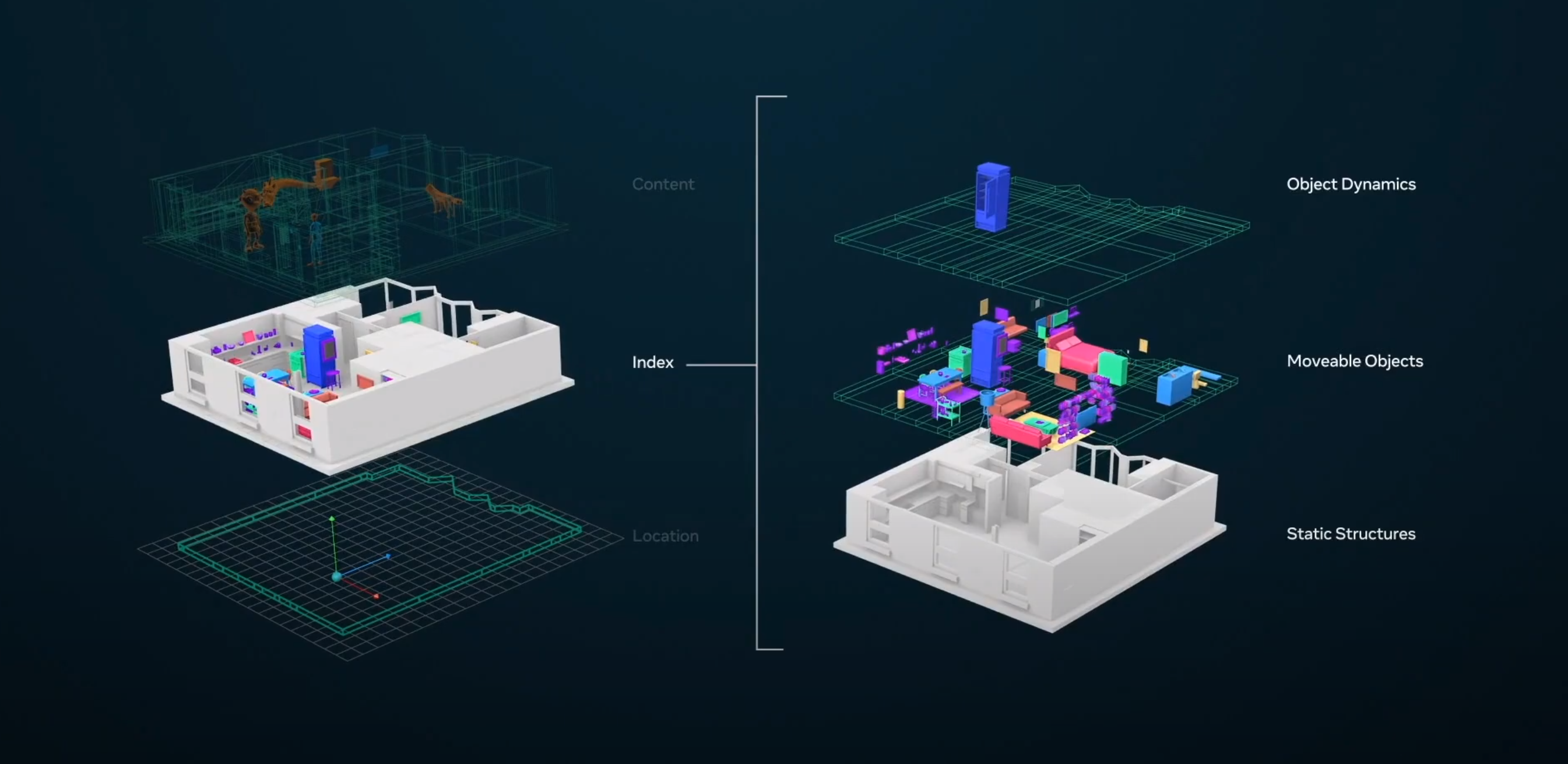

O Facebook está tentando criar um sistema de mapeamento mais aprofundado que combina coordenadas físicas e objetos próximos, e sua relação com o ambiente ao redor. Captura de tela: Facebook

Para tornar a comunicação mais clara e fácil de entender, o Facebook também tem feito estudos usando o áudio beamforming para ajudar a eliminar o ruído de fundo, destacar alto-falantes e conectar pessoas que estão falando online e pessoalmente. E isso de um jeito mais preciso que as técnicas de cancelamento de ruído padrão que, aos poucos, tem se popularizado nos dispositivos móveis e vestíveis.

Passando para a percepção de máquina, Abrash diz que precisamos ir além da visão computacional básica para, então, dar suporte a um mapeamento contextual que pode preencher a lacuna entre os objetos em realidade virtual ou realidade aumentada, e como eles aparecem no mundo real.

Por quê isso é importante? Bem, digamos que você esteja tentando falar com alguém em RA. E que, durante essa conversa, seu avatar ficar entrando e saindo de uma parede próxima ou aparece no meio de uma mesa em vez de sentar em uma cadeira próxima. O mesmo vale para objetos em RA, como uma árvore gerada por computador ou arte virtual, que ficaria no parapeito de uma janela ou em uma parede física em vez de flutuar no ar, bloqueando sua visão sempre que você passar.

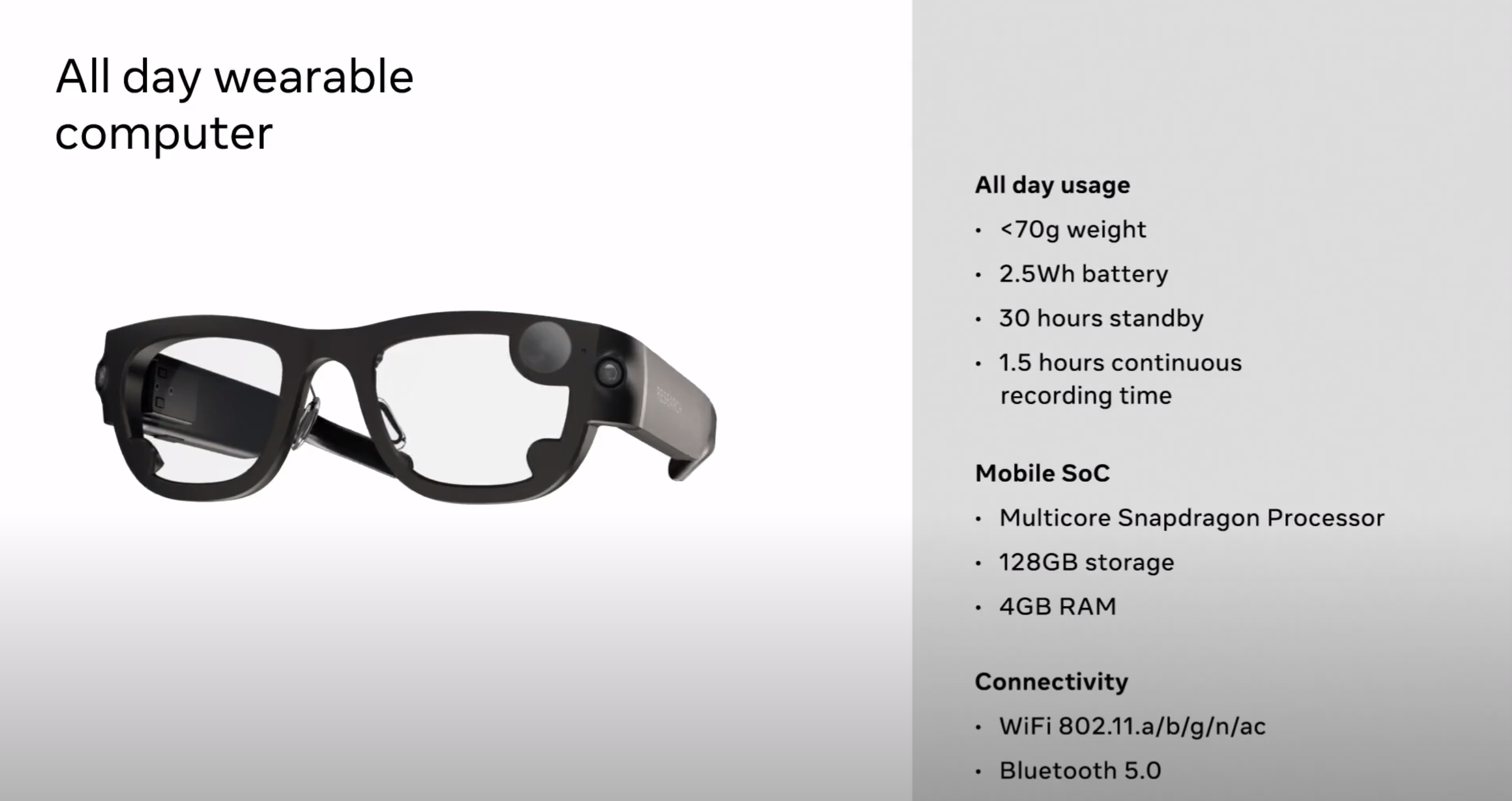

Estas são algumas especificações básicas sobre os óculos de pesquisa do Project Aria. Captura de tela: Facebook

Estas são algumas especificações básicas sobre os óculos de pesquisa do Project Aria. Captura de tela: Facebook

Para superar esses desafios, o Facebook está trabalhando em um sistema de coordenadas que pode rastrear localizações físicas, indexar seus arredores e até mesmo reconhecer os tipos de objetos no ambiente, o que eles fazem e como se relacionam com você. Infelizmente, não há uma maneira fácil de reunir todas essas informações em um só lugar. Então, para criar esses modelos virtuais de várias camadas (ou Live Maps, como Abrash os chama), o Facebook está lançando o Projeto Aria.

Desenvolvido estritamente como uma ferramenta de pesquisa usada para reunir informações de mapeamento, o Projeto Aria é essencialmente uma versão mais compacta do conjunto de sensores que o Google Maps utiliza para mapear as cidades – aquele equipamento que vai em cima de um carro ou na mochila de uma pessoa. Exceto que, com o Aria, todos os sensores ficam em um headset, que por sua vez está emparelhado a um smartphone. Isso torna o Project Aria em um aparelho portátil, permitindo que as pessoas construam mapas ao vivo de seus ambientes, sem ter de carregar um trambolho nas costas.

O Projeto Aria não apenas tornará o desafio de coletar os dados usados para criar mapas ao vivo mais fácil, mas também permitirá que os pesquisadores determinem quais tipos de dados são mais importantes, enquanto um filtro de privacidade especial projetado pelo Facebook evita que Aria salve dados potencialmente confidenciais.

O Facebook não tem planos de lançar ou vender o Aria ao público consumidor. Os testes com o projeto no mundo real começam ainda neste mês.

Captura de tela: Facebook

Captura de tela: Facebook

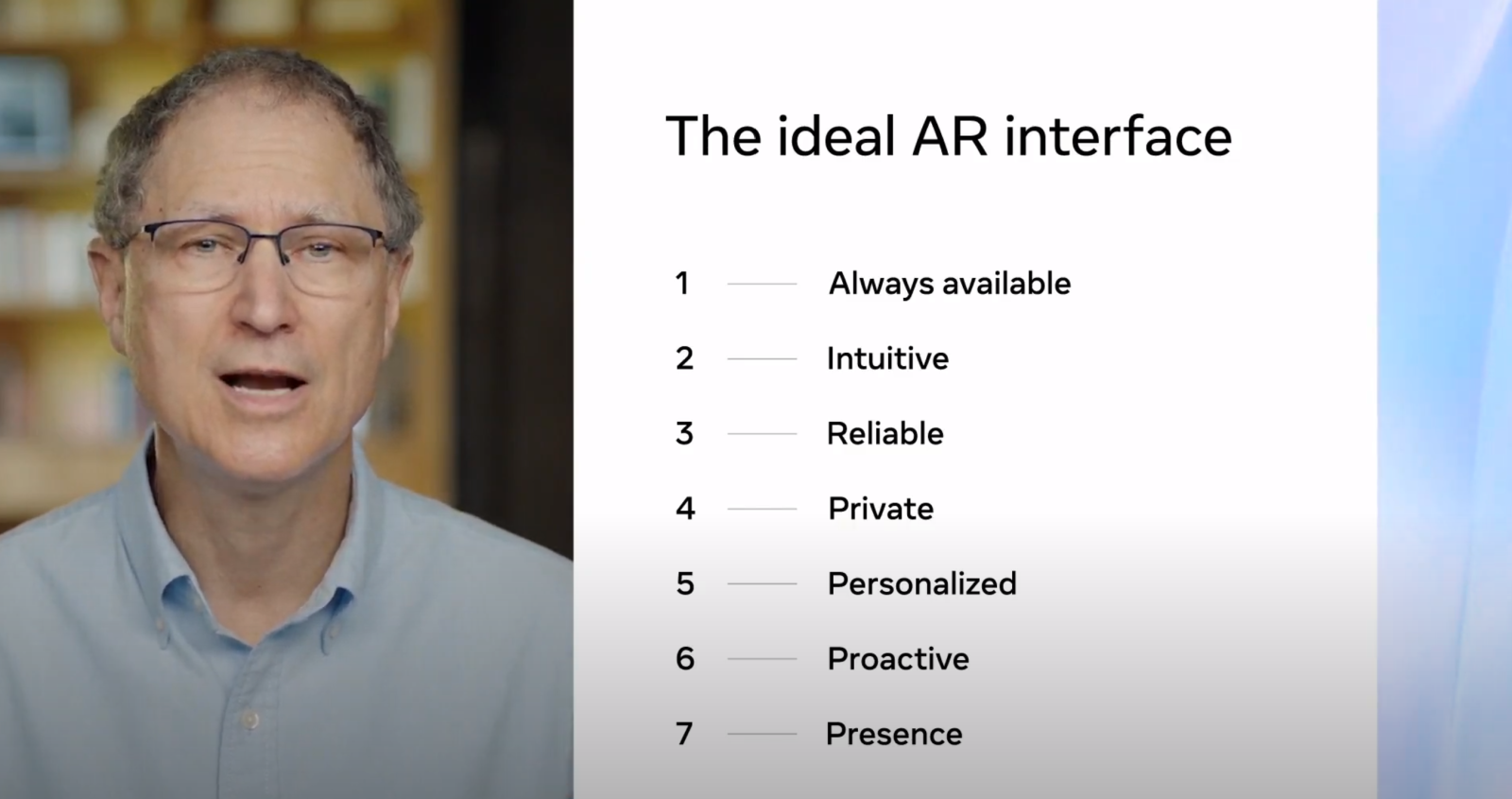

Finalmente, quando se trata de interação abrangente de realidade aumentada, o Facebook está trabalhando para combinar “interações focadas em alta largura de banda”, como chamadas de vídeo ou bate-papos em realidade virtual, com um novo tipo de interface visual sempre disponível, que por enquanto foi apelidada de interface de inteligência artificial ultrabaixa e contextualizada por fricção (ULFCAII, na sigla em inglês).

Esta é a parte mais avançada da pesquisa de realidade aumentada do Facebook. Contudo, Abrash diz que a ULFCAII será a mais simples e intuitiva possível, ao mesmo tempo que requer menos conectividade ou, em alguns casos, nenhuma conectividade. A inteligência artificial será capaz de saber o que você está tentando fazer sem que você precise perguntar.

Na prática, isso significaria um display de realidade aumentada que automaticamente abre uma janela mostrando como estará o tempo antes de você sair de casa. Ou ainda, sabendo quando não silenciar as chamadas recebidas com base no que você está fazendo no momento. Também será possível obter, de dentro de casa, um trajeto com todas as informações necessárias para uma viagem de carro. Ou até instruções de como montar um móvel sozinho.

No futuro, as interfaces em realidade aumentada serão capazes de informar onde estão determinados produtos dentro de um supermercado, sem que você pergunte isso para um funcionário. Captura de tela: Facebook

No futuro, as interfaces em realidade aumentada serão capazes de informar onde estão determinados produtos dentro de um supermercado, sem que você pergunte isso para um funcionário. Captura de tela: Facebook

Tudo isso parece fantástico e futurístico, e Abrash enfatizou que as pessoas já estão preparando as bases para essas interfaces de computador mais avançadas. E mesmo com apenas alguns vislumbres dessas primeiras demonstrações, os dispositivos de realidade aumentada de próxima geração podem não estar tão distantes quanto parecem.

Você pode assistir a apresentação completa de Abrash clicando aqui (em inglês), e deslize para 1:19:15. Ou faça isso usando o player de vídeo no início deste artigo.