Meta desenvolve IA com “dados sensoriais”; entenda este novo passo

A Meta anunciou na terça-feira (9) o ImageBind, um novo modelo de IA (inteligência artificial) de código aberto capaz de gerar fluxos de dados em texto, áudio, imagens, unidades de medição térmica e de movimento.

Por enquanto, o modelo da gigante tech não passa de um projeto de pesquisa sem aplicação prática, mas há potencial de que, no futuro, sistemas de IA generativa possam criar experiências mais imersivas e multissensoriais.

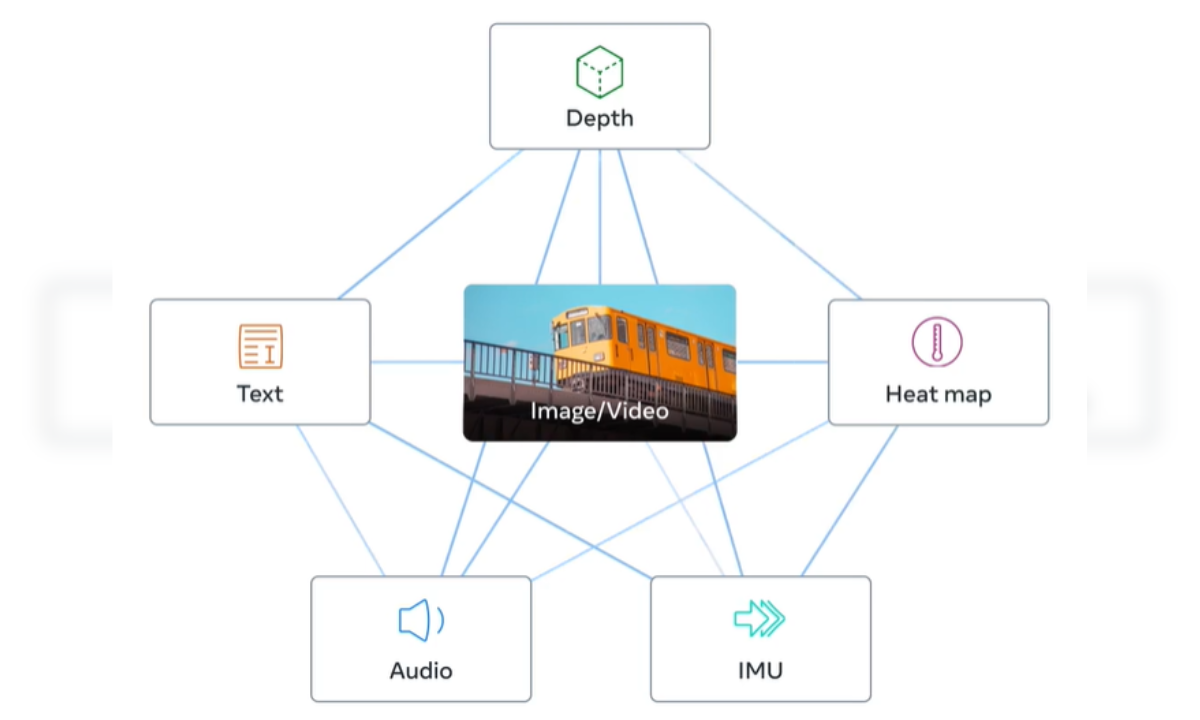

Segundo a Meta, o ImageBind é o primeiro a combinar cinco tipos de dados em um único espaço de incorporação. São eles:

- Dados textuais: gera textos assim como o Bing IA e ChatGPT

- Dados de áudio: áudios gerados automaticamente, a partir de comandos de texto ou associação por imagens

- Dados visuais: gera imagens estáticas e em vídeo, por associação com áudios e texto

- Dados térmicos e de movimento: sistema faz leitura de imagens infravermelhas e analisa ambiente em IMU (unidade de medição inercial)

- Dados de profundidade: análise de ambientes e objetos em 3D

A ideia é que, no futuro, sistemas de IA consigam fazer referência cruzada a todos esses dados da mesma forma que plataformas atuais, como o ChatGPT, fazem com as entradas de texto.

Um exemplo de aplicação é pedir para que o sistema simule uma viagem marítima. Nesse sentido, a IA não mostraria apenas o navio ou o barulho ambiente, mas também o balanço das ondas e a temperatura do ar sobre o oceano.

Parece uma utopia futurista, mas o conceito central da pesquisa já existe nas plataformas mais populares de IA generativa. Geradores de imagem como DALL-E, Midjourney e Stable Diffusion dependem de sistemas que vinculam texto e imagens desde o treinamento.

Como isso é possível?

De modo geral, essas IAs procuram padrões em dados visuais e conectam informações às descrições das imagens. Assim, permitem que a tecnologia crie imagens que obedecem aos comandos dos usuários. O mesmo vale para outras plataformas.

Segundo a Meta, o fluxo de entrada sensorial pode entrar nos modelos futuros, incluindo “toque, fala, cheiro e sinais cerebrais de ressonância magnética (fMRI)”.

“[A pesquisa] traz as máquinas um passo mais perto da capacidade dos humanos de aprender simultaneamente, de forma holística e diretamente de muitas formas diferentes de informação” – Meta

Apesar do conceito já existir nos sistemas atuais, a proposta da Meta soa bastante especulativa e é improvável que a aplicação da pesquisa aconteça tão rápido. Mas também não é algo impossível.

Pesquisadores da Universidade da Cidade de Hong Kong, por exemplo, acabam de desenvolver uma interface que reproduz cheiros na realidade virtual. O wearable é flexível e sem fio e consegue reproduzir com precisão cheiros como lavanda, abacaxi e chá verde, como mostra artigo publicado na terça-feira (9).

Seria um passo para tentar recuperar a relevância do metaverso? Difícil dizer, mas analistas elogiaram a postura da Meta em abrir o código do projeto, visto que os concorrentes OpenAI e Google tornam seus modelos de IA cada vez mais sigilosos.