Usuários acusam Twitter de racismo após algoritmo de fotos priorizar brancos a negros

A rede neural usada pelo Twitter para gerar prévias das fotos postadas no site é algo guardado a sete chaves pela companhia. Eu mesma já vi muitos experimentos informais para tentar descobrir esse segredo. E um deles tomou forma na rede social durante este fim de semana, expondo um problema grave e bastante real: a ferramenta de corte automático de imagens parece favorecer rostos brancos em vez de pretos, criando um ambiente desigual e racista.

Quando o Twitter estreou a ferramenta de corte inteligente em 2018, a empresa disse que o algoritmo determina a parte mais “saliente” da imagem – ou seja, para onde seus olhos são atraídos primeiro – para então usar esse corte como uma prévia da fotografia. Mesmo assim, a rede social nunca explicou exatamente o que quer dizer com “saliente”. Daí começaram as especulações, e rostos parecem ser o item prioritário do algoritmo. Mas quais tipos de rostos, especificamente? Sorrindo ou com a cara séria? Iluminados ou no escuro?

Foi quando, neste final de semana, vários usuários do Twitter apontaram o quão problemático é o funcionamento desse algoritmo de corte.

Para isso, fizeram o seguinte teste: uma imagem contendo o rosto de uma pessoa branca e uma segunda foto com o rosto de uma pessoa negra, ambas na mesma postagem. E, de fato, o algoritmo salientou a parte da imagem contendo rostos. No entanto, em todos os tweets, a prévia da publicação priorizou os rostos brancos, mesmo usando diferentes variáveis – por exemplo, o rosto branco em uma proporção menor ao rosto negro ou cores de fundo destacando o rosto negro.

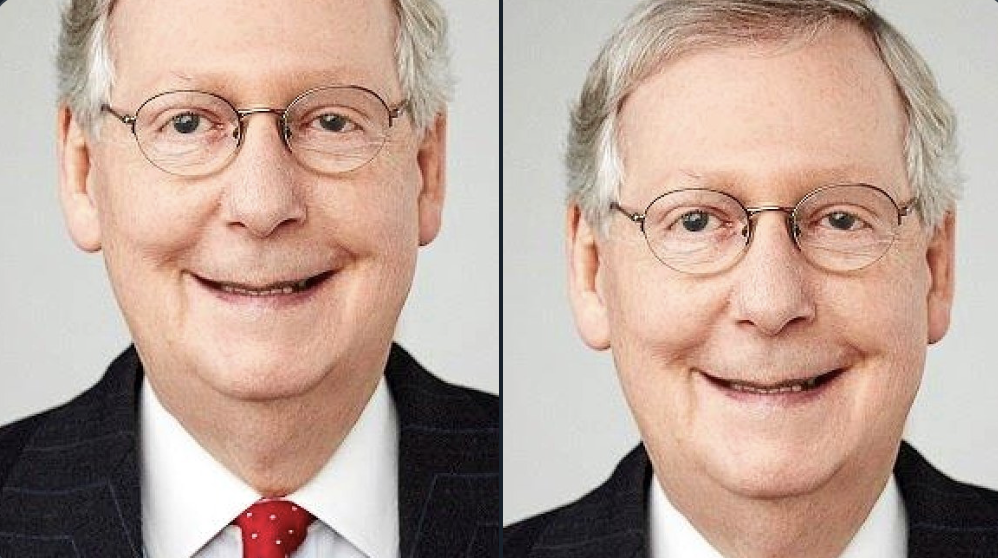

Um dos posts mais populares utilizou uma foto do ex-presidente dos Estados Unidos, Barack Obama e do senador estadunidense Mitch McConnell. Na primeira montagem, a fotografia do senador branco está em cima, e a de Obama, embaixo. Na segunda montagem, o inverso: Obama aparece em cima, e o senador, embaixo. Nas duas pré-visualizações, o algoritmo do Twitter escolheu a foto de McConnell para servir de destaque no post.

Você pode pode visualizar o tweet clicando nas imagens abaixo.

Trying a horrible experiment…

Which will the Twitter algorithm pick: Mitch McConnell or Barack Obama? pic.twitter.com/bR1GRyCkia

— Tony "Abolish ICE" Arcieri 🦀🌹 (@bascule) September 19, 2020

Poucas horas depois, o experimento ganhou mais e mais exemplos.

https://twitter.com/sina_rawayama/status/1307506452786016257

— -M (@Ma_lopess2) September 20, 2020

Vejamos… pic.twitter.com/uf0He4pZbc

— jéssica batan (@jessicabatan) September 20, 2020

Este é surreal. São 11 imagens com um rosto negro, e apenas uma com um rosto branco. Adivinha qual delas o algoritmo do Twitter priorizou?

não é possível que..

é possível sim pic.twitter.com/NHjF8BKjSP— perezeu ☻ (@irodolfoperes) September 20, 2020

Como começou

A tendência ganhou forma depois que um usuário tentou tuitar sobre um problema com o algoritmo de detecção de rosto do Zoom na última sexta-feira (18). Os sistemas de Zoom não estavam detectando a cabeça de seu colega negro, e quando ele carregou capturas de tela do problema no Twitter, ele descobriu que a ferramenta de recorte automático do Twitter também estava voltada para seu rosto, e não para seu colega de trabalho, nas imagens de visualização.

any guesses? pic.twitter.com/9aIZY4rSCX

— Colin Madland 🇺🇦 (@colinmadland) September 19, 2020

Aparentemente, esse problema também era novidade para o Twitter. Em resposta ao tópico do Zoom, o diretor de design da rede social, Dantley Davis, conduziu alguns experimentos informais por conta própria. Ele disse estar “tão irritado com isso quanto todo mundo”. Parag Agrawal, diretor de tecnologia do Twitter, também abordou o problema por meio de um tuíte, acrescentando que, embora o algoritmo do Twitter fosse testado, ele ainda precisava de “melhoria contínua”, e que estava “ansioso para aprender” com os testes rigorosos dos usuários.

“Nossa equipe fez testes de viés antes de lançarmos o algoritmo e não foram encontradas evidências de preconceito racial ou de gênero. Mas está claro a partir desses exemplos que temos mais análises a fazer. Vamos abrir o código do nosso trabalho para que outros possam revisar e replicar”, disse a porta-voz do Twitter, Liz Kelley, ao Gizmodo. A executiva não comentou sobre um cronograma para revisar o algoritmo.

Vinay Prabhu, cientista-chefe da Universidade Carnegie Mellon, nos EUA, também conduziu uma análise independente das tendências de corte automático do Twitter e tuitou suas descobertas neste domingo (20). Você pode ler mais sobre sua metodologia neste link, mas resumindo: ele testou a teoria tuitando uma série de fotos do Chicago Faces Database, um repositório público de imagens padronizadas de rostos masculinos e femininos, que foram controlados por vários fatores, incluindo posição do rosto, iluminação e expressão facial.

Surpreendentemente, o experimento mostrou que o algoritmo do Twitter favorecia ligeiramente a pele mais escura, e não a clara, em suas visualizações – de 92 imagens publicadas, 52 delas (ou seja, mais da metade) salientaram rostos de pessoas negras. Claro que, dado o grande volume de evidências informais que contrariam os testes de Prabhu, é óbvio que o Twitter precisa fazer ajustes em sua ferramenta de corte automático. No entanto, as descobertas de Prabhu devem ser úteis para ajudar a equipe da rede social a isolar o caso.

O problema é mais embaixo

Deve-se observar que, quando se trata de aprendizado de máquina e inteligência artificial, os algoritmos preditivos não precisam ser explicitamente projetados para serem racistas. A tecnologia de reconhecimento facial, por exemplo, tem uma história longa e frustrante de preconceito racial, e softwares comerciais dessa tecnologia se provaram menos precisos em pessoas com pele mais escura.

Que fique claro que isso não acontece por um acaso. Intencionalmente ou não, a tecnologia reflete os preconceitos de quem a constrói. Tanto que os especialistas têm um termo específico para o fenômeno: viés de algoritmo (viés algorítmico), ou discriminação algorítmica.

E é exatamente por isso que ele precisa passar por mais e mais testes antes que as instituições que lidam com questões de direitos civis diariamente o incorporem a seus serviços. Inúmeras evidências mostram que esse viés discrimina desproporcionalmente pessoas de cor.

Imagine o quão danoso esse sistema acaba sendo fora da internet. Um policial que depende de uma inteligência artificial para rastrear um suspeito, por exemplo, poderia ser influenciado a procurar por alguém de pele mais escura mesmo sem maiores evidências. Ou em um hospital, em que médicos utilizem um sistema automatizado para fazer a triagem de pacientes, o viés de algoritmo poderia resultar em uma decisão de vida ou morte.

O recorte automático tendencioso do Twitter é apenas uma das questões que envolvem o assunto – e que a plataforma deve tratar o mais rápido possível.

[Atualização em 21/09 – 13:40] Em seu perfil oficial, o Twitter Brasil replicou a resposta da conta de comunicação da rede social. A companhia diz ter feito testes antes de lançar o modelo de algoritmo e não encontrou evidências de preconceito racial ou de gênero. “Está claro que temos mais análises a fazer. Continuaremos compartilhando nossos aprendizados e medidas, e abriremos o código para que outros possam revisá-lo”, completou.

Fizemos uma série de testes antes de lançar o modelo e não encontramos evidências de preconceito racial ou de gênero. Está claro que temos mais análises a fazer. Continuaremos compartilhando nossos aprendizados e medidas, e abriremos o código para que outros possam revisá-lo. https://t.co/yZphB9pK5p

— Brasil (@XBR) September 21, 2020

(Colaborou Caio Carvalho)