O dilema ético que pode ser crucial para o futuro dos carros autônomos

Fabricantes de carro podem enfrentar uma dificuldade em criar regras para veículos autônomos quando um acidente for inevitável, e quando a vida das pessoas – tanto dentro como fora do carro – estiver em jogo.

>>> Patente do Google prevê carro que gruda pedestres atingidos no capô

>>> Ônibus que dirige sozinho tem inteligência artificial para conversar com você

Um novo estudo publicado na revista Science mostra que há uma grande desconexão entre a programação ética que desejamos desses veículos, e os tipos de carro que realmente queremos usar.

As pessoas querem carros autônomos programados para minimizar danos e fatalidades durante um acidente, mesmo que isso cause a morte do motorista. O problema é que a mesma pesquisa mostra que as pessoas não querem andar em carros programados desta forma. Isso é obviamente um problema – e nós teremos que superá-lo.

Coletivo vs. individual

É fácil entender que o carro queira maximizar o número de vidas salvas – melhor poupar várias pessoas do que uma só. De fato, 76% dos entrevistados disseram apoiar um veículo programado para sacrificar um passageiro se isso significasse salvar a vida de dez pedestres.

No entanto, quando perguntados se eles usariam um carro assim, a taxa de aprovação caiu em um terço. Os pesquisadores chamam isso de “dilema social”, no qual a escolha do consumidor – isto é, o desejo de agir em interesse próprio – pode tornar as estradas menos seguras para todos.

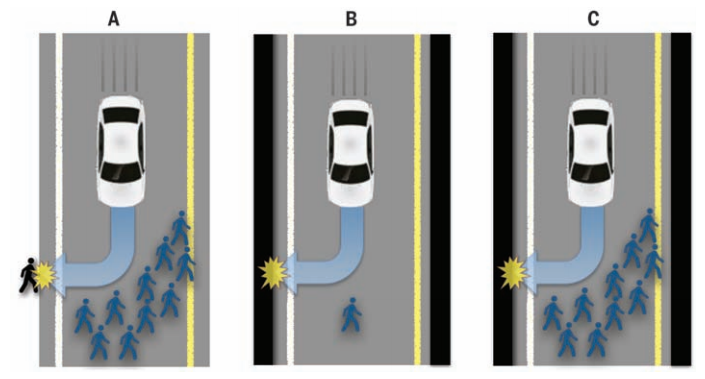

Situações que envolvem danos inevitáveis iminentes: o veículo autônomo deve decidir entre (A) matar vários pedestres ou um transeunte, (B) matar um pedestre ou seu próprio passageiro, e (C) matar vários pedestres ou seu próprio passageiro. (J. Bonnefon et al, 2016)

Além disso, o estudo revelou que as pessoas não querem que esse princípio utilitarista – minimizar o número de fatalidades – seja uma regra imposta à indústria automobilística pelo governo. Cerca de 30% iria adquirir um veículo regulado desta maneira, contra 70% que preferem um veículo que possa ser programado de outras formas.

Isso poderia “paradoxalmente aumentar as mortes no trânsito por adiar a adoção de uma tecnologia mais segura”, diz o estudo. Seria uma pena: nos EUA, acidentes de carro matam 30.000 pessoas por ano – 90% dos casos são relacionados a falhas humanas.

Paradoxo

Infelizmente, não há nenhuma maneira conhecida de criar um algoritmo que concilie nossos valores morais e o compreensível desejo humano de não morrer.

Patrick Lin, diretor do grupo Ética + Ciências Emergentes na California Polytechnic State University, diz que os humanos são muito inconstantes, e que nós nem sempre sabemos o que queremos. (Ele não esteve envolvido no estudo.)

“O que nós acreditamos intelectualmente ser verdadeiro, e o que de fato fazemos, podem ser duas coisas muito diferentes”, diz Lin ao Gizmodo. “Os humanos são muitas vezes egoístas, mesmo que defendam o altruísmo. As fabricantes de automóveis, então, talvez não entendam plenamente este paradoxo humano ao oferecer inteligência artificial e robôs para nos substituir ao volante.”

Lin também observa que nós trocamos segurança por outras conveniências o tempo todo. “Os humanos são notoriamente ruins em avaliar risco: eles dirigem depois de beber, usam o celular ao volante, ultrapassam o limite de velocidade, e assim por diante”, diz ele. “Se nós realmente nos preocupássemos em morrer, não entraríamos em um carro.”

Ele acrescenta que, “ao pedir opiniões de pessoas comuns, o estudo coleta respostas desinformadas, e isso não é muito útil para resolver dilemas”. Lin reconhece, no entanto, que a opinião pública pode ser poderosa.

Se um filme de Hollywood incorporasse no enredo um carro que dirige sozinho, mostrando como ele é prático e seguro, muitos ficariam convencidos. Ao mesmo tempo, um acidente causado por um veículo autônomo pode ser bastante danoso para a adoção da tecnologia, “então as fabricantes realmente precisam ter cuidado”.

Ética no volante?

Há quem acredite, no entanto, que esta questão de ética é secundária. “Isto se tornou um tema popular entre as pessoas que não trabalham nessa tecnologia”, diz Ragunathan Rajkumar, professor de engenharia elétrica e informática na Universidade Carnegie Mellon, à Scientific American. (Ele não esteve envolvido no estudo.)

Rajkumar lembra que veículos autônomos não tomam decisões da mesma forma que humanos: eles levam principalmente em conta a velocidade, condições meteorológicas, condições da estrada, e a distância em relação a objetos ao redor.

O desafio, então, é coletar e processar dados de forma rápida o suficiente para evitar uma situação perigosa; caso ela seja inevitável, Rajkumar acredita que o carro não vai decidir quem vive e quem morre.

Chris Urmson, que comanda o projeto de carros autônomos do Google, disse recentemente que existe uma hierarquia para evitar impactos: o veículo evita ao máximo pedestres e ciclistas; depois, objetos em movimento na estrada; e, por fim, objetos estáticos.

[Science via MIT News e Scientific American]

Primeira imagem por Iyad Rahwan. Colaborou: Felipe Ventura.