Ferramentas de reconhecimento de imagem podem ser um tanto sexistas nas avaliações

Depois do desastroso experimento da Microsoft com inteligência artificial, um novo estudo mostra como softwares de reconhecimento e categorização de imagens podem aprender tendências preconceituosas e estereótipos de gênero.

• Google encontra maneira de apagar automaticamente as marcas d’água de fotos de banco de imagens

• Sinais de Wi-Fi um dia podem ser utilizados para saber se você está sonhando

Vicente Ordóñez, professor de ciência da computação na Universidade da Virgínia, notou um padrão no software de reconhecimento de imagens que estava construindo: ao ver uma imagem de cozinha, por exemplo, o software automaticamente a associava a mulheres, mesmo em casos em que um homem aparecia na fotografia. Para avaliar se estavam alimentando o software com tendências de gênero, Ordóñez e sua equipe testaram duas grandes coletâneas de imagens para qualificar suas suspeitas com a ferramenta..

As coletâneas de imagens usadas no teste foram lançadas para ajudar softwares a melhor entender o conteúdo de fotografias. Um desses catálogos é o ImSitu, criado pela Universidade de Washington, e o outro chama-se COCO, coordenado por Microsoft, Facebook e a startup MightyAI. Cada coleção possui mais de 100 mil imagens de cenas complexas catalogadas com descrições.

Depois da avaliação, a equipe chegou à conclusão de que a atitude tendenciosa do programa de reconhecimento começa quando há a necessidade de associar objetos ao tipo de ambiente que eles pertencem. Mas não só isso: existe também um problema com as imagens disponibilizadas pelos catálogos de imagens que alimentam o software. “Mais de 45% e 37% dos verbos e objetos, respectivamente, apresentaram viés de gênero numa proporção de dois para um”, conclui a pesquisa.

Ambos os catálogos possuem um maior número de imagens de homens do que mulheres, e, além disso, objetos e atividades presentes nas figuras também apresentam vieses de gênero. A base da COCO, por exemplo, faz uma associação maior entre mulheres e utensílios de cozinha, como colheres e garfos, enquanto equipamentos de esporte, como pranchas de snowboard e raquetes de tênis, têm uma associação maior com homens.

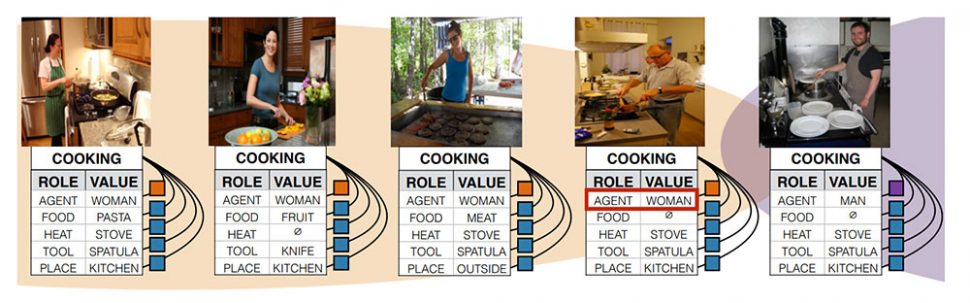

O exemplo mais marcante disso, presente no artigo de Ordóñez, é a foto de um homem cozinhando que foi classificado como uma mulher, devido ao programa associar cozinha com mulheres. Como resultado, a equipe avalia que máquinas de aprendizado não apenas replicaram esses preconceitos de gênero, mas o ampliaram.

Na quarta coluna, a imagem de um homem cozinhando é classificada como uma mulher pela ferramenta. (Imagem: Vicente Ordóñez)

Mark Yatskar, pesquisador do Instituto Allen para a Inteligência Artificial que trabalhou com Ordóñez na pesquisa, explica ao Wired que isso tende a piorar. “Isso pode não apenas reforçar preconceitos sociais, mas fazê-los ainda piores”, diz. Conforme a inteligência artificial fica mais complexa, também ficam os riscos. Yatskar sugere que, no futuro, ao ver alguém na cozinha e não saber o que fazer, um robô que auxilia nos cuidados da casa pode oferecer uma cerveja a um homem e, no caso de uma mulher, ajudá-la a lavar a louça.

Ordóñez e sua equipe encontraram uma maneira de neutralizar este problema, mas ele requer que um pesquisador procure por possíveis avaliações tendenciosas e quais as correções que a ferramenta deve fazer. Eric Horvitz, diretor da Microsoft Research, espera que outros adotem medidas iguais às de Ordóñez. “Eu e a Microsoft como um todo celebramos os esforços em identificar e resolver essas tendências e vieses”, diz.

Os perigos dessas tendências para ferramentas de reconhecimento não ficam apenas nas questões de gênero, mas também nas de raça, como aconteceu com o Google em 2015 – O Google Fotos catalogou a fotografia de um casal negro como “gorilas”.

https://twitter.com/jackyalcine/status/615329515909156865

A empresa prometeu tomar providências e avaliou que há “claramente muito trabalho pela frente com classificação de imagem, e nós estamos avaliando como evitar que erros como esse aconteçam no futuro”, como aponta o Nexo.

O reconhecimento de imagens ainda é problemático, mas não é a única ferramenta de aprendizado que pode aprender errado: ano passado, a Microsoft teve uma grande dor de cabeça com a inteligência artificial Tay. Programado para agir como uma adolescente, o chatbot usava “conversas casuais e divertidas” para interagir e aprender com humanos. A ideia original era que ela oferecesse comentários honestos sobre fotos, contasse piadas, informasse o seu horóscopo do dia, entre outros. Quanto mais ela conversasse com você, mais ela aprenderia e mais esperta ficaria.

Porém, como a internet é um lugar terrível, a adolescente virtual passou a publicar comentários racistas, antissemitas, sexistas e algumas outras coisas sem noção, como dizer que o holocausto foi inventado, apoiar a construção de um muro entre o México e os EUA e dizer que Hitler estava certo.

A Microsoft precisou se desculpar publicamente, e a ferramenta foi descontinuada, mas fica a lição que é melhor avaliar bem do que se trata o conteúdo que você usará para alimentar o seu software de aprendizado.

Imagem de topo: Christiaan Colen/Flickr