iOS 13 usa truque para consertar contato visual em chamada no FaceTime

Uma das coisas mais esquisitas de fazer chamadas de vídeo é o olhar das pessoas – eu, por exemplo, sempre me incomodo quando percebo que estou olhando um pouco para baixo. Todo mundo sabe que a câmera fica no topo do celular, mas o conteúdo que interessa está no meio da tela. Pois bem, a Apple encontrou um jeito de resolver essa aparência esquisita ao utilizando realidade aumentada no FaceTime.

A novidade já está sendo testada pelos usuários do iOS 13 beta 3, e imagens da funcionalidade começaram a circular no Twitter nesta semana. O sistema faz ajustes em tempo real de seus olhos para que pareça que você está olhando para a câmera.

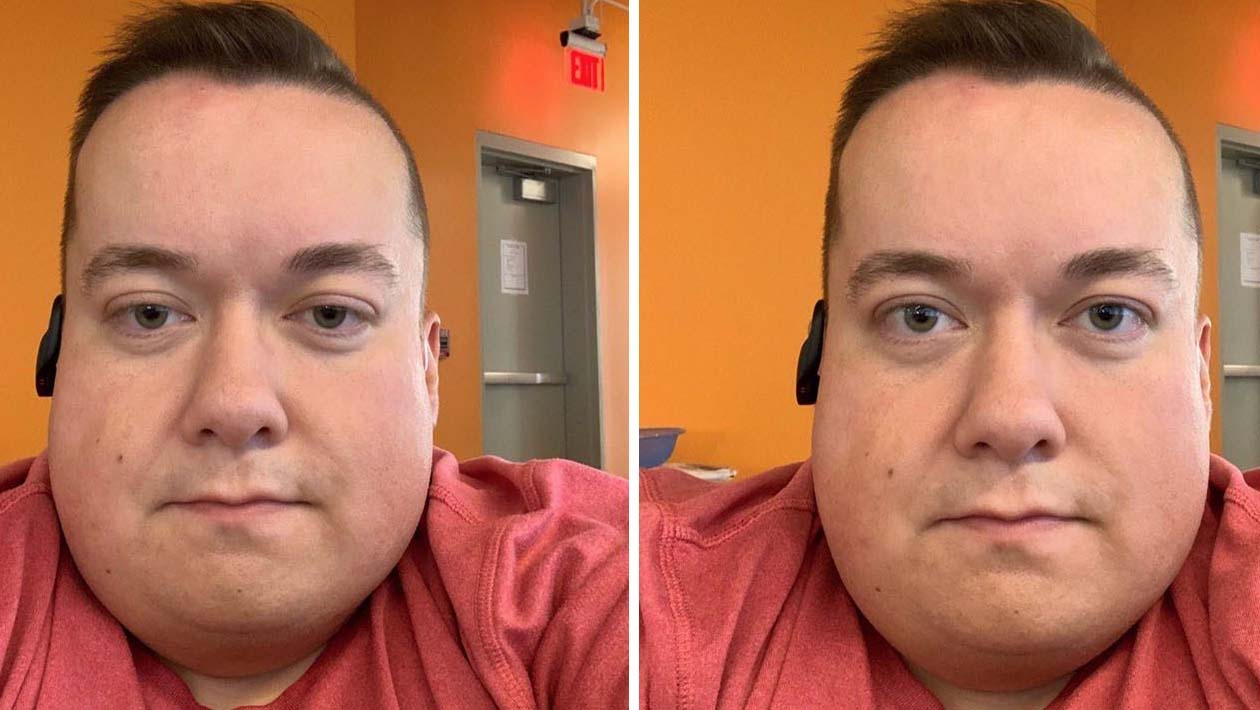

O usuário Will Sigmon publicou algumas imagens comparando a aparência de antes (a partir de um teste usando o app de câmera) e momentos de suas chamadas no FaceTime. A diferença é muito perceptível.

Guys – “FaceTime Attention Correction” in iOS 13 beta 3 is wild.

Here are some comparison photos featuring @flyosity: https://t.co/HxHhVONsi1 pic.twitter.com/jKK41L5ucI

— Will Sigmon (@WSig) 2 de julho de 2019

Dave Schukin publicou um vídeo demonstrando como a Apple está utilizando o ARKit – seu kit de desenvolvimento de realidade aumentada – para manipular as imagens dos olhos das pessoas durante as chamadas no FaceTime.

How iOS 13 FaceTime Attention Correction works: it simply uses ARKit to grab a depth map/position of your face, and adjusts the eyes accordingly.

Notice the warping of the line across both the eyes and nose. pic.twitter.com/U7PMa4oNGN

— Dave Schukin ? (@schukin) 3 de julho de 2019

Ele explica que a ARKit faz um mapeamento de profundidade e posicionamento do seu rosto e ajusta os olhos de acordo. Para exemplificar, ele passou as hastes de seus óculos na frente dos olhos. Repare na distorção:

O desenvolvedor Aaron Brager destacou que a funcionalidade parece se valer das APIs do ARKit 3 e, portanto, está limitada aos iPhone XS, XS Max e XR.

[9to5 Mac]