Você está usando redes neurais online todos os dias; saiba como elas funcionam

Se você tem o Google Fotos, utiliza a Cortana da Microsoft ou a função de tradução do Skype, usa diariamente uma forma de inteligência artificial. A IA foi inventada nos anos 50, mas apenas recentemente se tornou uma realidade prática – tudo graças a sistemas de software chamados redes neurais. É assim que eles funcionam.

Tornando os computadores mais inteligentes

Muitas coisas que os humanos acham difíceis podem ser feitas rapidamente por um computador. Deseja resolver uma equação diferencial parcial? Sem problemas. Que tal criar previsões meteorológicas precisas ou vasculhar a internet em busca de uma única página da web? Fácil, fácil. Mas peça a um computador que diga as diferenças entre pornô e arte renascentista? Ou se você acabou de dizer “bote” ou “mote”? Boa sorte com isso.

Os computadores simplesmente não conseguem raciocinar da mesma maneira que os humanos. Eles lutam para interpretar o contexto das situações do mundo real ou tomar as decisões diferenciadas que são vitais para realmente entender o mundo humano. É por isso que as redes neurais foram desenvolvidas nos anos 50 como solução potencial para esse problema.

Inspirando-se no cérebro humano, as redes neurais são sistemas de software que podem se treinar para dar sentido ao mundo humano. Eles usam diferentes camadas de processamento matemático para entender cada vez mais as informações que são alimentadas, da fala humana à imagem digital. Essencialmente, elas aprendem e mudam com o tempo. É por isso que eles fornecem aos computadores uma compreensão mais inteligente e diferenciada dos problemas que encontram. Mas levou muito tempo para que isso acontecesse.

O inverno das redes neurais

Na década de 1950, os pesquisadores não sabiam de que forma o cérebro humano era inteligente – ainda não sabemos, não exatamente – mas eles sabiam que era inteligente. Então, eles se perguntaram como o cérebro humano funciona, no sentido físico, e se poderia ser imitado para criar uma versão artificial dessa inteligência.

O cérebro é composto de bilhões de neurônios, células finas e longas que se ligam em uma rede, transmitindo informações usando cargas elétricas de baixa potência. De alguma forma, desse sistema biológico aparentemente simples, surge algo muito mais profundo: o tipo de mente que pode reconhecer rostos, desenvolver tratados filosóficos, resolver a física de partículas e muito mais. Se os engenheiros pudessem recriar esse sistema biológico eletronicamente, imaginaram os engenheiros, uma inteligência artificial também poderia surgir.

Houve alguns exemplos bem-sucedidos de redes neurais artificiais, como o Perceptron, de Frank Rosenblatt, que usava componentes elétricos analógicos para criar um classificador binário. É um nome empolado para um sistema que pode receber uma entrada – digamos, uma imagem de uma forma – e classificá-la em uma de duas categorias, como “quadrado” ou “não quadrado”. Mas os pesquisadores logo se depararam com barreiras. Primeiro, os computadores da época não tinham poder de processamento suficiente para lidar com muitos desses tipos de decisões. Segundo, o número limitado de neurônios sintéticos também limitava a complexidade das operações que uma rede poderia alcançar.

No caso do Perceptron de Rosenblatt, por exemplo, um único conjunto de neurônios artificiais foi capaz de discernir um quadrado de não quadrados. Mas se você quiser apresentar a capacidade de perceber algo mais sobre os quadrados – sejam vermelhos ou não vermelhos, por exemplo – você precisará de um conjunto extra.

Embora a biologia do cérebro possa ser simples no nível microscópico, no conjunto ela é incrivelmente complexa. E essa complexidade no nível macro era grande demais para os computadores da década de 1950. Como resultado, nas décadas seguintes, as redes neurais caíram em desuso. Tornou-se o “inverno das redes neurais”, como Jason Freidenfelds, do Google, descreveu para mim.

Avanços na neurociência

Mas o inverno de uma pessoa é o verão de outra. A partir da década de 1960, nossa compreensão do cérebro humano progrediu em saltos.

Naqueles primeiros dias da neurociência, grande parte do foco estava em nossos sistemas visuais. Charles Cadieu, um professor afiliado de Pesquisa do MIT, explica:

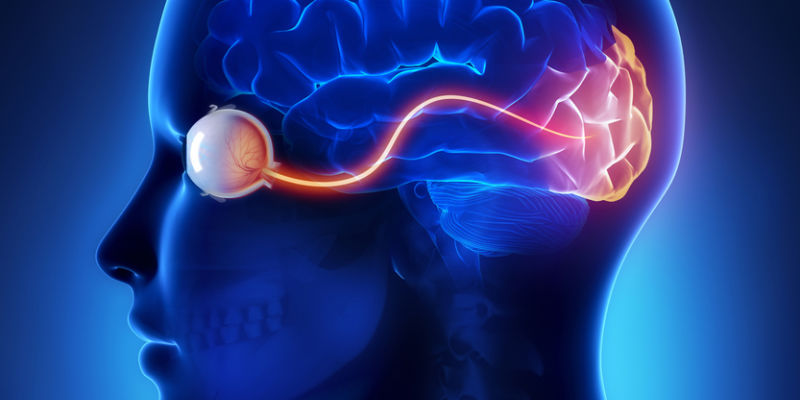

É provavelmente a modalidade sensorial mais compreendida e provavelmente a parte mais compreendida do cérebro. Já sabemos há décadas que os neurônios disparam de maneira diferente à medida que você passa pelo fluxo visual. Na retina, os neurônios são receptivos a pontos de luz e escuridão; no córtex visual primário, há excitação dos neurônios por formas semelhantes a arestas; e nas áreas mais altas do córtex visual, os neurônios respondem a rostos, mãos… todo tipo de objetos complexos, naturais e artificiais. De fato, lá em cima, os neurônios não respondem a manchas claras e escuras ou a características semelhantes a bordas.

Imagem de CLIPAREA l Mídia personalizada/Shutterstock

Acontece que diferentes partes da rede biológica do cérebro são responsáveis por diferentes aspectos do que conhecemos como reconhecimento visual. E essas partes são organizadas hierarquicamente.

Isso também se aplica a outros aspectos da cognição. Partes do cérebro que processam a fala e talvez até a própria linguagem parecem funcionar da mesma maneira. Uma hierarquia de diferentes níveis neurais fornece sua própria percepção e depois a repassa para outro nível, mais elevado, para fazer um julgamento de nível superior. Em cada estágio, o raciocínio se torna mais abstrato, permitindo que uma série de sons seja reconhecida como uma palavra que significa algo para nós, ou que um conjunto de padrões claros e escuros em nossa retina seja renderizado como “gato” em nosso cérebro.

Esses tipos de hierarquias foram uma pista crucial para os pesquisadores que ainda ousavam pensar em redes neurais artificiais. “Isso tem sido realmente uma luz orientadora para as redes neurais”, explica Cadieu. “Nós apenas não sabíamos como fazê-los se comportar dessa maneira”.

Software biologicamente inspirado

Na verdade, as redes artificiais em uso atualmente não usam realmente o cérebro como modelo da maneira que os pioneiros no campo podem ter esperado. Eles são “apenas vagamente inspirados no cérebro”, analisa Cadieu, no sentido de que são realmente sistemas de software que empregam uma abordagem em camadas para desenvolver a compreensão, em vez de serem uma rede de nódulos que passam informações entre si.

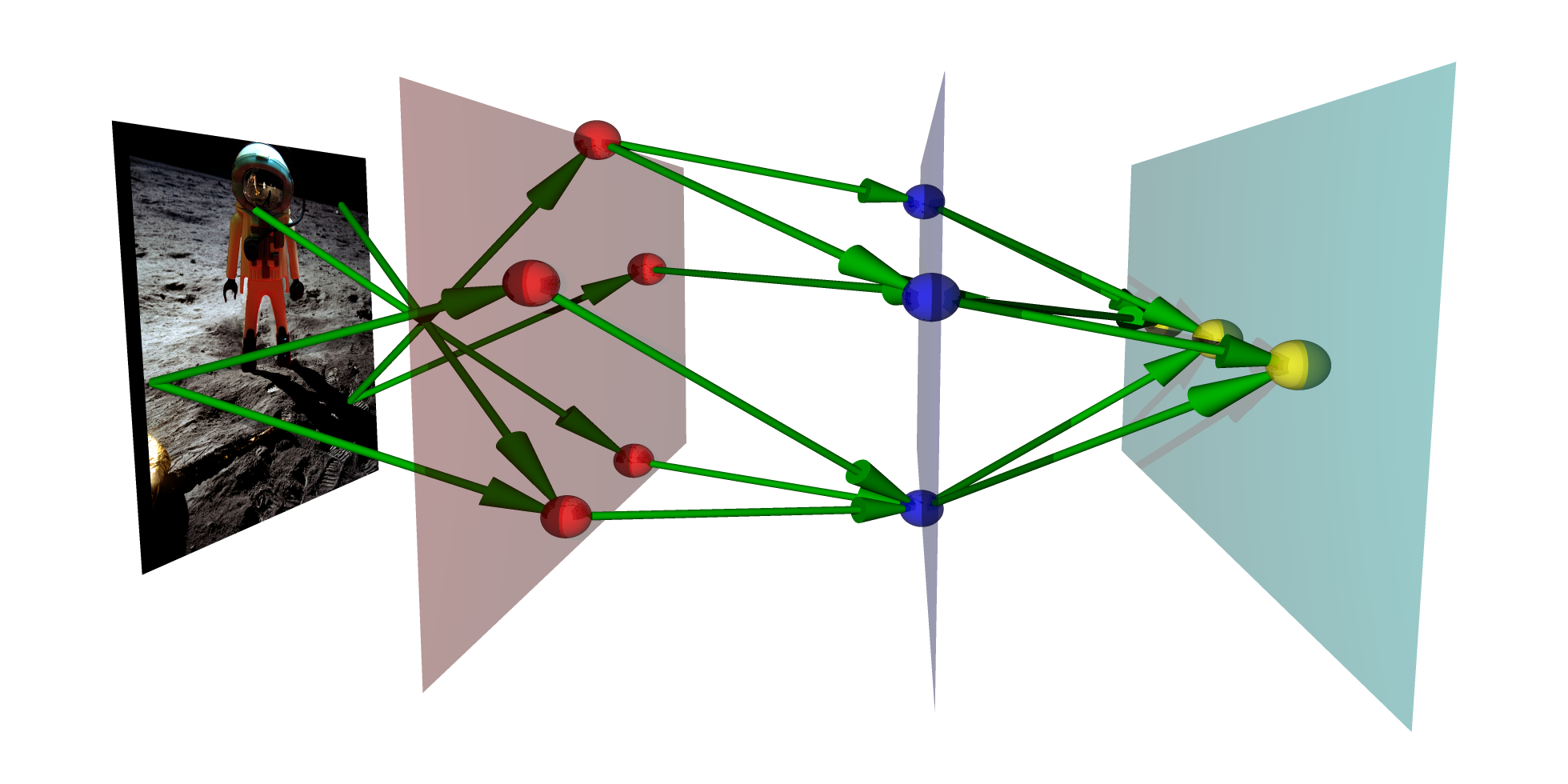

Esses sistemas de software usam um algoritmo para processar informações sobre uma entrada e, em seguida, transmitem-na para a próxima camada para processar usando um algoritmo diferente para obter um entendimento de nível superior e assim por diante. Em outras palavras, faz mais sentido pensar em redes neurais artificiais como equações matemáticas em cascata que podem detectar características e padrões distintos, de acordo com Freidenfelds.

No caso do reconhecimento de imagem, por exemplo, a primeira camada de uma rede neural pode analisar o brilho dos pixels, antes de passar para um segundo para identificar bordas e linhas formadas por tiras de pixels semelhantes. As próximas camadas podem ser capazes de identificar formas e texturas e, posteriormente, na cadeia, podem identificar o agrupamento de algumas dessas imagens abstratas como recursos de um objeto real, como olhos ou rodas.

Então, no final, o agrupamento desses recursos de níveis mais altos pode ser interpretado como objetos reais: dois olhos, um nariz e uma boca podem formar um rosto humano, por exemplo, enquanto rodas, um assento e um guidão se assemelham a uma bicicleta. Em uma conferência de desenvolvedores em maio, o Google anunciou que as redes neurais que alimentam seus produtos como o Google Fotos agora usam 30 camadas diferentes ao total para entender as imagens.

Imagem de fdecomite sob licença Creative Commons.

As redes neurais não se restringem apenas ao reconhecimento de imagens, embora esse seja o nosso uso mais avançado atualmente. No caso de algo como reconhecimento de fala, a rede neural divide a fala que está ouvindo em segmentos curtos e depois identifica os sons das vogais. As camadas subsequentes podem determinar como os diferentes sons das vogais se encaixam para formar palavras, as palavras se encaixam para formar frases e, finalmente, inferir significado do que você acabou de murmurar ao telefone.

Como você provavelmente pode perceber, este é um grande passo em relação ao sistema Perceptron de camada única – um grande passo. De fato, esse tempo todo havia duas coisas que impediam a implementação bem-sucedida de redes neurais. O primeiro era o poder computacional, que temos agora. O segundo? Informações suficientes para ensinar as coisas a funcionar corretamente.

Backpropagation e aprendizado profundo

As redes neurais não conseguem aprender até que você jogue dados suficientes nelas. Eles precisam de grandes quantidades de informações para considerar, passar por suas camadas e tentar classificar. Então, elas podem comparar suas classificações às respostas reais e se congratular ou se esforçar um pouco.

No caso da análise de imagem, isso significa fornecer à sua rede neural uma série de fotos marcadas, conhecidas como conjunto de treinamento. O Google usou o YouTube para fornecer esse conjunto de treinamento no passado. No caso do reconhecimento de fala, o conjunto de treinamento pode ser uma série de clipes de áudio junto com uma descrição do que está sendo dito.

Guarnecida com essa enorme quantidade de informações, a rede neural fará uma tentativa de classificar cada item, reunindo as informações que pode de suas várias camadas para fazer suposições sobre o que está vendo ou ouvindo. Durante o treinamento, a resposta da máquina é comparada à descrição criada pelo homem do que deveria ter sido observado. Se estiver certo, parabéns para as redes.

Mas e se estiver errado?

“Se o que acabou de analisar era um rosto e na verdade era uma casa, então usa uma técnica chamada backpropagation para se ajustar”, explica Cadieu. “Ele retrocede cada uma das camadas anteriores e cada vez que ajusta a expressão matemática para essa camada, apenas o suficiente para que a resposta seja correta da próxima vez”.

A princípio, a rede comete erros o tempo todo, mas gradualmente seu desempenho melhora, as camadas se tornam cada vez mais capazes de discernir exatamente o que veem. Esse processo iterativo de passar uma amostra pela rede e voltar atrás para se corrigir é conhecido como aprendizado profundo, e é o que imbui as redes com inteligência semelhante à humana.

No passado, era difícil reunir informações suficientes para alimentar algo tão faminto por dados quanto uma rede neural. Mas hoje em dia existem tantos dados circulando online que é relativamente simples. Há imagens postadas em toda a Internet com legendas que descrevem exatamente – ou pelo menos, exatamente o bastante – o que o computador deve ver, ou dialogos com filmes e scripts correspondentes para ajudar os sistemas de reconhecimento de fala a aprender como os seres humanos soam. E armadas com todos esses dados, as redes neurais podem se tornar cada vez mais inteligentes.

Uma inteligência de fato?

E está funcionando. Quando o Google lançou o seu primeiro sistema de reconhecimento de voz baseado em rede neural em 2011 – que se assemelha ao Now e ao usado no Chrome – havia uma taxa de erro de cerca de 25%. Isso significa que ele não funcionou uma em cada quatro vezes que você o usou.

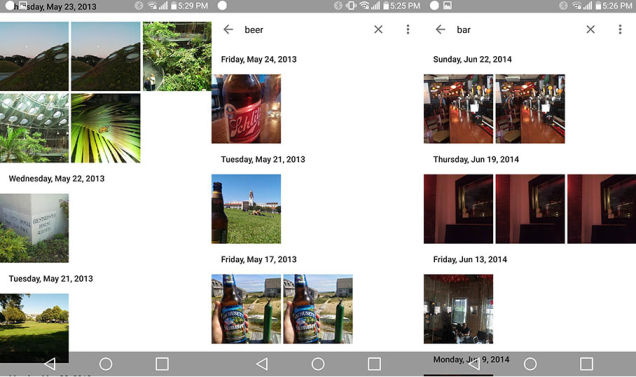

Agora, depois de três anos de ajustes e aprendizado, caiu para apenas 8%. A tentativa mais recente do Google de mostrar o poder das redes neurais é com o Photos, que é quase assustador em sua inteligência.

Quando Mario Aguilar, do Gizmodo, tentou pela primeira vez, ele explicou:

É uma loucura o quão bem isso funciona. Assustador mesmo. Primeiro ficamos surpresos, depois suspeitos. Estávamos trabalhando apenas com um pequeno número de fotos que tenho atualmente neste telefone… [mas] apesar do número limitado de pessoas, o Google Fotos conseguiu realmente entender do que eu tirei fotos. Ele identificou corretamente um dos meus melhores amigos de quem tenho muitas fotos como pessoa única… Mas onde o Photos realmente destrói seu cérebro é quando você começa a procurar coisas aleatórias em sua coleção. Cervejas? Encontra fotos de cervejas. Bares? Encontra fotos de bares.

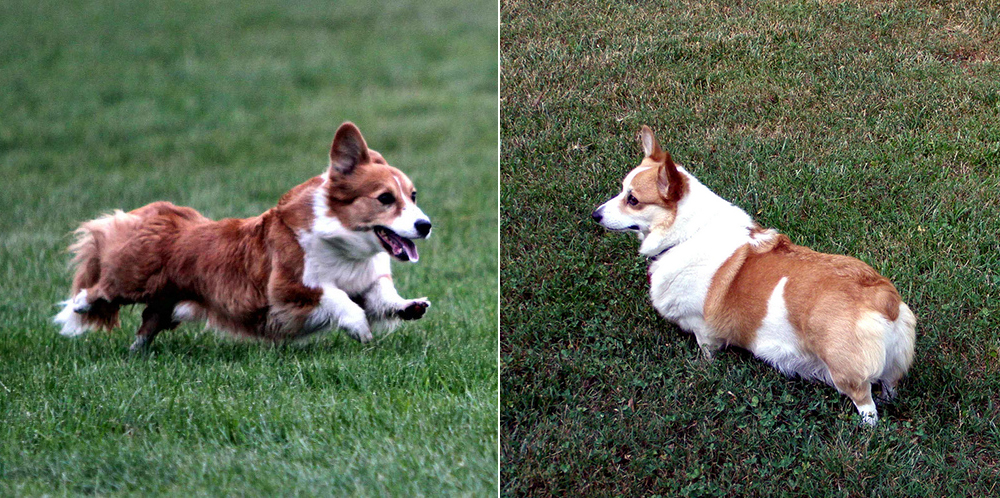

Não é apenas o Google, no entanto. Há alguns anos, o Facebook lançou seu algoritmo DeepFace, que pode reconhecer rostos humanos específicos com 97% de precisão. Isso é tão bom quanto um humano. A Wolfram Alpha criou um sistema de software que pode identificar objetos e até permite que você o inclua no seu próprio software. E o assistente pessoal digital Cortana da Microsoft é tão nítido que pode reconhecer a diferença entre a foto de um Pembroke Welsh Corgi e um Cardigan Welsh Corgi. Você consegue reconhecer as diferenças entre um Pembroke Welsh Corgi e um Cardigan Welsh Corgi? Eu com certeza não posso.

Imagem de Virginia Hill e Tundra Ice. O Cardigan Welsh Corgi está à esquerda

E nem tudo é reconhecimento de imagem. O Skype agora usa redes neurais para traduzir de um idioma para outro em tempo real; A empresa de pesquisa chinesa Baidu os usa para segmentar anúncios em seu mecanismo de pesquisa; e, há um tempo, o Google lançou um sistema de chatbot treinado para usá-los.

As redes neurais estão finalmente dando aos computadores a capacidade de entender o mundo humano e fazer inferências inteligentes sobre ele. E eles fazem isso com tanta eficiência hoje em dia que conseguem até criar arte psicodélica no processo.

Ciência imperfeita e gorillagate

Mas, como qualquer coisa “inteligente”, as redes neurais podem errar, e erram. Apenas neste mês, o aplicativo Fotos do Google identificou por engano duas pessoas negras em uma fotografia como “gorilas”. Uma ferramenta de reconhecimento de imagem do Flickr, alimentada pela rede neural do Yahoo, também marcou um homem negro como um “macaco”. Claramente, nenhum deles é perfeito e pode refletir as maneiras (racistas) pelas quais os humanos marcaram imagens em dados públicos. A solução rápida do Google, ao que parece, foi simplesmente remover completamente a tag “gorila” das Fotos; a longo prazo, sem dúvida, treinará mais fortemente suas redes.

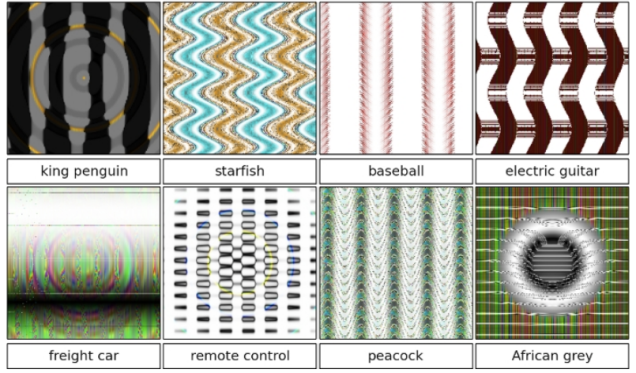

É fácil apontar o dedo para a tecnologia por não estar totalmente preparada. Certamente, é possível enganar uma rede neural. As imagens abaixo, por exemplo, são suficientes para induzir as redes neurais a pensar que veem pinguins, bolas de beisebol e controles remotos, mas, para os seres humanos, parecem apenas padrões abstratos, embora inspirados por objetos reais.

“A confusão do algoritmo é devido a diferenças na forma como vê o mundo em comparação com os seres humanos”, disse Jeff Clune, da Universidade de Wyoming, em Laramie, que descobriu essa peculiaridade, à New Scientist. “Enquanto [os seres humanos] identificam um guepardo procurando o pacote inteiro – a forma correta do corpo, os padrões e assim por diante -, uma [rede neural] está interessada apenas nas partes de um objeto que mais o distingue dos outros”.

Obviamente, não ajuda que as redes neurais não tenham o senso interno de decoro e cautela que os humanos têm. Como uma criança que deixa escapar o que quer que brote na sua mente, as redes neurais ansiosamente fornecem seu melhor palpite, na esperança de que esteja correto – mesmo que não tenham 100% de certeza. Nesses casos, um humano pode se opor; talvez uma rede neural deva aprender a fazer o mesmo.

O gorillagate pode ter tanto a ver com o viés humano quanto a tecnologia falha. Em entrevista ao Wall Street Journal, Vivienne Ming, especialista em inteligência artificial, apontou que talvez os culpados sejam os conjuntos de treinamento usados pelo Google. As incontáveis fotografias na internet exibem um mundo predominantemente branco, por isso é plausível que as redes neurais simplesmente não tenham a experiência necessária para identificar pessoas negras com precisão.

Poder em números

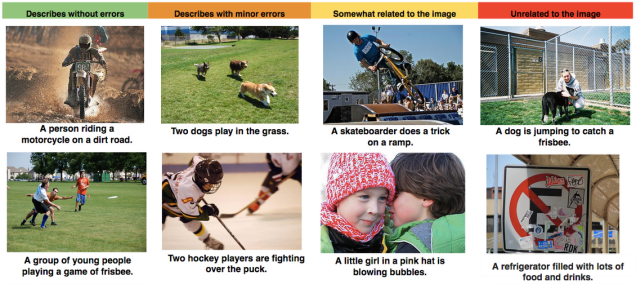

Além de fornecer dados precisos às redes neurais, os pesquisadores também estão melhorando o software combinando redes. Uma colaboração de pesquisa entre o Google e a Universidade de Stanford começou a produzir software que pode realmente descrever cenas inteiras, em vez de apenas identificar um objeto, como um gato.

Esse feito francamente notável é alcançado pela combinação de uma rede neural de reconhecimento de imagem com uma rede de linguagem natural. Dê a uma rede de linguagem natural uma frase completa como “Sentamos para um delicioso almoço de sanduíches”, e ela a abstrai em conceitos de alto nível, como “comer” e “sanduíches”. A partir daí, a saída pode ser inserida em outra rede de processamento de linguagem natural que possa dar sentido a esses conceitos e traduzi-la em uma frase que diz a mesma coisa, usando palavras diferentes.

É assim que as redes neurais usadas pelo Skype trabalham para fazer sua tradução instantânea. O que os pesquisadores de Stanford e Google fizeram, no entanto, foi substituir a primeira rede neural por uma rede de reconhecimento de imagem e inseri-la em uma rede de idioma natural em inglês. O primeiro produz conceitos de alto nível do que é retratado na imagem – digamos, um homem, um sanduíche e comida. No segundo, as tentativas de converter esses conceitos em uma frase que descreve o que é mostrado, como “Um homem está comendo um sanduíche”. Como você pode ver no gráfico abaixo, os resultados não são perfeitos – mas são certamente impressionantes.

Então, se as redes neurais estão se desenvolvendo tão rapidamente, o céu é o limite?

“Você certamente pode esperar ver grandes melhorias no reconhecimento de imagem e fala nos próximos anos”, diz Cadieu, apontando que essas redes neurais modernas só existem há alguns anos.

Quanto ao processamento de linguagem, é menos claro que as redes neurais serão capazes de lidar com os problemas tão bem. Embora o reconhecimento de imagem e fala funcione definitivamente em camadas como as redes neurais modernas, há menos evidências neurocientíficas que sugerem que a linguagem é processada da mesma maneira, de acordo com Cadieu. Isso pode significar que o processamento artificial da linguagem logo encontrará barreiras conceituais.

Rumo a uma IA da classe trabalhadora

Uma coisa é clara: esses tipos de inteligências artificiais já estão dando uma enorme ajuda aos seres humanos. No passado, você tinha que vasculhar suas fotografias para compilar um álbum das suas últimas férias ou encontrar a foto do seu amigo João bebendo uma cerveja. Hoje, porém, o software de rede neural pode fazer isso por você. O Google Fotos prepara álbuns automaticamente, e sua função de pesquisa inteligente encontrará imagens com uma precisão alarmante.

E esse tipo de software focado no consumidor é um mero truque comparado aos feitos que as redes neurais poderiam um dia realizar por nós.

Não é difícil imaginar algoritmos de processamento de imagens ganhando inteligência suficiente para examinar imagens médicas de tumores, com os médicos apenas verificando seus resultados. Os sistemas de reconhecimento de voz podem se tornar tão avançados que as campanhas de telemarketing serão executadas apenas por software. As redes de processamento de idiomas permitirão que as notícias sejam escritas por máquina.

De fato, todas essas coisas já estão acontecendo, até certo ponto. As mudanças são profundas o suficiente para que os pesquisadores da Universidade de Oxford calculem que até metade dos empregos, incluindo o que você possui, será perdido para sistemas de IA alimentados por redes neurais nos próximos anos.

Mas as mudanças nas economias e no emprego foram impulsionadas pela tecnologia muitas vezes antes, desde a impressora e o automóvel, até os computadores e a Internet. Embora haja agitação social, também haverá benefícios. Em última análise, as redes neurais darão a todos acesso à inteligência que atualmente está nas mãos de poucos. E isso levará a sistemas mais inteligentes, melhores serviços e mais tempo para resolver os problemas humanos que os computadores nunca serão capazes de corrigir.